Künstliche Intelligenz: Eine Technologieblase kurz vor dem Platzen? 🫧

Veröffentlicht von Adrien,

Quelle: The Conversation unter Creative Commons-Lizenz

Andere Sprachen: FR, EN, ES, PT

Quelle: The Conversation unter Creative Commons-Lizenz

Andere Sprachen: FR, EN, ES, PT

Zwischen Optimismus, Übermedialisierung, der Erkenntnis ihrer Grenzen und Enttäuschungen haben Systeme der künstlichen Intelligenz bisher nur begrenzte Auswirkungen.

Die künstliche Intelligenz (KI) wird oft als die nächste Revolution dargestellt, die unser Leben grundlegend verändern wird. Seit der Einführung von ChatGPT im Jahr 2022 haben generative KI-Systeme weltweit für großes Aufsehen gesorgt. Im Jahr 2023 hat NVidia, ein Schlüsselakteur bei der Herstellung von Chips, die für das Training von KI-Modellen verwendet werden, eine Börsenbewertung von über 1.000 Milliarden Dollar erreicht. Und im darauffolgenden Jahr wird sie die Marke von 3.000 Milliarden Dollar überschreiten.

Doch dieser Enthusiasmus wird von Zweifeln begleitet. Denn obwohl die KI im Rampenlicht der Medien steht, bleibt ihre konkrete wirtschaftliche Auswirkung bescheiden und ihre Einführung in Unternehmen begrenzt. Eine aktuelle Studie schätzt, dass nur etwa 5 % der Unternehmen aktiv KI-Technologien in ihren Prozessen einsetzen, sei es generative KI, prädiktive Analysen oder Automatisierungssysteme. In einigen Fällen wird der KI sogar vorgeworfen, die Aufmerksamkeit der Führungskräfte von dringlicheren operativen Herausforderungen abzulenken.

Diese Diskrepanz zwischen Erwartungen und konkreten Ergebnissen wirft die Frage auf: Befindet sich die KI einfach in einem „Hype-Zyklus“, in dem übermäßiger Enthusiasmus schnell von Enttäuschung gefolgt wird, wie wir es seit den 90er Jahren bei anderen Technologien beobachten konnten? Oder erleben wir einen echten Rückgang des Interesses an dieser Technologie?

Von den Anfängen der KI bis zu ChatGPT: Wellen des Optimismus und der Skepsis

Die Geschichte der KI ist geprägt von Zyklen des Optimismus und des Skeptizismus. Bereits in den 50er Jahren stellten sich Forscher eine Zukunft vor, in der Maschinen denken und Probleme ebenso effektiv wie Menschen lösen könnten. Dieser Enthusiasmus führte zu ehrgeizigen Versprechen, wie der Schaffung von Systemen, die automatisch jede Sprache übersetzen oder die menschliche Sprache perfekt verstehen könnten.

Doch diese Erwartungen erwiesen sich angesichts der technologischen Grenzen der damaligen Zeit als unrealistisch. So führten die ersten Enttäuschungen zu den „KI-Wintern“ Ende der 70er und Ende der 80er Jahre, in denen die Finanzierung aufgrund der Unfähigkeit der Technologien, die gestellten Versprechen zu erfüllen, stark zurückging.

Doch die 90er Jahre markierten einen wichtigen Wendepunkt dank drei Schlüsselelementen: der Explosion von Big Data, der Steigerung der Rechenkapazitäten und der Entwicklung leistungsfähigerer Algorithmen. Das Internet ermöglichte die massive Sammlung von Daten, die für das Training von Machine-Learning-Modellen unerlässlich sind. Diese großen Datensätze sind entscheidend, da sie die notwendigen Beispiele liefern, damit die KI „lernen“ und komplexe Aufgaben bewältigen kann. Gleichzeitig haben Fortschritte in der Prozessortechnik die Ausführung fortschrittlicher Algorithmen wie tiefer neuronaler Netze ermöglicht, die die Grundlage des Deep Learning bilden. Sie haben die Entwicklung von KI-Systemen ermöglicht, die Aufgaben bewältigen können, die früher unerreichbar schienen, wie die Bilderkennung und die automatische Texterstellung.

Diese gesteigerten Fähigkeiten haben die Hoffnung auf die von den Pionieren des Feldes vorhergesagte Revolution wiederbelebt, mit allgegenwärtigen und effizienten KI-Systemen für eine Vielzahl von Aufgaben. Doch sie bringen auch große Herausforderungen und Risiken mit sich, die den Enthusiasmus um die KI zu dämpfen beginnen.

Eine zunehmende Erkenntnis der technischen Grenzen, die die Zukunft der KI belasten

In jüngster Zeit haben aufmerksame Beobachter der KI-Entwicklung die Grenzen der aktuellen Systeme erkannt, die deren Einführung bremsen und die erwarteten Ergebnisse begrenzen können.

Erstens werden Deep-Learning-Modelle oft als „Black Boxes“ bezeichnet, da ihre Komplexität ihre Entscheidungen schwer erklärbar macht. Diese Undurchsichtigkeit kann das Vertrauen der Nutzer verringern und die Einführung aus Angst vor ethischen und rechtlichen Risiken einschränken.

Algorithmische Verzerrungen stellen ein weiteres großes Problem dar. Die heutigen KI-Systeme verwenden enorme Datenmengen, die selten frei von Verzerrungen sind. So reproduzieren die KI-Systeme diese Verzerrungen in ihren Ergebnissen, wie beispielsweise beim Rekrutierungsalgorithmus von Amazon, der systematisch Frauen benachteiligte. Mehrere Unternehmen mussten aufgrund von in ihren Systemen festgestellten Verzerrungen zurückrudern. So zog Microsoft seinen Chatbot Tay zurück, nachdem er hasserfüllte Äußerungen generiert hatte, während Google sein Gesichtserkennungstool aussetzte, das bei farbigen Personen weniger effektiv war.

Diese Risiken machen einige Unternehmen zögerlich, diese Systeme einzusetzen, aus Angst, ihren Ruf zu schädigen.

Der ökologische Fußabdruck der KI ist ebenfalls besorgniserregend. Fortschrittliche Modelle erfordern viel Rechenleistung und verursachen einen massiven Energieverbrauch. Beispielsweise würde das Training großer Modelle wie GPT-3 so viel CO₂ ausstoßen wie fünf Hin- und Rückflüge zwischen New York und San Francisco. In einem Kontext des Kampfes gegen den Klimawandel stellt dies die Sinnhaftigkeit eines großflächigen Einsatzes dieser Technologien in Frage.

Insgesamt erklären diese Grenzen, warum einige anfängliche Erwartungen, wie das Versprechen einer umfassenden und zuverlässigen Automatisierung, nicht vollständig erfüllt wurden und auf konkrete Herausforderungen stoßen, die den Enthusiasmus für die KI dämpfen könnten.

Hin zu einer gemäßigten und regulierten Einführung der KI?

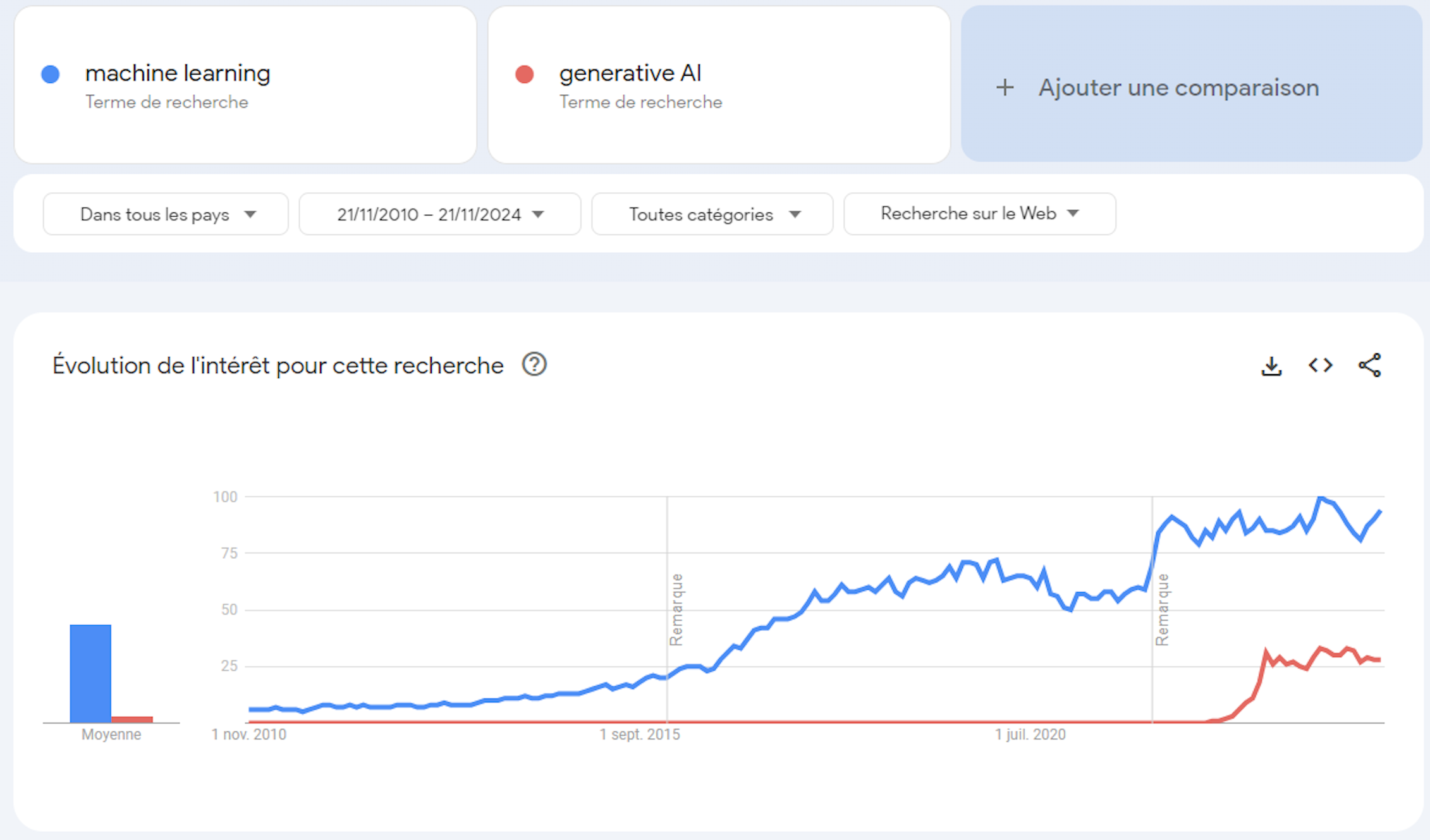

Die KI, die bereits fest in unserem Alltag verankert ist, scheint zu etabliert, um zu verschwinden, was einen „KI-Winter“ wie in den 70er und 80er Jahren unwahrscheinlich macht. Statt eines dauerhaften Rückgangs dieser Technologie sprechen einige Beobachter eher von der Entstehung einer Blase. Die Ankündigungseffekte, verstärkt durch die wiederholte Verwendung des Begriffs „Revolution“, haben tatsächlich zu einem oft überzogenen Hype und zur Bildung einer gewissen Blase beigetragen. Vor zehn Jahren war es das Machine Learning; heute ist es die generative KI. Unterschiedliche Konzepte wurden nacheinander populär gemacht, von denen jedes eine neue technologische Revolution versprach.

Google Trends.

Doch die modernen KI-Systeme sind weit davon entfernt, eine „Revolution“ zu sein: Sie stehen in der Kontinuität früherer Forschungen, die die Entwicklung ausgefeilterer, effizienterer und nützlicherer Modelle ermöglicht haben.

Doch diese Ausgereiftheit hat einen praktischen Preis, der weit von den lautstarken Ankündigungen entfernt ist. Tatsächlich erklärt die Komplexität der KI-Modelle teilweise, warum so viele Unternehmen die Einführung der KI schwierig finden. Oft groß und schwer zu beherrschen, erfordern KI-Modelle spezielle Infrastrukturen und seltene Expertise, die besonders kostspielig sind. Die Einführung von KI-Systemen kann daher kostspieliger als vorteilhaft sein, sowohl finanziell als auch energetisch. Es wird geschätzt, dass ein Algorithmus wie ChatGPT bis zu 700.000 Dollar pro Tag kostet, aufgrund der immensen Rechen- und Energieressourcen, die erforderlich sind.

Hinzu kommt die regulatorische Frage. Prinzipien wie die Minimierung der Sammlung personenbezogener Daten, wie sie die DSGVO vorschreibt, widersprechen dem Wesen der heutigen KI. Der AI Act, der seit August 2024 in Kraft ist, könnte ebenfalls die Entwicklung dieser ausgefeilten Systeme in Frage stellen. Es wurde gezeigt, dass KI-Systeme wie GPT-4 von OpenAI oder PaLM2 von Google 12 Schlüsselanforderungen dieses Gesetzes nicht erfüllen. Diese Nichtkonformität könnte die derzeitigen Entwicklungsmethoden der KI in Frage stellen und somit deren Einsatz beeinträchtigen.

All diese Gründe könnten dazu führen, dass diese KI-Blase platzt, was uns dazu veranlasst, die übertriebene Darstellung ihres Potenzials in den Medien zu überdenken. Es ist daher notwendig, einen differenzierteren Ansatz zu verfolgen, indem die Diskussionen auf realistischere und konkretere Perspektiven ausgerichtet werden, die die Grenzen dieser Technologien anerkennen.

Dieses Bewusstsein sollte uns auch zu einer gemäßigteren Entwicklung der KI führen, mit Systemen, die besser an unsere Bedürfnisse angepasst und weniger riskant für die Gesellschaft sind.