Restez toujours informé: suivez-nous sur Google Actualités (icone ☆)

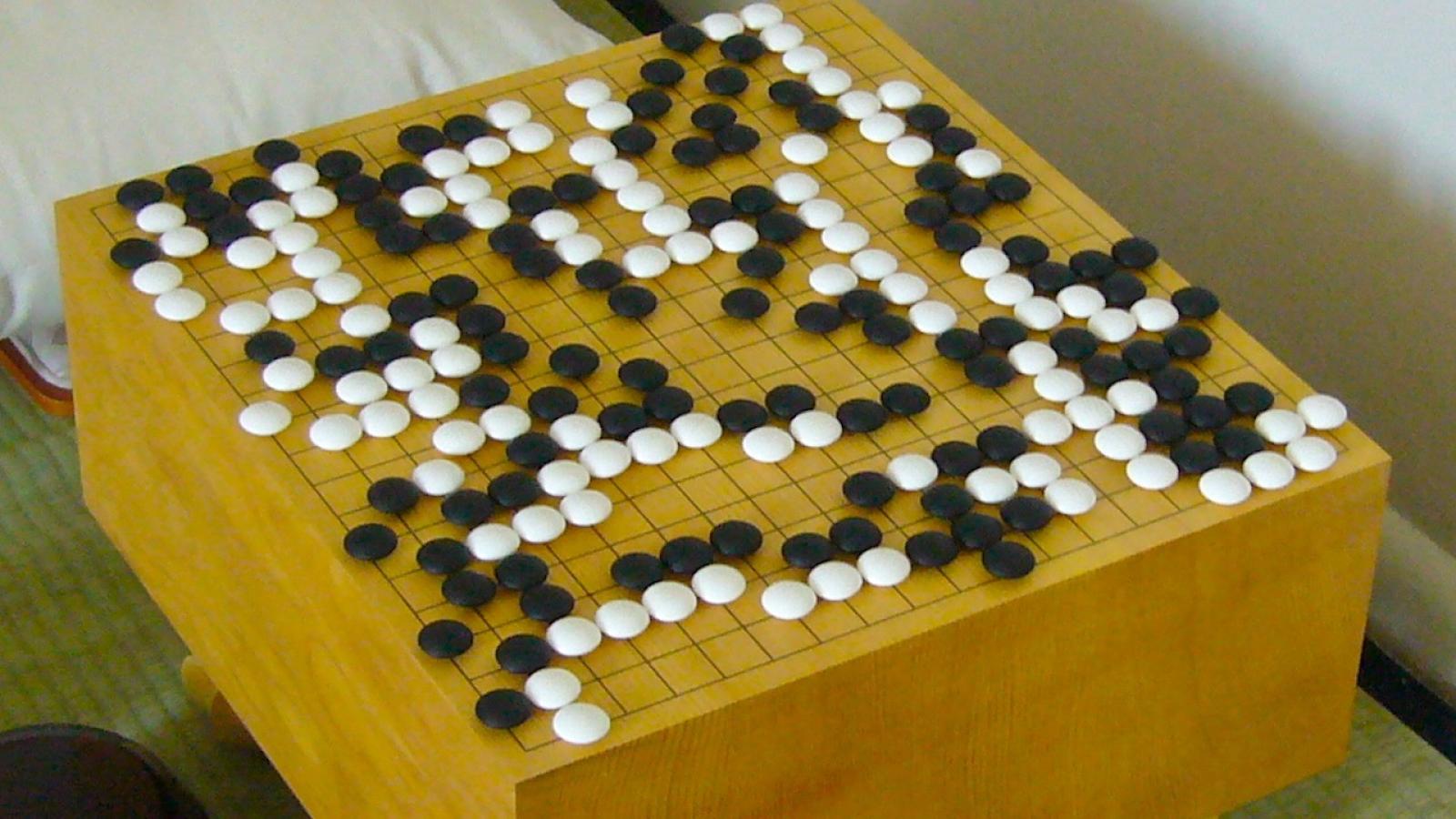

Le jeu de Go étant considéré le plus complexe des jeux inventés par des humains, le choc avait été grand à l'époque: autant chez les amateurs de cette compétition, que chez ceux qui s'attendent à ce que les robots dominent tôt ou tard le monde. Déjà, en 1997, l'ordinateur Deep Blue d'IBM avait mis à mal l'amour-propre des humains en battant le champion du monde des échecs Garry Kasparov: le Go restait donc le dernier rempart, du moins à ce qu'on disait.

Mais une analyse, par des chercheurs de Hong Kong, de 5,8 millions de mouvements réalisés par des joueurs professionnels entre 1950 et 2021, révèle une amélioration de ce que ces chercheurs ont appelé "l'indice de qualité des décisions". Ils ont notamment qualifié un mouvement "d'original" s'il n'a pas été précédemment tenté en combinaison avec les mouvements précédents. Et le résultat de leur analyse, c'est que les humains ont fait davantage de mouvements originaux et de meilleure qualité depuis 2016.

Entre 1950 et 2015, l'évolution annuelle de leur indice de qualité oscillait entre une légère baisse de 0,2 et une légère hausse de 0,2. Entre 2018 et 2021, il augmente subitement de 0,7. Concrètement, cela se traduit par 88% des matchs joués en 2018 qui montraient des stratégies dites "originales", contre 63% avant 2015.

Il faut savoir que, comparativement aux échecs, le Go, dont le but est d'encercler plus de territoire que l'adversaire, offre beaucoup plus de scénarios possibles pour chaque mouvement: le plateau est plus large et les parties durent plus longtemps. Et c'est la raison, selon les chercheurs, pour laquelle les humains auraient encore de l'espace pour s'améliorer. Dans leur analyse, parue le 13 mars dans la revue PNAS, ils citent l'ancien champion du monde Sedol Lee, qui avait déclaré après sa défaite en 2016, que celle-ci l'avait amené à s'interroger sur "la créativité humaine": le style de l'IA -l'AlphaGo de Google- "était différent, et c'était une expérience si inhabituelle qu'il m'a fallu du temps pour m'ajuster. AlphaGo m'a fait réaliser que je devais étudier le Go davantage."

Et c'est ce qui se serait passé depuis 2017, croient les chercheurs. Ayant l'occasion de s'entraîner avec des robots, eux-mêmes "sur-entraînés" grâce aux nouvelles capacités acquises par AlphaGo, les humains ont développé de nouvelles stratégies et de nouveaux mouvements. "Nos découvertes suggèrent que le développement de ces programmes" (appelés, sans fausse modestie, programmes d'IA surhumains), peut avoir "poussé les joueurs humains à s'éloigner des stratégies traditionnelles et les avoir conduits à explorer des mouvements originaux, ce qui en retour peut avoir amélioré leur processus de décision."

En d'autres termes, l'humain deviendrait donc meilleur... mais avec un coup de pouce de l'IA.