Zwei Arten künstlicher Neuronen zur Nachahmung des Gehirns 💡

Veröffentlicht von Adrien,

Quelle: The Conversation unter Creative Commons-Lizenz

Andere Sprachen: FR, EN, ES, PT

Quelle: The Conversation unter Creative Commons-Lizenz

Andere Sprachen: FR, EN, ES, PT

Das Gehirn bleibt der König der Computer. Die raffiniertesten Maschinen, die ihm nachempfunden sind, sogenannte "neuromorphische" Systeme, umfassen heute bis zu 100 Millionen Neuronen, so viele wie das Gehirn eines kleinen Säugetiers.

Diese Netzwerke aus künstlichen Neuronen und Synapsen bilden die Grundlage der künstlichen Intelligenz. Man kann sie auf zwei Arten emulieren: entweder mit Computersimulationen oder mit elektronischen Komponenten, die biologische Neuronen und Synapsen nachbilden und zu „Neuroprozessoren” zusammengebaut werden.

Diese Software- und Hardwareansätze sind jetzt kompatibel, was grundlegende Entwicklungen im Bereich der KI erwarten lässt.

Wie funktioniert unser Gehirn? Neuronen, Synapsen, Netzwerke

Die Großhirnrinde bildet die äußere Schicht des Gehirns. Sie ist einige Millimeter dick und hat die Oberfläche eines Tischdeckchens. Sie enthält über 10 Milliarden Neuronen, die Informationen in Form von elektrischen Impulsen verarbeiten, den sogenannten "Aktionspotenzialen" oder "Spikes".

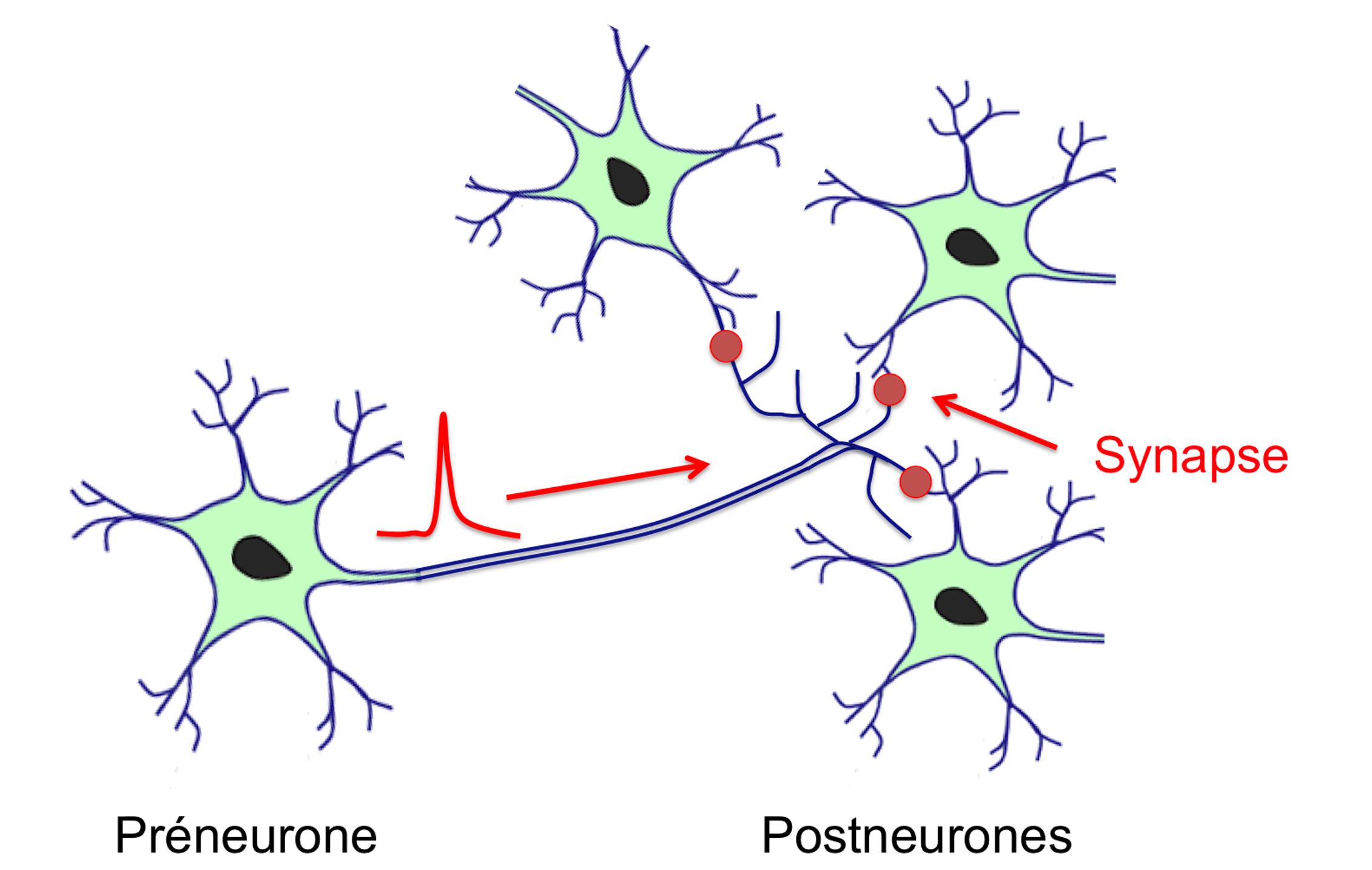

Der Verbindungsort zwischen einem Neuron, das einen Spike aussendet (das Präneuron), und dem Neuron, das ihn empfängt (das Postneuron), ist die Synapse. Jedes Neuron ist über Synapsen mit etwa 10.000 anderen Neuronen verbunden: Die Konnektivität eines solchen Netzwerks, das Konnektom, ist also erstaunlich.

Die Funktion der Neuronen ist festgelegt: Sie besteht darin, die Signale von den Synapsen zu summieren, und wenn diese Summe einen Schwellenwert erreicht, ein Aktionspotenzial oder Spike zu erzeugen, das sich dann im Axon ausbreitet. Bemerkenswert ist, dass ein Teil der Verarbeitung analog ist (die Summe der synaptischen Signale ist kontinuierlich), während der andere binär ist (die neuronale Antwort ist entweder die Erzeugung eines Spikes oder gar nichts).

So kann das Neuron als ein analoger Rechenprozessor angesehen werden, der mit einem digitalen Kommunikationssystem verbunden ist. Im Gegensatz zu Neuronen sind Synapsen plastisch, d.h. sie können die Intensität des an das Postneuron übertragenen Signals modulieren und besitzen einen "Speichereffekt", da der Zustand einer Synapse über die Zeit hinweg gespeichert werden kann.

Netzwerk biologischer Neuronen und die Weiterleitung des Aktionspotenzials oder „Spikes“.

Alain Cappy, vom Autor bereitgestellt

Anatomisch gesehen unterteilt sich die Großhirnrinde in etwa eine Million kortikale Säulen, die Netzwerke von Neuronen mit der gleichen Interkonnektionsarchitektur sind. Die kortikalen Säulen können als elementare Prozessoren betrachtet werden, wobei die Neuronen die Grundeinheiten und die Synapsen der Speicher sind.

Funktionell gesehen bilden die kortikalen Säulen ein hierarchisches Netzwerk mit Verbindungen, die von unten (den sensorischen Rezeptoren) nach oben verlaufen, was Abstraktionen ermöglicht, aber auch von oben nach unten, um Vorhersagen zu treffen: Die Prozessoren unseres Gehirns arbeiten in beide Richtungen.

Das Hauptziel der KI besteht darin, die Funktionen der Großhirnrinde durch Netzwerke aus künstlichen Neuronen und Synapsen zu emulieren. Diese Idee ist nicht neu, aber sie hat in den letzten Jahren mit dem Deep Learning oder "tiefen Lernen" an Fahrt gewonnen.

Software verwenden, um Netzwerke aus Neuronen und Synapsen zu simulieren

Der Softwareansatz zielt darauf ab, Netzwerke aus Neuronen und Synapsen mithilfe eines Standardcomputers zu simulieren. Er umfasst drei Bestandteile: mathematische Modelle der Neuronen und Synapsen, eine Interkonnektionsarchitektur der Neuronen und eine Lernregel, die es ermöglicht, die „synaptischen Gewichte” zu verändern.

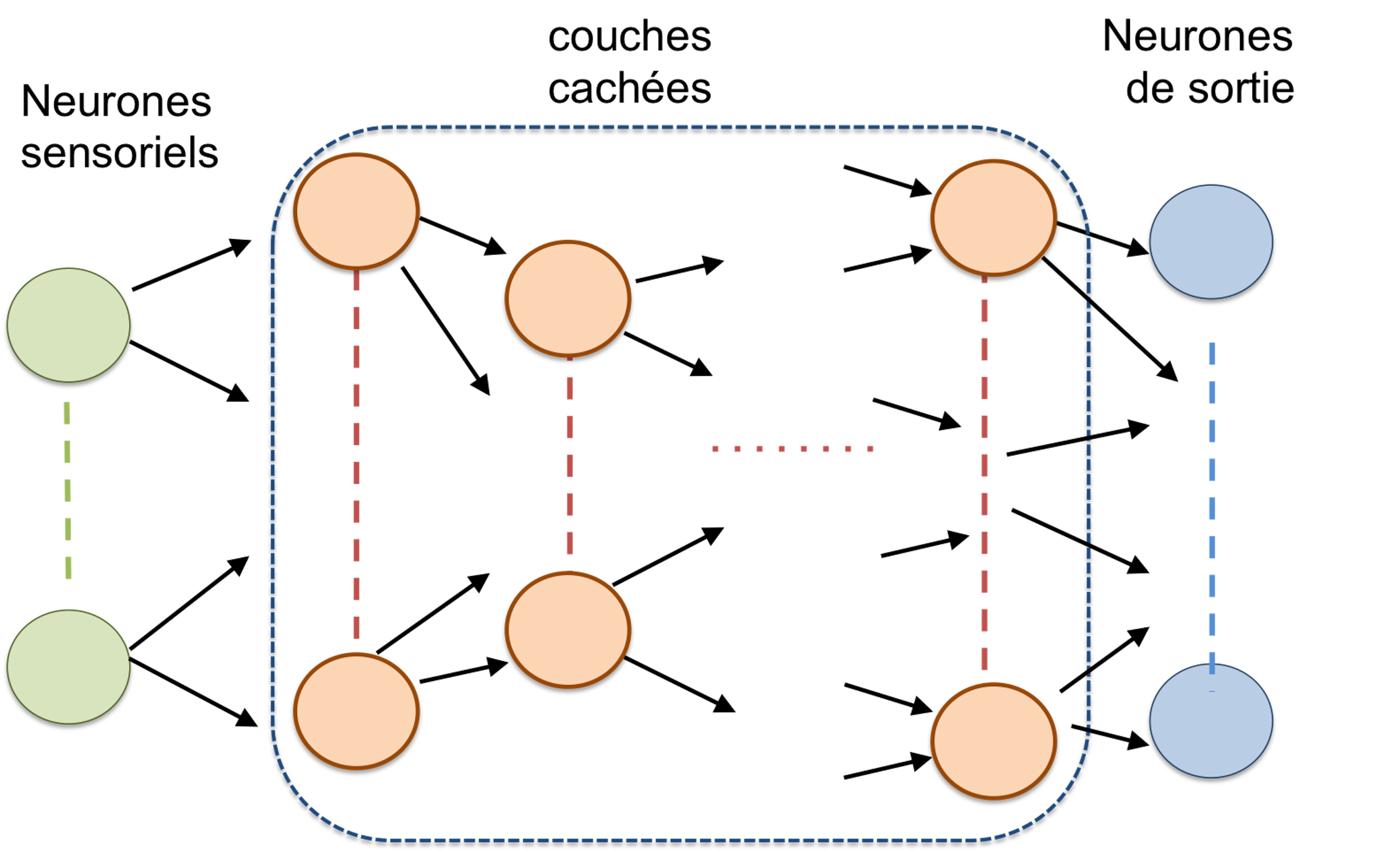

Architektur eines „vorwärtsgerichteten” Netzwerks aus Neuronen, auch feedforward genannt. Die Parameter eines solchen Netzwerks sind die Anzahl der Schichten, die Anzahl der Neuronen pro Schicht und die Regel für die Interkonnektion einer Schicht mit der nächsten. Bei einer bestimmten Aufgabe werden diese Parameter in der Regel empirisch und oft überdimensioniert gewählt. Es sei angemerkt, dass die Anzahl der Schichten sehr hoch sein kann: mehr als 150 bei Microsofts ResNet zum Beispiel.

Alain Cappy, vom Autor bereitgestellt

Die mathematischen Modelle der Neuronen reichen von den einfachsten bis hin zu den realistischeren (biologisch), aber die Einfachheit ist notwendig, um Netzwerke mit großer Größe - mehrere Tausend oder sogar Millionen Neuronen - zu simulieren, um die Rechenzeit zu begrenzen. Die Architektur der Netzwerke aus künstlichen Neuronen und Synapsen umfasst in der Regel eine Eingangsschicht, die die „sensorischen Neuronen” enthält, und eine Ausgabeschicht, die die Ergebnisse enthält. Dazwischen befindet sich ein Zwischennetzwerk, das in zwei Haupttypen unterteilt werden kann: „feedforward” oder „rekurrent”.

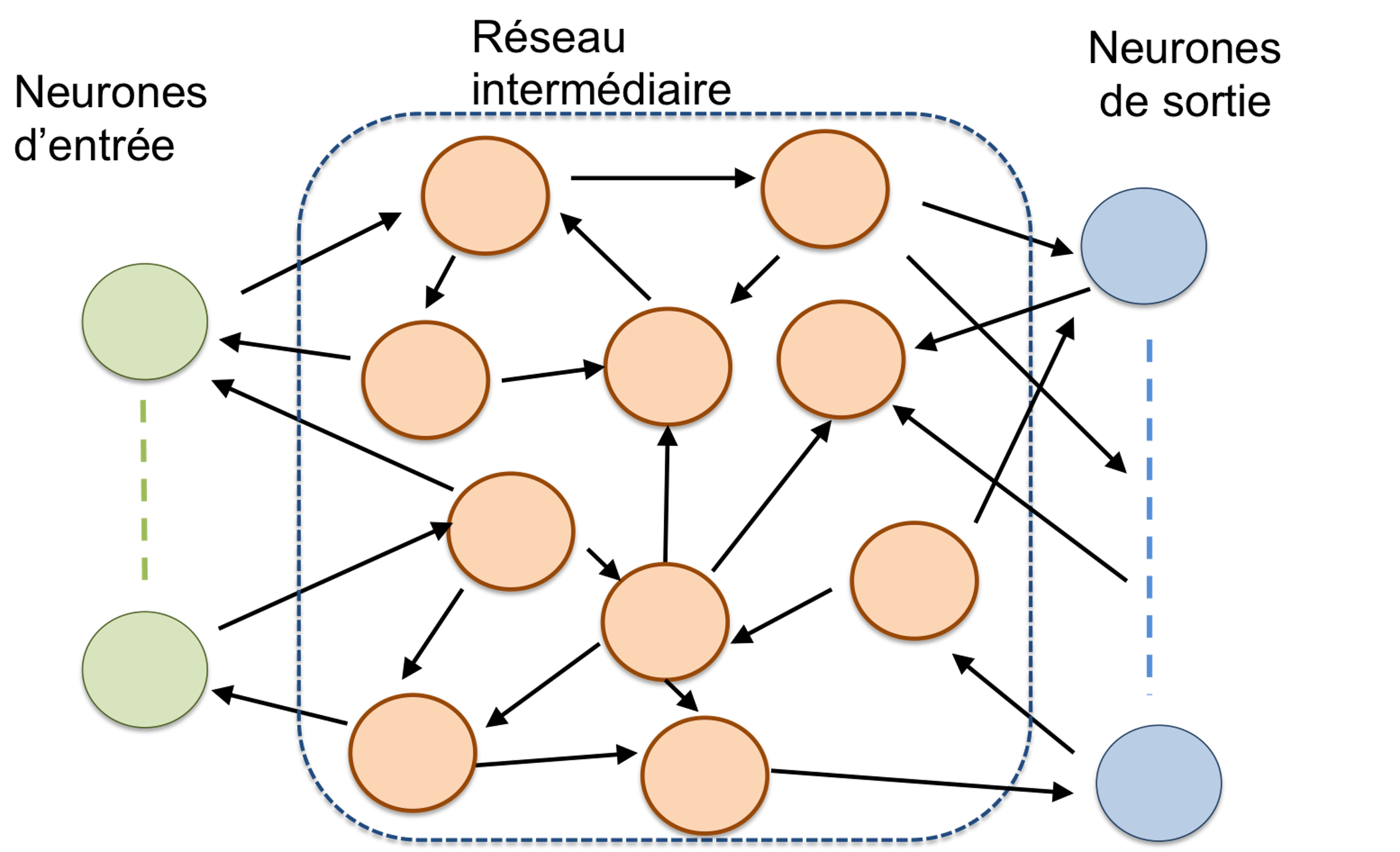

In einem feedforward-Netzwerk wird die Information von einer "Schicht" zur nächsten übertragen, ohne dass Rückkopplungen zu den vorherigen Schichten erfolgen. Im Gegensatz dazu können in rekurrenten Netzwerken Verbindungen von Schicht N zu den vorherigen N-1, N-2 usw. bestehen. Folglich hängt der Zustand eines Neurons zum Zeitpunkt t sowohl von den Eingabedaten zum Zeitpunkt t als auch vom Zustand der anderen Neuronen zum Zeitpunkt t-Δt ab, was die Lernprozesse erheblich komplexer macht.

Das Ziel des Lernens besteht darin, das Gewicht jeder Synapse zu bestimmen, d.h. die Intensität, mit der der Spike eines Präneurons an das Postneuron übertragen wird, damit das Netzwerk auf ein definiertes Ziel reagieren kann. Es gibt zwei Haupttypen des Lernens: überwacht, wenn ein „Lehrer” (oder „Meister”) das erwartete Ergebnis für jede Eingabe kennt, und unüberwacht, wenn ein solcher „Meister” fehlt.

„Rekurrente” Neuronen-Netzwerke enthalten Rückkopplungsschleifen. In rekurrenten Netzwerken ist die Variable „Zeit” ein wesentlicher Parameter.

Alain Cappy, vom Autor bereitgestellt

Im Falle eines überwachten Lernens ermöglicht der Vergleich zwischen dem für eine Eingabe erhaltenen Ergebnis und dem des „Lehrers” die Anpassung der synaptischen Gewichte. Im Falle des unüberwachten Lernens erfolgt die Anpassung der synaptischen Gewichte über eine Regel wie die berühmte Hebb-Regel, die es ermöglicht, die synaptischen Gewichte im Laufe der verschiedenen Versuche anzupassen.

Herstellung von Hardware-Netzwerken aus künstlichen Neuronen und Synapsen

Der Hardwareansatz besteht darin, Neuroprozessoren zu entwerfen und herzustellen, die Neuronen, Synapsen und Interkonnektionsnetzwerke emulieren. Die fortschrittlichste Technologie basiert auf der Standardhalbleitertechnologie (genannt CMOS), die in unseren Computern, Tablets und Smartphones verwendet wird. Sie ist derzeit die einzige ausreichend ausgereifte Technologie, um Schaltkreise mit mehreren tausend oder Millionen Neuronen und Synapsen zu produzieren, die in der Lage sind, die komplexen Aufgaben der KI zu bewältigen. Es werden aber auch Technologien auf Grundlage neuer Geräte vorgeschlagen, beispielsweise in der Spintronik oder mit Memristoren.

Wie biologische Netzwerke kombinieren auch Hardware-Netzwerke aus künstlichen Neuronen und Synapsen oft einen analogen Teil zur Integration der synaptischen Signale und einen digitalen Teil für die Kommunikation und Speicherung der synaptischen Gewichte.

Dieser gemischte Ansatz wird in den fortgeschrittensten Technologien verwendet, wie z.B. bei den Chips des europäischen Human Brain-Projekts, von Intel oder bei IBMs TrueNorth. Der TrueNorth-Chip enthält beispielsweise eine Million Neuronen und 256 Millionen programmierbare Synapsen, verteilt auf 4096 neuromorphische Kerne – vergleichbar mit den kortikalen Säulen des Lebenden – die miteinander durch ein Kommunikationsnetzwerk verbunden sind. Die Leistungsaufnahme des TrueNorth-Chips beträgt 20 mW pro cm2, während die eines herkömmlichen Mikroprozessors bei 50 bis 100 W pro cm2 liegt, was einen Energiegewinn von über 1000 bedeutet (es ist üblich, die "Leistungsdichte pro Fläche” zu berücksichtigen, da die Chips nicht alle die gleiche Fläche haben).

Wird die Zukunft hardwarebasiert oder softwarebasiert sein?

Softwarebasierte Netzwerke künstlicher Neuronen und Synapsen ermöglichen es, auf elegante Weise viele Probleme zu lösen, insbesondere in den Bereichen der Bild- und Tonverarbeitung und in jüngerer Zeit der Texterzeugung. Aber das Training rekurrenter Software-Netzwerke künstlicher Neuronen und Synapsen bleibt ein Beispiel für eine große Herausforderung. Ein weiteres Problem: Die erforderliche Rechenleistung steigt beträchtlich für die großen Netzwerke künstlicher Neuronen und Synapsen, die notwendig sind, um komplexe Probleme zu lösen.

Ein Beispiel dafür sind die beeindruckenden Ergebnisse des Konversationsprogramms "GPT-3", das auf dem größten jemals gebauten Netz aus künstlichen Neuronen und Synapsen basiert. Es verfügt über 175 Milliarden Synapsen und erfordert eine beträchtliche Rechenleistung, bestehend aus 295.000 Prozessoren, die eine elektrische Leistung von mehreren Megawatt verbrauchen, was der Leistung einer Stadt mit mehreren tausend Einwohnern entspricht. Diese Zahl steht im Vergleich zu den wenigen Watt, die ein menschliches Gehirn verbraucht, um die gleiche Aufgabe zu erledigen!

Der Hardware-Ansatz und die Neuroprozessoren sind aus energetischer Sicht viel leistungsfähiger, aber sie haben ein großes Hindernis: die Skalierung, d.h. die Herstellung von mehreren Millionen oder Milliarden Neuronen und Synapsen sowie ihrem Interkonnektionsnetzwerk.

In Zukunft und insofern als Neuroprozessoren dieselbe CMOS-Technologiebasis wie gewöhnliche Prozessoren verwenden, könnte die Co-Integration der software- und hardwarebasierten Ansätze den Weg zu einer neuen Art der Informationsverarbeitung und damit zu einer energieeffizienten und leistungsstarken KI ebnen.