Dos tipos de neuronas artificiales para emular el cerebro 💡

Publicado por Adrien,

Fuente: The Conversation bajo licencia Creative Commons

Otros Idiomas: FR, EN, DE, PT

Fuente: The Conversation bajo licencia Creative Commons

Otros Idiomas: FR, EN, DE, PT

El cerebro sigue siendo el rey de los ordenadores. Las máquinas más sofisticadas que se inspiran en él, denominadas "neuromórficas", comprenden hoy hasta 100 millones de neuronas, tantas como el cerebro de un pequeño mamífero.

Estas redes de neuronas y sinapsis artificiales son la base de la inteligencia artificial. Se pueden emular de dos formas: con simulaciones por ordenador o con componentes electrónicos que reproducen neuronas y sinapsis biológicas, ensamblados en "neuroprocesadores".

Estos enfoques de software y hardware son ahora compatibles, lo que sugiere posibles evoluciones drásticas en el campo de la IA.

¿Cómo funciona nuestro cerebro? Neuronas, sinapsis y redes

La corteza constituye la capa externa del cerebro. Con un grosor de unos pocos milímetros y una superficie similar a la de una servilleta, contiene más de 10 mil millones de neuronas que procesan la información en forma de impulsos eléctricos llamados "potencial de acción" o "spike".

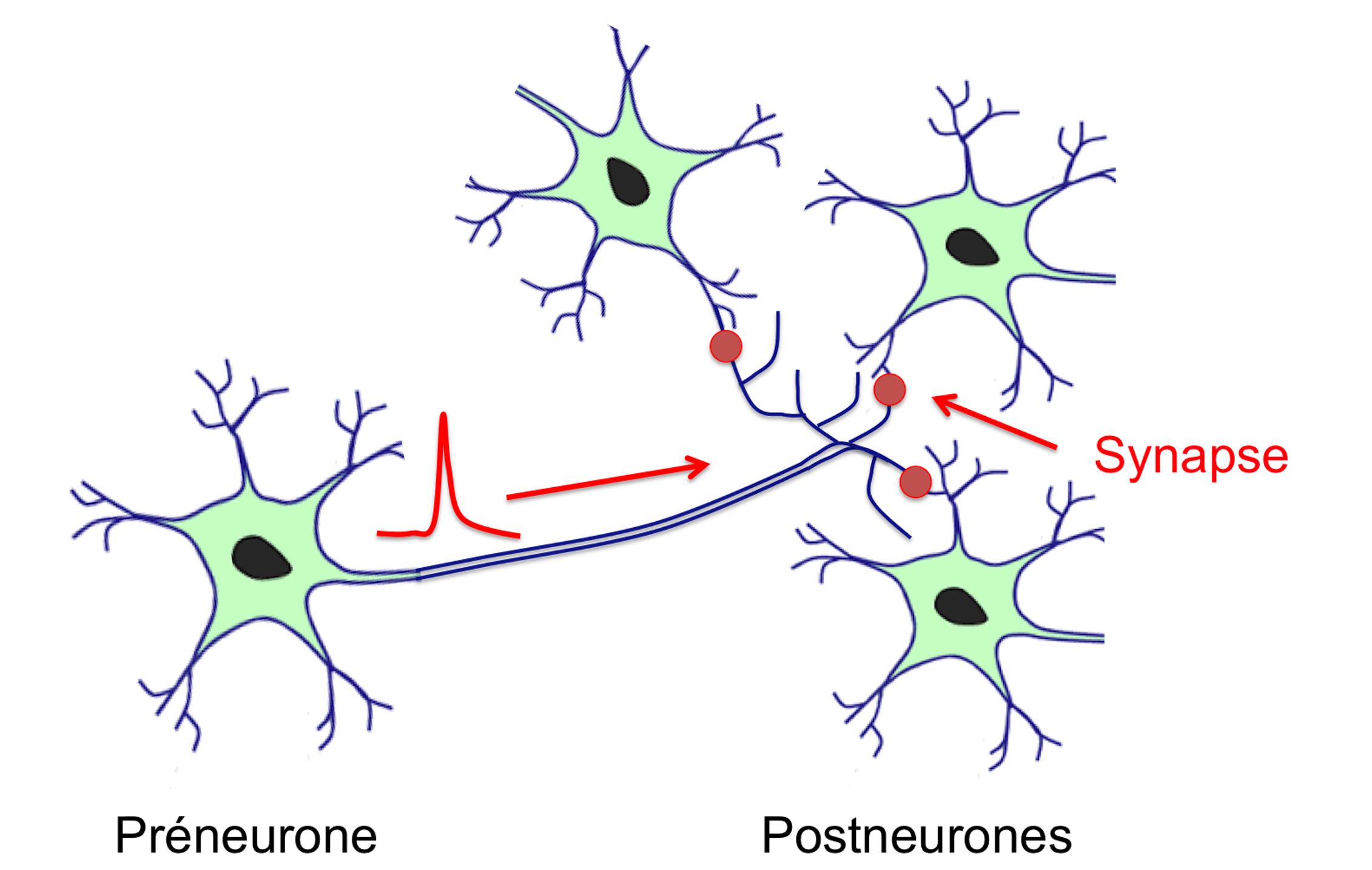

El punto de conexión entre una neurona que emite un spike (la prenurona) y la neurona que lo recibe (la postneurona) es la sinapsis. Cada neurona está conectada por sinapsis a unas 10,000 otras neuronas: la conectividad de una red de este tipo, el conectoma, es por lo tanto prodigiosa.

La función de las neuronas es fija: consiste en sumar las señales provenientes de las sinapsis, y si esta suma alcanza un umbral, genera un potencial de acción o spike que se propaga en el axón. Es sorprendente notar que una parte del procesamiento es analógico (la suma de las señales sinápticas es continua), mientras que la otra es binaria (la respuesta neuronal es o la generación de un spike, o nada).

Así, la neurona puede considerarse como un calculador analógico asociado a un sistema de comunicación digital. A diferencia de las neuronas, las sinapsis son plásticas, es decir, pueden modular la intensidad de la señal transmitida a la postneurona y tienen un efecto de "memoria", porque el estado de una sinapsis puede mantenerse en el tiempo.

Red de neuronas biológicas y circulación del potencial de acción o "spike".

Alain Cappy, Author provided

Desde un punto de vista anatómico, la corteza se divide en aproximadamente un millón de columnas corticales, que son redes de neuronas que tienen toda la misma arquitectura de interconexión. Las columnas corticales pueden considerarse como procesadores elementales, cuyas neuronas son los dispositivos básicos y las sinapsis la memoria.

Desde un punto de vista funcional, las columnas corticales forman una red jerárquica con conexiones que van desde abajo (los sensores) hacia arriba, lo que permite las abstracciones, pero también desde arriba hacia abajo, para permitir las predicciones: los procesadores de nuestro cerebro funcionan en ambos sentidos.

El principal desafío de la IA es emular las funcionalidades de la corteza con redes artificiales de neuronas y sinapsis. Esta idea no es nueva, pero en los últimos años ha avanzado mucho con el deep learning, o "aprendizaje profundo".

Uso de software para simular redes de neuronas y sinapsis

El enfoque basado en software busca simular las redes de neuronas y sinapsis con una computadora estándar. Involucra tres ingredientes: modelos matemáticos de neuronas y sinapsis, una arquitectura de interconexión de neuronas y una regla de aprendizaje que permite modificar los "pesos sinápticos".

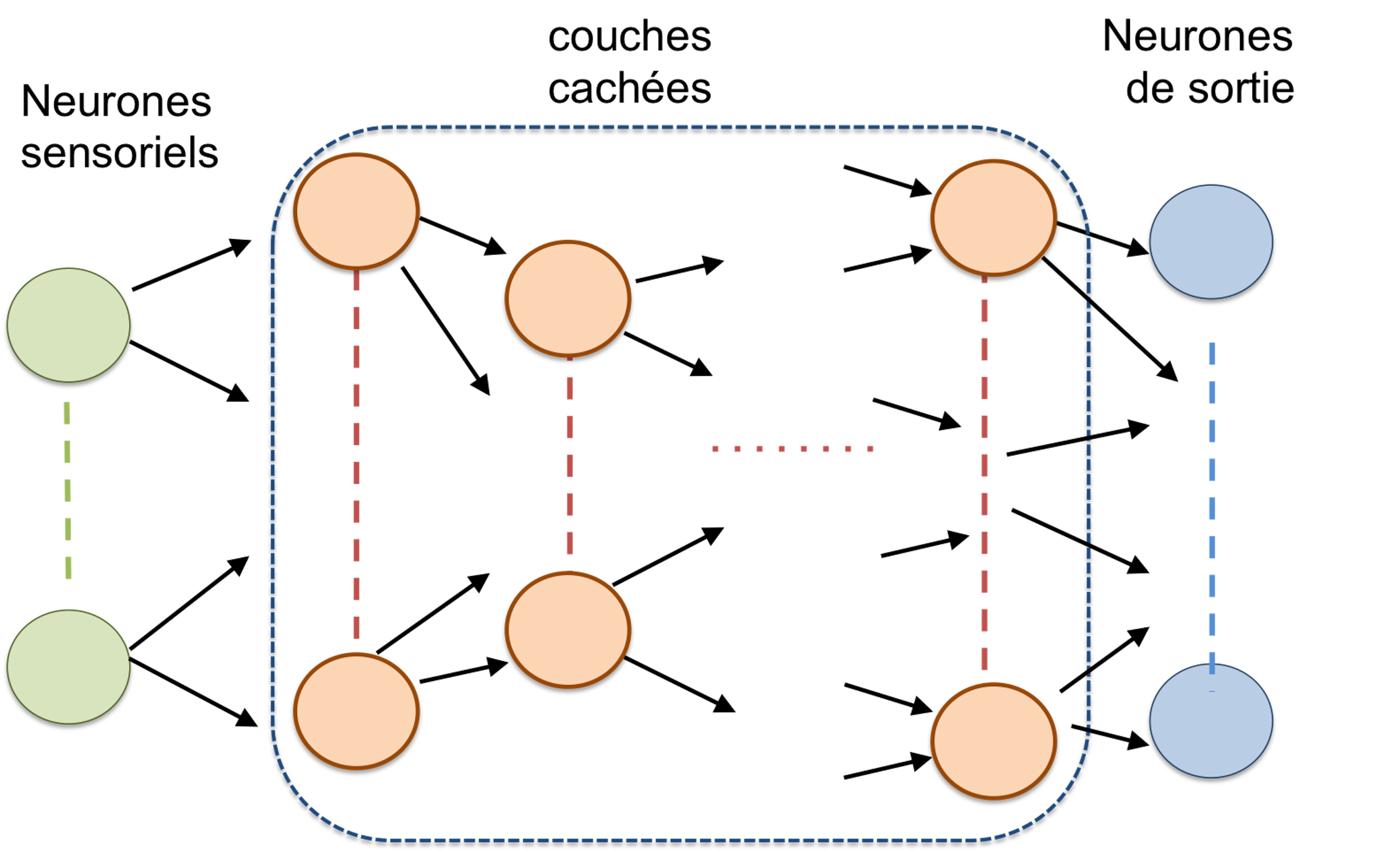

Arquitectura de una red de neuronas "hacia adelante", o feedforward. Los parámetros de dicha red son el número de capas, el número de neuronas por capa y la regla de interconexión de una capa a la siguiente. Para una tarea dada, estos parámetros generalmente se eligen de manera empírica y a menudo están sobredimensionados. Cabe destacar que el número de capas puede ser muy grande: más de 150 para el ResNet de Microsoft, por ejemplo.

Alain Cappy, Author provided

Los modelos matemáticos de las neuronas varían desde los más simples hasta los más realistas (biológicamente), pero la simplicidad es necesaria para simular redes de gran tamaño - varios miles, o incluso millones de neuronas - a fin de limitar el tiempo de cálculo. La arquitectura de las redes artificiales de neuronas y sinapsis generalmente comprende una "capa" de entrada, que contiene los "neuronas sensoriales", y una capa de salida, los resultados. Entre ambas, una red intermedia que puede tener dos formas principales: "feedforward" o "recurrente".

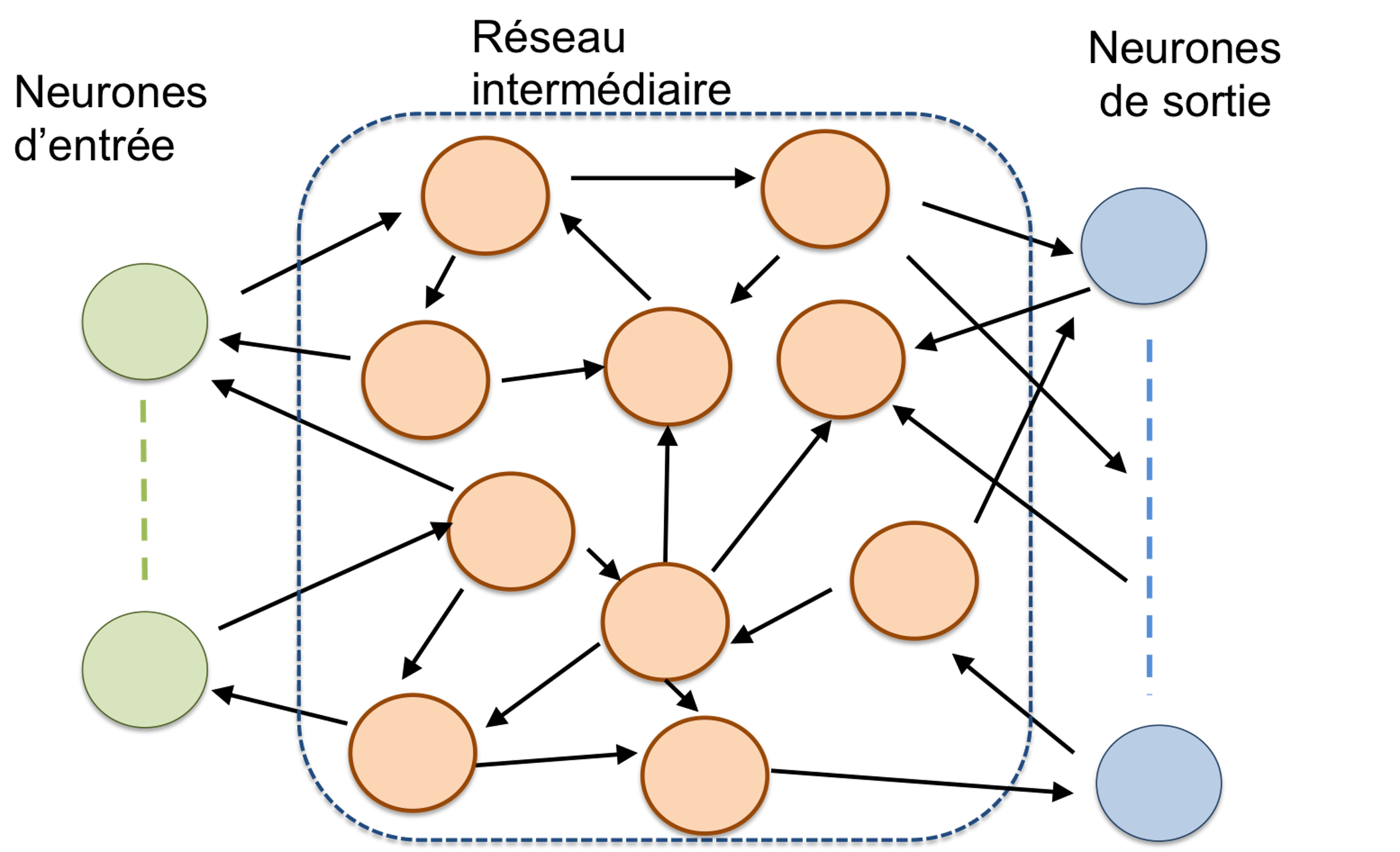

En una red feedforward (hacia adelante), la información se transfiere de una "capa" a la siguiente, sin retroalimentación hacia las capas anteriores. En cambio, en las redes recurrentes, pueden existir conexiones desde una capa N hacia las anteriores N-1, N-2, etc. Como consecuencia, el estado de una neurona en el instante t depende tanto de los datos de entrada en el instante t, como del estado de las otras neuronas en el instante t-Δt., lo que complica notablemente los procesos de aprendizaje.

El aprendizaje tiene como objetivo determinar el peso de cada sinapsis, es decir, la intensidad con la que el spike proveniente de una prenurona se transmite a la postneurona, para que la red pueda cumplir un objetivo definido. Se distinguen dos grandes tipos de aprendizaje: supervisado, cuando un "maestro" conoce el resultado esperado para cada entrada; y no supervisado, cuando no hay tal "maestro".

Las redes de neuronas "recurrentes" contienen bucles de retroalimentación. En las redes recurrentes, la variable "tiempo" es un parámetro esencial.

Alain Cappy, Author provided

En el caso de un aprendizaje supervisado, es la comparación entre el resultado obtenido para una entrada y el del "maestro" lo que permite ajustar los pesos sinápticos. En el caso del aprendizaje no supervisado, es una regla como la famosa regla de Hebb la que permite que los pesos sinápticos evolucionen a lo largo de los diferentes intentos.

Fabricar redes de neuronas y sinapsis artificiales en hardware

El enfoque basado en hardware consiste en diseñar y fabricar neuroprocesadores que emulen neuronas, sinapsis e interconexiones. La tecnología más avanzada se basa en la rama de semiconductores estándar (llamada CMOS), utilizada en nuestras computadoras, tabletas y otros smartphones. Es la única tecnología lo suficientemente madura actualmente para fabricar circuitos que contengan varios miles o millones de neuronas y sinapsis capaces de realizar las tareas complejas que exige la IA, pero también se proponen tecnologías basadas en nuevos dispositivos, por ejemplo, en espintrónica o utilizando memristores.

Al igual que las redes biológicas, las redes artificiales de neuronas y sinapsis en hardware a menudo combinan una parte analógica para la integración de señales sinápticas y una parte digital para las comunicaciones y la memorización de los pesos sinápticos.

Este tipo de enfoque mixto se utiliza en las tecnologías más avanzadas, como los chips del proyecto europeo Human Brain, de Intel o TrueNorth de IBM. El chip TrueNorth, por ejemplo, combina un millón de neuronas y 256 millones de sinapsis programables, repartidas en 4,096 núcleos neuromórficos –asimilables a las columnas corticales del ser vivo– conectados entre sí por una red de comunicación. El consumo de energía del chip TrueNorth es de 20 mW por cm2, mientras que el de un microprocesador convencional es de 50 a 100 W por cm2, lo que representa un aumento en la eficiencia energética superior a 1000 veces (es habitual considerar la "densidad de potencia superficial", ya que no todos los chips tienen la misma superficie).

¿El futuro será de hardware o de software?

Las redes artificiales de neuronas y sinapsis en software permiten resolver elegantemente muchos problemas, particularmente en los campos del procesamiento de imágenes y sonidos y, más recientemente, la generación de texto. Pero el aprendizaje de redes artificiales de neuronas y sinapsis recurrentes sigue representando una dificultad considerable, ya sea mediante métodos supervisados o no. Otro problema: la enorme potencia de cómputo necesaria para redes grandes de neuronas y sinapsis artificiales, las cuales son esenciales para resolver problemas complejos.

Por ejemplo, los impresionantes resultados del programa conversacional "GPT-3" se basan en la mayor red artificial de neuronas y sinapsis jamás construida. Posee 175 mil millones de sinapsis, y requiere una potencia de cálculo considerable, formada por 295,000 procesadores que consumen una potencia eléctrica de varios megavatios, equivalente a la consumida por una ciudad de varios miles de habitantes. Esta cifra se compara con los pocos vatios consumidos por el cerebro humano para realizar la misma tarea.

El enfoque basado en hardware y los neuroprocesadores son mucho más eficientes en términos energéticos, pero adolecen de una dificultad importante: la escalabilidad, es decir, la fabricación de varios millones o miles de millones de neuronas y sinapsis y su red de interconexión.

En el futuro, y en la medida en que los neuroprocesadores utilizan la misma tecnología CMOS que los procesadores convencionales, la co-integración de los enfoques de software y hardware puede abrir la puerta a una nueva manera de concebir el procesamiento de la información y, por lo tanto, una IA eficiente y de bajo consumo de energía.