Comment nait la première impression d'une scène visuelle

Publié par Isabelle,

Source: CNRSAutres langues:

Source: CNRSAutres langues:

1

Restez toujours informé: suivez-nous sur Google Actualités (icone ☆)

Classifier une image, par exemple en décidant si elle contient ou non un animal, est une des fonctions de base du cerveau. Dans le royaume animal, on comprend aisément qu'elle constitue une fonction vitale aussi bien pour des prédateurs que pour leurs proies. Les mécanismes sous-jacents sont de plus en plus étudiés aussi bien dans le domaine des systèmes d'intelligence artificielle que dans celui des Neurosciences, mais ils restent encore bien mystérieux pour les chercheurs. En effet, si les réseaux d'ordinateurs les plus avancés peuvent aujourd'hui aisément calculer numériquement des quantités phénoménales de données à partir de bases de données pharaoniques, même les systèmes les plus avancés de classification d'images n'égalent pas encore les capacités d'un jeune enfant !

Laurent Perrinet de l'Institut de Neurosciences de la Timone à Marseille et James Bednar de l'université d'Edinburgh en Écosse, ont modélisé la façon dont nous pouvons classer différentes catégories d'images. Leur l'objectif initial était de différencier des scènes visuelles naturelles de scènes d'intérieur, mais ils ont pu montrer que ce système simple de classification permettait aussi de détecter en une fraction de seconde des animaux dans une image. En effet, ils ont mis en évidence qu'un niveau de performance comparable à celui d'observateurs humains est atteignable tout en utilisant un niveau de représentation très primitif, et non, comme cela est généralement admis, après une longue série d'analyses visuelles de plus en plus abstraites (détection des yeux et des membres, puis de la tête et du corps, etc...).

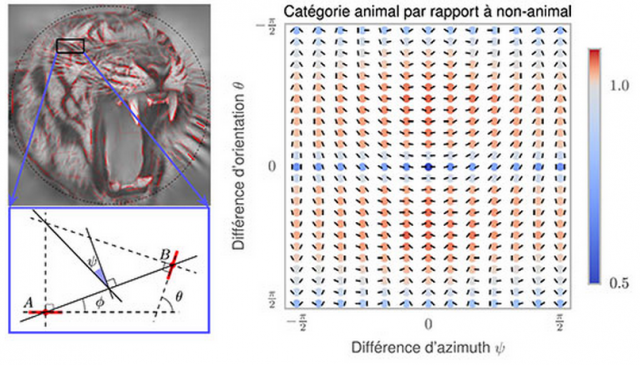

Cette représentation primitive se base sur les modèles existants de représentation des images dans les aires visuelles de bas niveau des primates. On estime en effet que dans le cortex visuel primaire les images visuelles sont représentées dans l'activité neurale comme l'organisation de contours élémentaires, à la manière d'un peintre qui dessine une silhouette en une série de coups de pinceau. Une des innovations majeures dans cette étude consiste à simplement utiliser la fréquence des configurations entre des paires de contours élémentaires comme représentation d'entrée utilisée pour le classificateur.

Pour arriver à ce résultat, les chercheurs ont utilisé des modèles mathématiques de la représentation des images dans le cortex visuel primaire et en particulier les inter-relations entre des éléments de contours voisins. En étudiant les résultats de l'analyse, on note que dans les images naturelles, des contours parallèles sont observés majoritairement, signe que les contours et textures présents dans les images contiennent en majorité des alignements. C'est encore plus vrai dans les environnements artificiels comme dans une scène d'intérieur (par exemple un bureau) où les bords francs dominent. On montre aussi que les objets co-circulaires (c'est-à-dire des configurations symétriques) sont aussi relativement plus présents que des configurations aléatoires.

La principale nouveauté de cette étude est de montrer que les images contenant un animal (quelle que soit son espèce ou sa position dans l'image) contiennent sensiblement plus de configurations symétriques. Cette différence suffit pour expliquer le niveau de performance de classification chez les humains quand on leur présente de telles scènes de façon très brève.

Pour valider cette hypothèse, les chercheurs ont alors utilisé des données précédemment enregistrées dans lesquelles des volontaires regardaient et classifiaient des centaines d'images. En utilisant cette représentation primitive, ils ont mis en évidence qu'un programme très simple pouvait facilement classifier les images comme contenant ou non un animal, sans avoir besoin d'une connaissance plus élaborée sur les caractéristiques de l'animal comme sa position, sa taille ou son orientation sur l'image.

Cette découverte peut accélérer le développement de requêtes via des images dans les moteurs de recherche, comme Google et Facebook, car elle permet une classification simple et robuste grâce à des caractéristiques statistiques de bas niveau basées sur la géométrie des objets. Elle pourrait ainsi améliorer l'efficacité de tels algorithmes. Toutefois, et comme cela a été mis en évidence dans la psychophysique humaine, les catégories visuelles doivent être visuellement assez distinctes: ce traitement rapide ne permet pas, par exemple, de distinguer une scène de montagne d'une scène de mer. De manière surprenante, les chercheurs ont montré que lorsque les humains se trompent en classifiant de manière erronée une image comme contenant un animal, le programme a tendance à se tromper de la même façon! En utilisant des modèles mathématiques, on peut donc imaginer synthétiser des images d'animaux qui en fait, n'en contiendraient pas. Ces "chimères" seront sûrement très utiles pour percer encore plus les mystères du système visuel.

Figure: À partir d'une image naturelle (en haut à gauche), les chercheurs ont déterminé la façon la plus efficace de la représenter comme une succession de contours élémentaires orientés. Sur cet exemple, l'image est décomposée en contours élémentaires (marqués en rouge) et l'image correspond à sa reconstruction à partir de cette représentation, gage d'une représentation correcte de l'image. Le schéma (en bas à gauche) décrit alors les relations géométriques pour chaque paire de contours élémentaires (dénotés ici A et B) et en particulier la différence entre leurs orientations (cette différence est nulle pour des contours parallèles) ainsi que leur différence d'azimuth. Une valeur nulle de cette dernière indiquant une symétrie, c'est-à-dire que ces contours sont co-circulaires. On peut alors compiler les statistiques des différentes configurations possibles sur des bases de données de 600 images contenant ou ne contenant pas d'animal. On voit alors que les images contenant un animal présentent relativement moins de configurations parallèles (disques bleus, jusqu'à 50% de moins) et plus de configurations co-circulaires, c'est à dire le long de l'axe vertical médian (disques rouges, jusqu'à 20% d'occurences en plus). Cette différence, aussi tenue soit elle, permet alors de classifier une image pour permettre de deviner si elle contient ou non un animal

© Laurent Perrinet

Dans le futur, l'extension de cette représentation calculée sur l'ensemble de l'image pourrait être améliorée en la couplant à des processus de classification locaux permettant de déterminer par exemple la position de l'objet à classifier et de segmenter progressivement la figure du fond afin de diminuer ainsi les distractions.

Pour plus d'information voir:

Edge co-occurrences can account for rapid categorization of natural versus animal images.

Perrinet LU, Bednar JA. Science Reports. 2015 Jun 22;5:11400. doi: 10.1038/srep11400.