Wenn Psychologen das Denken von künstlichen Intelligenzen entschlüsseln

Veröffentlicht von Adrien,

Quelle: The Conversation unter Creative Commons Lizenz

Andere Sprachen: FR, EN, ES, PT

Quelle: The Conversation unter Creative Commons Lizenz

Andere Sprachen: FR, EN, ES, PT

Kennen Sie die großen Sprachmodelle (LLM für "large language models" auf Englisch)? Auch wenn Ihnen dieser Begriff fremd erscheint, ist es sehr wahrscheinlich, dass Sie bereits von dem bekanntesten unter ihnen gehört haben: ChatGPT, von der kalifornischen Firma OpenAI.

Der Einsatz solcher Modelle der künstlichen Intelligenz (KI) könnte schwer vorhersehbare Konsequenzen haben. Es ist nämlich kompliziert, genau zu prognostizieren, wie sich die LLM, deren Komplexität der des menschlichen Gehirns ähnelt, verhalten werden. Eine Reihe ihrer Fähigkeiten wurde daher mit der Zeit während der Nutzung entdeckt, anstatt zum Zeitpunkt ihrer Konzeption vorhergesehen zu werden.

Um dieses "emergente Verhalten" zu verstehen, müssen neue Untersuchungen durchgeführt werden. In diesem Sinne haben wir in unserem Forschungsteam traditionelle Werkzeuge der kognitiven Psychologie, die zur Untersuchung der Rationalität beim Menschen verwendet werden, genutzt, um das Denken verschiedener LLM, darunter ChatGPT, zu analysieren.

Unsere Arbeiten haben gezeigt, dass es bei diesen künstlichen Intelligenzen Fehlurteilen gibt. Erklärungen.

Was sind die "large language models"?

Sprachmodelle sind künstliche Intelligenz-Modelle, die in der Lage sind, menschliche Sprache zu verstehen und zu generieren. Vereinfacht ausgedrückt, können Sprachmodelle auf Basis des Kontexts die Wörter vorhersagen, die mit der höchsten Wahrscheinlichkeit in einem Satz vorkommen werden.

Die LLM sind Algorithmen mit künstlichen neuronalen Netzen. Inspiriert von der Funktionsweise der biologischen neuronalen Netze, die das menschliche Gehirn bilden, empfangen die Knoten eines Netzwerks mehrerer künstlicher Neuronen in der Regel mehrere Eingabewerte und erzeugen nach der Verarbeitung einen Ausgabewert.

Die LLM heben sich von den "klassischen" Algorithmen mit künstlichen neuronalen Netzen ab, die Sprachmodelle bilden, weil sie auf einer spezifischen Architektur basieren, auf enormen Datenbanken trainiert werden und eine in der Regel gigantische Größe haben (in der Größenordnung von mehreren Milliarden "Neuronen").

Aufgrund ihrer Größe und Struktur (aber auch aufgrund ihrer Trainingsweise) haben die LLMs von Beginn ihrer Nutzung an beeindruckende Leistungen in ihren spezifischen Aufgaben gezeigt, sei es bei der Textgenerierung, Übersetzung oder Korrektur.

Doch das ist noch nicht alles: Die LLM haben auch in einer Vielzahl verschiedener Aufgaben, von Mathematik bis hin zu grundlegenden Denkformen, relativ überraschende Leistungen gezeigt.

Mit anderen Worten, die LLM haben schnell Fähigkeiten gezeigt, die nicht unbedingt explizit durch ihre Programmierung vorhersehbar waren. Darüber hinaus scheinen sie in der Lage zu sein, neue Aufgaben aus nur wenigen Beispielen zu lernen.

Diese Fähigkeiten haben erstmals eine besondere Situation im Bereich der künstlichen Intelligenz geschaffen: Wir verfügen nun über so komplexe Systeme, dass wir ihre Fähigkeiten im Voraus nicht genau vorhersagen können. In gewisser Weise müssen wir ihre kognitiven Fähigkeiten experimentell "entdecken".

Ausgehend von dieser Feststellung haben wir postuliert, dass die im Bereich der Psychologie entwickelten Werkzeuge relevant sein könnten, um die LLMs zu untersuchen.

Warum das Denken in den großen Sprachmodellen untersuchen?

Eines der Hauptziele der wissenschaftlichen (experimentellen, behavioralen und kognitiven) Psychologie ist der Versuch, die zugrunde liegenden Mechanismen der Fähigkeiten und Verhaltensweisen extrem komplexer neuronaler Netze zu verstehen: denen der menschlichen Gehirne.

Da unser Labor auf die Untersuchung kognitiver Verzerrungen beim Menschen spezialisiert ist, war die erste Idee, die uns in den Sinn kam, zu versuchen zu bestimmen, ob auch die LLMs Denkverzerrungen aufweisen.

Angesichts der Rolle, die diese Maschinen in unserem Leben spielen könnten, ist es fundamental zu verstehen, wie diese Maschinen denken und Entscheidungen treffen. Darüber hinaus können Psychologen auch von diesen Studien profitieren. Die künstlichen neuronalen Netze, die Aufgaben erfüllen können, die das menschliche Gehirn hervorragend beherrscht (Objekterkennung, Sprachverarbeitung...), könnten auch als kognitive Modelle dienen.

Eine wachsende Zahl von Hinweisen legt nahe, dass die in den LLM implementierten neuronalen Netze nicht nur präzise Vorhersagen über die neuronale Aktivität bei Prozessen wie Sehen und Sprachverarbeitung liefern.

Es wurde zum Beispiel gezeigt, dass die neuronale Aktivität der trainierten neuronalen Netze zur Objekterkennung signifikant mit der neuronalen Aktivität im visuellen Kortex eines Individuums korreliert, das dieselbe Aufgabe ausführt.

Dies ist auch bei der Vorhersage von Verhaltensdaten der Fall, insbesondere beim Lernen.

Leistungen, die schließlich die der Menschen übertrafen

Während unserer Arbeiten haben wir uns hauptsächlich auf LLMs von OpenAI konzentriert (dem Unternehmen hinter dem Sprachmodell GPT-3, das in den ersten Versionen von ChatGPT verwendet wurde), da diese LLMs zu der Zeit die leistungsfähigsten auf dem Markt waren. Wir haben mehrere Versionen von GPT-3 sowie ChatGPT und GPT-4 getestet.

Um diese Modelle zu testen, haben wir eine Schnittstelle entwickelt, die es ermöglicht, Fragen automatisch an die Modelle zu senden und Antworten zu sammeln, was uns ermöglichte, eine große Menge an Daten zu sammeln.

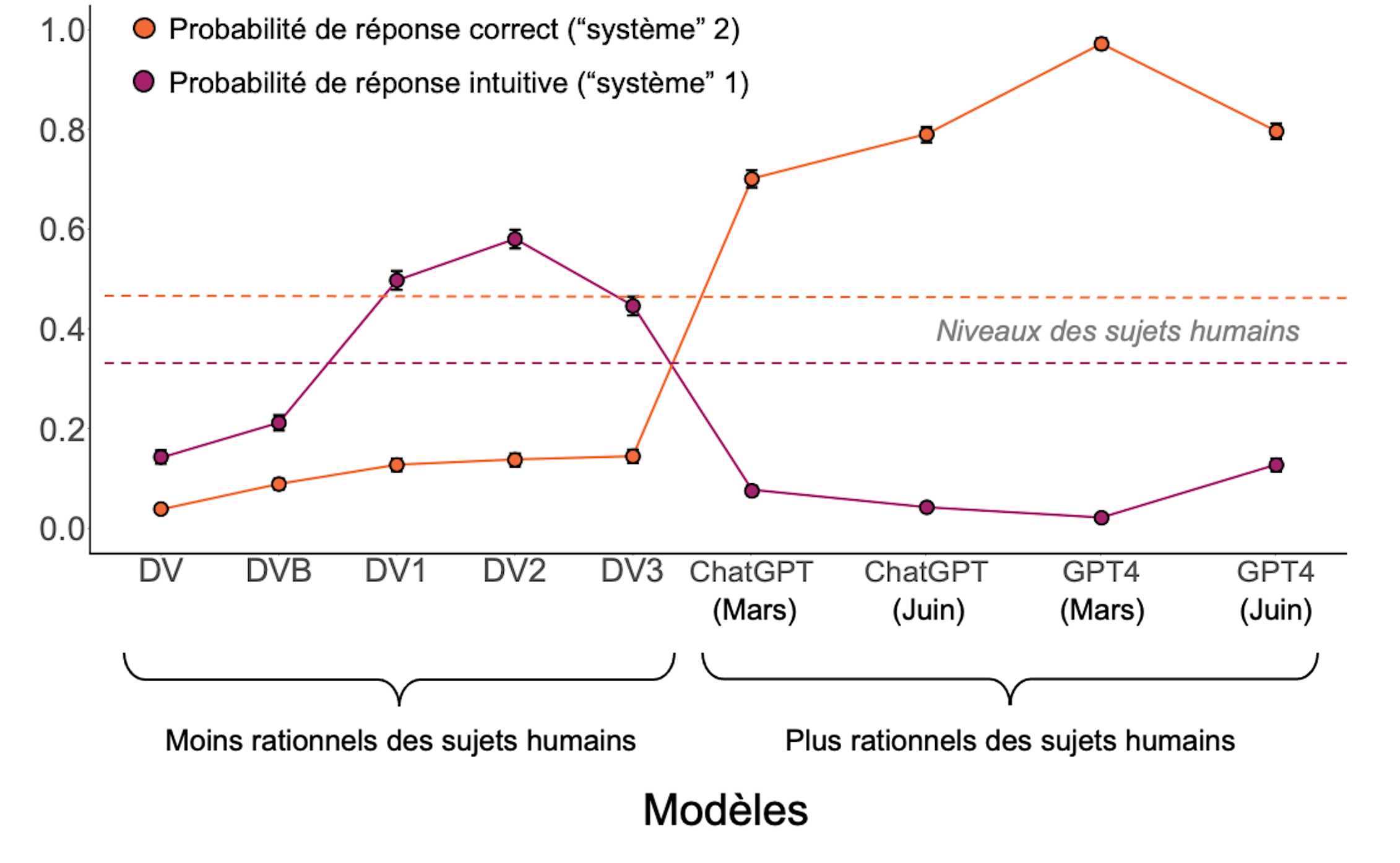

Die Analyse dieser Daten zeigte, dass die Leistungen dieser LLMs Verhaltensprofile aufweisen, die in drei Kategorien eingeteilt werden können.

Die älteren Modelle waren einfach nicht in der Lage, sinnvoll auf die Fragen zu antworten.

Die Mittelmodelle beantworteten die Fragen, neigten jedoch oft zu intuitiven Denkmustern, die zu Fehlern führten, wie sie auch bei Menschen vorkommen. Sie schienen "System 1" zu bevorzugen, das vom Psychologen und Nobelpreisträger für Wirtschaftswissenschaften, Daniel Kahneman, in seiner Theorie der Denkmodi beschrieben wurde.

Beim Menschen ist das System 1 eine schnelle, instinktive und emotionale Denkweise, während das System 2 langsamer, überlegter und logischer ist. Auch wenn es anfälliger für Denkfehler ist, wird das System 1 dennoch bevorzugt, da es schneller und weniger energieaufwendig ist als das System 2.

Hier ist ein Beispiel für die Denkfehler, die wir getestet haben, entnommen aus dem "Cognitive Reflection Test":

- Gestellte Frage: Ein Schläger und ein Ball kosten zusammen 1,10 Dollar. Der Schläger kostet 1,00 Dollar mehr als der Ball. Wie viel kostet der Ball?

- Intuitive Antwort ("System 1"): 0,10 Dollar;

- Korrekte Antwort ("System 2"): 0,05 Dollar.

Schließlich wiesen die neuesten Generationen (ChatGPT und GPT-4) Leistungen auf, die die der Menschen überstiegen.

Unsere Arbeiten haben also eine positive Entwicklung in den Leistungen der LLMs gezeigt, die man als "entwicklungsbasierte" oder "evolutionäre" Bahn betrachten könnte, in der ein Individuum oder eine Spezies mit der Zeit immer mehr Fähigkeiten erwirbt.

Modelle, die sich verbessern können

Wir haben uns gefragt, ob es möglich ist, die Leistungen der Modelle mit "mittleren" Leistungen (d.h. diejenigen, die die Fragen beantworteten, aber kognitive Verzerrungen aufwiesen) zu verbessern. Wir haben sie dazu "verleitet", das Problem, das sie in die Irre geführt hatte, analytischer zu betrachten, was zu einer Leistungssteigerung führte.

Die einfachste Methode, die Leistungen der Modelle zu verbessern, besteht darin, sie einfach darum zu bitten, einen Schritt zurückzutreten und ihnen zu sagen, "Schritt für Schritt nachzudenken", bevor die Frage gestellt wird. Eine andere sehr effektive Lösung besteht darin, ihnen ein Beispiel eines korrekt gelösten Problems zu zeigen, was eine Form des schnellen Lernens ("one shot" auf Englisch) induziert.

Diese Ergebnisse zeigen erneut, dass die Leistungen dieser Modelle nicht feststehen, sondern plastisch sind; innerhalb eines einzigen Modells können anscheinend neutrale Änderungen des Kontexts die Leistungen verändern, ähnlich wie beim Menschen, bei dem Rahmen- und Kontexteffekte (die Tendenz, von der Art der Präsentation der Information beeinflusst zu werden) weit verbreitet sind.

Entwicklung der Leistungen der Modelle im Vergleich zu denen der Menschen (gestrichelte Linien).

S. Palmintieri, Autor bereitgestellt (keine Wiederverwendung)

Gleichzeitig haben wir festgestellt, dass sich die Verhaltensweisen der LLMs in vielerlei Hinsicht von denen der Menschen unterscheiden. Einerseits hatten wir bei einem Dutzend getesteter Modelle Schwierigkeiten, eines zu finden, das in der Lage war, das Niveau der korrekten Antworten, das Menschen bei denselben Fragen erzielen, korrekt zu approximieren. In unseren Tests waren die Ergebnisse der KI-Modelle entweder schlechter oder besser. Andererseits zeigte eine genauere Betrachtung der gestellten Fragen, dass die Fragen, die den Menschen die größten Schwierigkeiten bereiteten, nicht unbedingt als die schwierigsten von den Modellen wahrgenommen wurden.

Diese Beobachtungen legen nahe, dass wir menschliche Versuchsteilnehmer nicht durch LLMs ersetzen können, um die menschliche Psychologie zu verstehen, wie einige Autoren vorgeschlagen haben.

Schließlich haben wir auch ein relativ besorgniserregendes Phänomen in Bezug auf wissenschaftliche Reproduzierbarkeit beobachtet. Wir haben ChatGPT und GPT-4 im Abstand von einigen Monaten getestet und festgestellt, dass sich ihre Leistungen geändert hatten, jedoch nicht unbedingt zum Besseren.

Das liegt daran, dass OpenAI ihre Modelle leicht modifiziert hat, ohne die wissenschaftliche Gemeinschaft darüber zu informieren. Die Arbeit mit proprietären Modellen ist nicht gegen solche Unwägbarkeiten gefeit. Aus diesem Grund denken wir, dass die Zukunft der (kognitiven oder anderen) Forschung an den LLMs auf offenen und transparenten Modellen basieren sollte, um mehr Kontrolle zu gewährleisten.