Quando os psicólogos decifram o raciocínio das inteligências artificiais

Publicado por Adrien,

Fonte: The Conversation sob licença Creative Commons

Outras Línguas: FR, EN, DE, ES

Fonte: The Conversation sob licença Creative Commons

Outras Línguas: FR, EN, DE, ES

Você conhece os grandes modelos de linguagem (LLM para "large language models" em inglês)? Mesmo que essa expressão lhe pareça obscura, é bem provável que você já tenha ouvido falar do mais famoso deles: o ChatGPT, da empresa californiana OpenAI.

A implantação de tais modelos de inteligência artificial (IA) pode ter consequências difíceis de apreender. De fato, é complicado prever precisamente como se comportarão os LLM, cuja complexidade é comparável à do cérebro humano. Um certo número de suas capacidades foi descoberto ao longo de seu uso, em vez de previsto no momento da concepção.

Para entender esses "comportamentos emergentes", novas investigações devem ser realizadas. Com esse objetivo, em nossa equipe de pesquisa, utilizamos ferramentas de psicologia cognitiva tradicionalmente usadas para estudar a racionalidade em seres humanos para analisar o raciocínio de diferentes LLMs, entre os quais o ChatGPT.

Nossos trabalhos destacaram a existência de erros de raciocínio nessas inteligências artificiais. Explicações.

O que são os "large language models"?

Os modelos de linguagem são modelos de inteligência artificial capazes de compreender e gerar linguagem humana. Simplificadamente falando, os modelos de linguagem são capazes de prever, de acordo com o contexto, as palavras que têm maior probabilidade de aparecer em uma frase.

Os LLM são algoritmos de redes neurais artificiais. Inspirados pelo funcionamento das redes neurais biológicas que compõem o cérebro humano, os nós de uma rede de vários neurônios artificiais geralmente recebem várias informações de entrada e, após o processamento, geram um valor de saída.

Os LLM se diferenciam dos algoritmos de redes neurais artificiais "clássicas" que compõem os modelos de linguagem pelo fato de serem baseados em uma arquitetura específica, serem treinados em enormes bases de dados e terem um tamanho geralmente gigantesco (da ordem de vários bilhões de "neurônios").

Devido ao seu tamanho e estrutura (mas também à forma como são treinados), os LLMs demonstraram desde o início de sua utilização desempenhos impressionantes nas tarefas para as quais foram designados, seja criação de texto, tradução ou correção.

Mas não é só isso: os LLM também apresentaram desempenhos relativamente surpreendentes em uma variedade de tarefas diversas e variadas, desde matemática até formas básicas de raciocínio.

Em outras palavras, os LLMs rapidamente manifestaram capacidades que não eram necessariamente previsíveis por meio de sua programação. Além disso, eles parecem ser capazes de aprender a realizar novas tarefas a partir de poucos exemplos.

Essas capacidades criaram pela primeira vez uma situação particular no campo da inteligência artificial: temos agora sistemas tão complexos que não podemos prever antecipadamente a extensão de suas capacidades. De certa forma, precisamos "descobrir" suas capacidades cognitivas de maneira experimental.

Com base nessa constatação, postulamos que as ferramentas desenvolvidas no campo da psicologia poderiam ser relevantes para estudar os LLMs.

Por que estudar o raciocínio nos grandes modelos de linguagem?

Um dos principais objetivos da psicologia científica (experimental, comportamental e cognitiva) é tentar entender os mecanismos subjacentes às capacidades e aos comportamentos de redes neurais extremamente complexas: as dos cérebros humanos.

Nosso laboratório é especializado no estudo de vieses cognitivos em humanos, e a primeira ideia que nos veio à mente foi tentar determinar se os LLMs também apresentavam vieses de raciocínio.

Dado o papel que essas máquinas poderiam vir a desempenhar em nossas vidas, entender como elas raciocinam e tomam decisões é fundamental. Além disso, os psicólogos também podem se beneficiar desses estudos. De fato, as redes neurais artificiais, que podem realizar tarefas em que o cérebro humano é excelente (reconhecimento de objetos, processamento da fala...), poderiam também servir como modelos cognitivos.

Um número crescente de indícios sugere, entre outras coisas, que as redes neurais implementadas nos LLM fornecem previsões precisas sobre a atividade neural envolvida em processos como a visão e o processamento da linguagem.

Assim, foi demonstrado que a atividade neural das redes de neurônios treinadas para o reconhecimento de objetos correlaciona-se significativamente com a atividade neural registrada no córtex visual de um indivíduo realizando a mesma tarefa.

Isso também ocorre em relação à previsão de dados comportamentais, especialmente em aprendizado.

Desempenhos que acabaram superando os dos humanos

Em nossos trabalhos, focamos principalmente nos LLMs da OpenAI (a empresa por trás do modelo de linguagem GPT-3, utilizado nas primeiras versões do ChatGPT), pois esses LLMs eram os mais avançados na época. Testamos várias versões do GPT-3, bem como o ChatGPT e o GPT-4.

Para testar esses modelos, desenvolvemos uma interface que permite enviar perguntas e coletar respostas dos modelos automaticamente, o que nos permitiu adquirir uma grande quantidade de dados.

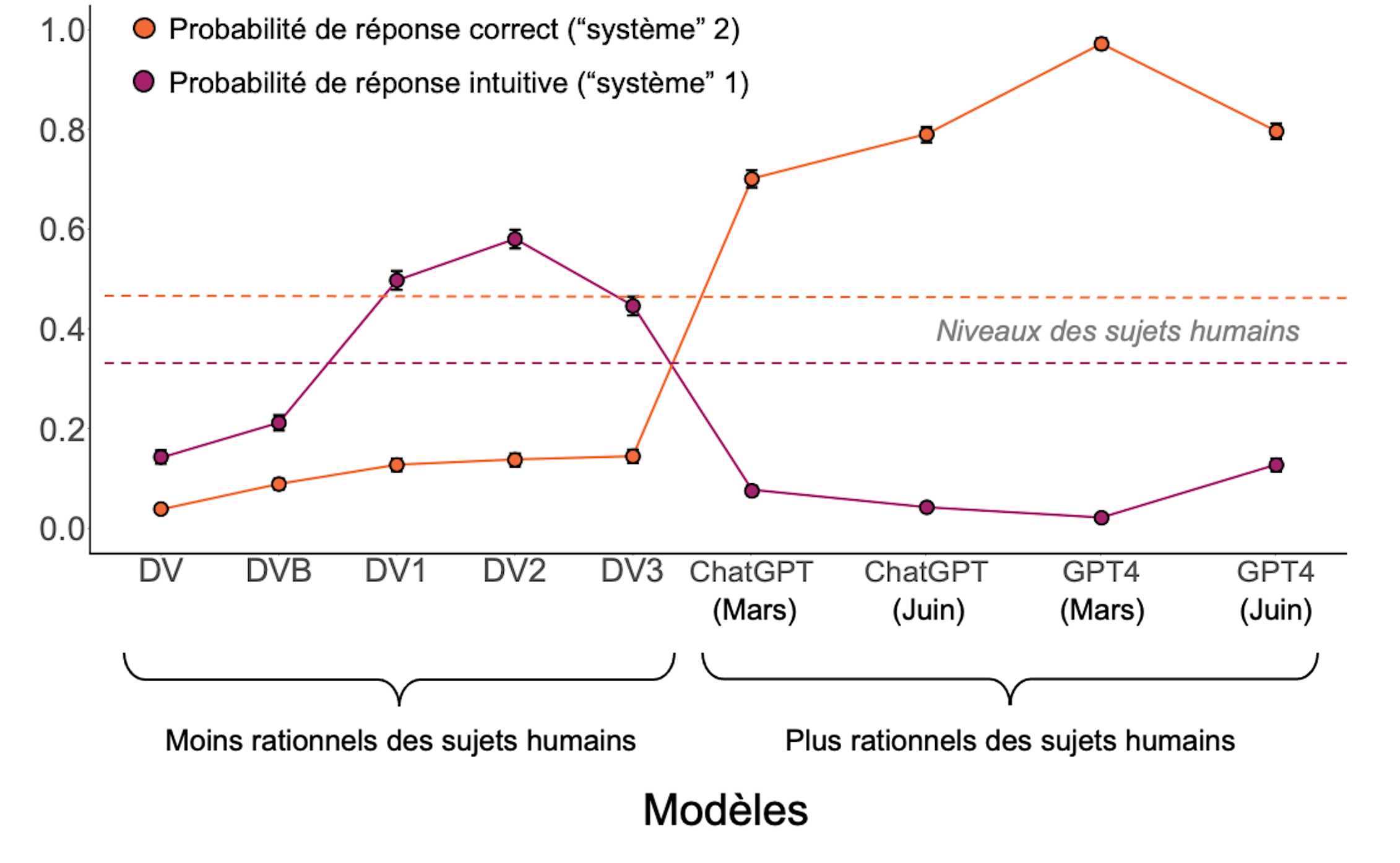

A análise desses dados revelou que os desempenhos desses LLMs apresentavam perfis de comportamento que podiam ser classificados em três categorias.

Os modelos mais antigos eram simplesmente incapazes de responder às perguntas de maneira coerente.

Os modelos intermediários respondiam às perguntas, mas frequentemente se envolviam em raciocínios intuitivos que os levavam a cometer erros, semelhantes aos humanos. Eles pareciam privilegiar o "sistema 1", mencionado pelo psicólogo e Prêmio Nobel de Economia Daniel Kahneman em sua teoria dos modos de pensamento.

No ser humano, o sistema 1 é um modo de raciocínio rápido, instintivo e emocional, enquanto o sistema 2 é mais lento, refletido e lógico. Embora seja mais suscetível a vieses de raciocínio, o sistema 1 é, no entanto, privilegiado, porque é mais rápido e menos dispendioso em termos de energia do que o sistema 2.

Aqui está um exemplo de erros de raciocínio que testamos, tirado do "Cognitive Reflection Test":

- Pergunta feita: Um taco e uma bola custam 1,10 dólar no total. O taco custa 1,00 dólar a mais que a bola. Quanto custa a bola?

- Resposta intuitiva ("sistema 1"): 0,10 dólar;

- Resposta correta ("sistema 2"): 0,05 dólar.

Finalmente, a última geração (ChatGPT e GPT-4) apresentava desempenhos que superavam os dos seres humanos.

Nossos trabalhos permitiram, portanto, identificar uma trajetória positiva nos desempenhos dos LLMs, que poderia ser concebida como uma trajetória "desenvolvimental" ou "evolutiva", na qual um indivíduo ou uma espécie adquire cada vez mais competências com o tempo.

Modelos que podem melhorar

Nos perguntamos se seria possível melhorar os desempenhos dos modelos que apresentavam desempenhos "intermediários" (ou seja, aqueles que respondiam às perguntas, mas apresentavam vieses cognitivos). Para isso, "incitamos" os modelos a abordar o problema que os havia induzido ao erro de forma mais analítica, o que resultou em um aumento nos desempenhos.

A maneira mais simples de melhorar os desempenhos dos modelos é simplesmente pedir-lhes que reflitam devagar, solicitando-lhes "pensar passo a passo" antes de responder. Outra solução muito eficaz é mostrar um exemplo de um problema resolvido corretamente, o que induz uma forma de aprendizado rápido ("one shot", em inglês).

Esses resultados indicam novamente que os desempenhos desses modelos não são fixos, mas plásticos; dentro de um mesmo modelo, modificações aparentemente neutras do contexto podem alterar os desempenhos, um pouco como nos humanos, onde os efeitos de enquadramento e contexto (tendência a ser influenciado pela forma como a informação é apresentada) são muito comuns.

Evolução dos desempenhos dos modelos em comparação com os dos seres humanos (linhas pontilhadas).

S. Palmintieri, Autor fornecido (não reutilizar)

Por outro lado, também constatamos que os comportamentos dos LLMs diferem dos humanos em muitos pontos. Por um lado, entre a dúzia de modelos testados, tivemos dificuldades em encontrar um que fosse capaz de aproximar corretamente o nível de respostas corretas fornecidas, às mesmas perguntas, por seres humanos. Em nossas experiências, os resultados dos modelos de IA eram ou menos bons, ou melhores. Por outro lado, ao examinar mais detalhadamente as perguntas feitas, as que mais dificultavam para os humanos não eram necessariamente percebidas como as mais difíceis pelos modelos.

Essas observações sugerem que não podemos substituir os sujeitos humanos por LLMs para entender a psicologia humana, como alguns autores sugeriram.

Finalmente, também observamos um fato relativamente preocupante do ponto de vista da reprodutibilidade científica. Testamos o ChatGPT e o GPT-4 em intervalos de alguns meses e observamos que seus desempenhos haviam mudado, mas não necessariamente para melhor.

Isso corresponde ao fato de que a OpenAI havia modificado ligeiramente seus modelos, sem necessariamente informar a comunidade científica. Trabalhar com modelos proprietários não está imune a esses problemas. Por esta razão, acreditamos que o futuro da pesquisa (cognitiva ou outra) sobre os LLMs deve basear-se em modelos abertos e transparentes para garantir mais controle.