Cuando los psicólogos descifran el razonamiento de las inteligencias artificiales

Publicado por Adrien,

Fuente: The Conversation bajo licencia Creative Commons

Otros Idiomas: FR, EN, DE, PT

Fuente: The Conversation bajo licencia Creative Commons

Otros Idiomas: FR, EN, DE, PT

¿Conoces los grandes modelos de lenguaje (LLM por "large language models" en inglés)? Aunque esta expresión te resulte desconocida, es muy probable que hayas oído hablar del más famoso de ellos: ChatGPT, de la empresa californiana OpenAI.

El despliegue de tales modelos de inteligencia artificial (IA) podría tener consecuencias difíciles de comprender. De hecho, es complicado prever con precisión cómo se comportarán los LLM, cuya complejidad es comparable a la del cerebro humano. Un número de sus capacidades se ha descubierto con el uso más que previsto en su diseño inicial.

Para entender estos "comportamientos emergentes", deben realizarse nuevas investigaciones. Con este objetivo, en nuestro equipo de investigación hemos utilizado herramientas de la psicología cognitiva tradicionalmente utilizadas para estudiar la racionalidad en los seres humanos con el fin de analizar el razonamiento de diferentes LLM, entre los cuales está ChatGPT.

Nuestros trabajos han permitido evidenciar la existencia de errores de razonamiento en estas inteligencias artificiales. Explicaciones.

¿Qué son los "large language models"?

Los modelos de lenguaje son modelos de inteligencia artificial capaces de comprender y generar lenguaje humano. En términos esquemáticos, los modelos de lenguaje pueden predecir, en función del contexto, las palabras que tienen mayor probabilidad de aparecer en una frase.

Los LLM son algoritmos basados en redes neuronales artificiales. Inspirados en el funcionamiento de las redes neuronales biológicas que componen el cerebro humano, los nodos de una red de varios neurones artificiales generalmente reciben múltiples valores de entrada y generan luego, tras su procesamiento, un valor de salida.

Los LLM se distinguen de los algoritmos de redes neuronales artificiales "clásicos" que componen los modelos de lenguaje por estar basados en una arquitectura específica, ser entrenados con enormes bases de datos y tener un tamaño generalmente gigantesco (del orden de varios miles de millones de "neuronas").

Debido a su tamaño y estructura (pero también a la forma en que son entrenados), los LLM han mostrado desde el inicio de su uso rendimientos impresionantes en las tareas propias, ya sea creación de texto, traducción o corrección.

Pero no es todo: los LLM también han demostrado rendimientos relativamente sorprendentes en una variedad de tareas diversas, desde matemáticas hasta formas básicas de razonamiento.

En otras palabras, los LLM rápidamente manifestaron capacidades que no necesariamente eran explícitamente predecibles por su programación. Más aún, parecen ser capaces de aprender a realizar nuevas tareas a partir de muy pocos ejemplos.

Estas capacidades han creado por primera vez una situación particular en el campo de la inteligencia artificial: ahora disponemos de sistemas tan complejos que no podemos prever de antemano el alcance de sus capacidades. De alguna manera, debemos "descubrir" sus capacidades cognitivas de forma experimental.

Partiendo de esta premisa, postulamos que las herramientas desarrolladas en el campo de la psicología podrían ser pertinentes para estudiar los LLM.

¿Por qué estudiar el razonamiento en los grandes modelos de lenguaje?

Uno de los principales objetivos de la psicología científica (experimental, conductual y cognitiva) es intentar comprender los mecanismos subyacentes a las capacidades y comportamientos de redes neuronales extremadamente complejas: las del cerebro humano.

Nuestro laboratorio, especializado en el estudio de sesgos cognitivos en humanos, tuvo la primera idea de intentar determinar si los LLM también presentaban sesgos de razonamiento.

Dado el rol que estas máquinas podrían llegar a tener en nuestras vidas, comprender cómo razonan y toman decisiones es fundamental. Por otra parte, los psicólogos también pueden beneficiarse de estos estudios. De hecho, las redes neuronales artificiales, que pueden realizar tareas en las que el cerebro humano sobresale (reconocimiento de objetos, procesamiento del habla...), también podrían servir como modelos cognitivos.

Un número creciente de evidencias sugiere que las redes neuronales implementadas en los LLM proporcionan no solo predicciones precisas sobre la actividad neuronal involucrada en procesos como la visión y el procesamiento del lenguaje.

Así, se ha demostrado que la actividad neuronal de las redes de neuronas entrenadas para el reconocimiento de objetos correlaciona significativamente con la actividad neuronal registrada en el córtex visual de un individuo realizando la misma tarea.

Esto también es cierto para la predicción de datos conductuales, especialmente en aprendizaje.

Rendimientos que terminaron superando a los humanos

En nuestros trabajos, nos hemos principalmente centrado en los LLM de OpenAI (la empresa que creó el modelo de lenguaje GPT-3, utilizado en las primeras versiones de ChatGPT), ya que estos LLM eran en ese momento los más avanzados en el panorama. Probamos varias versiones de GPT-3, así como ChatGPT y GPT-4.

Para probar estos modelos, desarrollamos una interfaz que permite enviar preguntas y recolectar respuestas de los modelos de forma automática, lo que nos permitió adquirir una gran cantidad de datos.

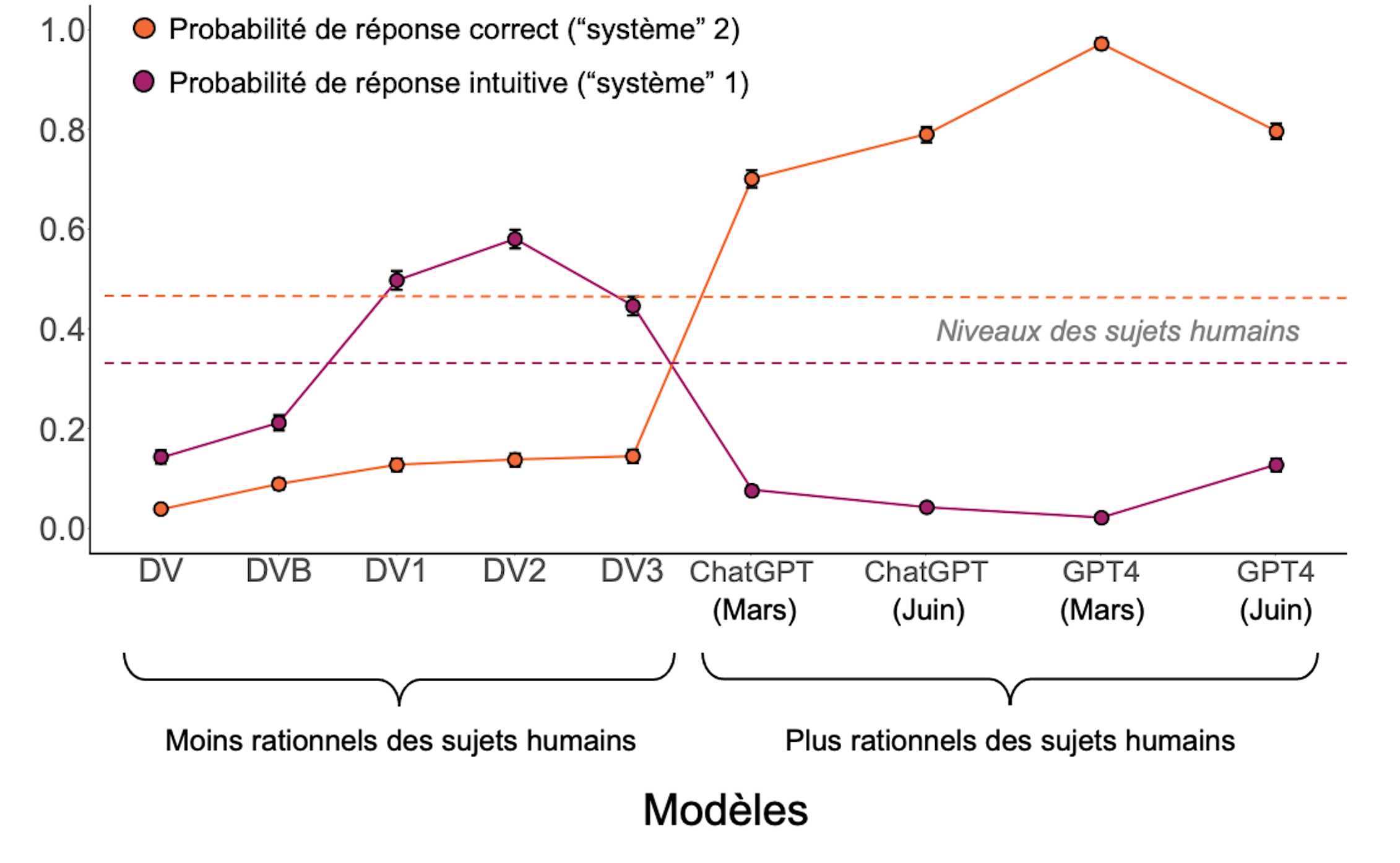

El análisis de estos datos reveló que los rendimientos de estos LLM presentaban perfiles de comportamiento que podían clasificarse en tres categorías.

Los modelos más antiguos eran simplemente incapaces de responder a las preguntas de manera coherente.

Los modelos intermedios respondían a las preguntas, pero a menudo incurrían en razonamientos intuitivos que los llevaban a cometer errores, similares a los observados en los seres humanos. Parecían privilegiar el "sistema 1", mencionado por el psicólogo y Premio Nobel de Economía Daniel Kahneman en su teoría de los modos de pensamiento.

En los seres humanos, el sistema 1 es un modo de razonamiento rápido, instintivo y emocional, mientras que el sistema 2 es más lento, reflexivo y lógico. Aunque es más susceptible a sesgos de razonamiento, el sistema 1 sería privilegiado por ser más rápido y menos costoso en términos de energía que el sistema 2.

He aquí un ejemplo de errores de razonamiento que hemos probado, extraído del "Cognitive Reflection Test":

- Pregunta: Un bate y una pelota cuestan en total 1,10 dólares. El bate cuesta 1,00 dólar más que la pelota. ¿Cuánto cuesta la pelota?

- Respuesta intuitiva ("sistema 1"): 0,10 dólares;

- Respuesta correcta ("sistema 2"): 0,05 dólares.

Finalmente, la última generación (ChatGPT y GPT-4) presentó rendimientos que superaban a los seres humanos.

Nuestros trabajos han permitido identificar una trayectoria positiva en los rendimientos de los LLM, que podría concebirse como una trayectoria "desarrollamental" o "evolutiva" donde un individuo o una especie adquiere cada vez más competencias con el tiempo.

Modelos que pueden mejorar

Nos preguntamos si era posible mejorar los rendimientos de los modelos de rendimiento "intermedio" (es decir, aquellos que respondían a las preguntas, pero presentaban sesgos cognitivos). Para ello, los "incitamos" a abordar el problema que los había inducido en error de manera más analítica, lo que resultó en un aumento de los rendimientos.

La forma más sencilla de mejorar los rendimientos de los modelos es simplemente pedirles que tomen distancia, solicitándoles "pensar paso a paso" antes de hacerles la pregunta. Otra solución muy eficaz consiste en mostrarles un ejemplo de un problema correctamente resuelto, lo que induce una forma de aprendizaje rápido ("one shot" en inglés).

Estos resultados indican una vez más que los rendimientos de estos modelos no son fijos, sino plásticos; dentro de un mismo modelo, modificaciones aparentemente neutras del contexto pueden cambiar los rendimientos, similar a los humanos, donde los efectos de encuadre y contexto (tendencia a ser influenciado por la forma en que se presenta la información) son muy comunes.

Evolución de los rendimientos de los modelos en comparación con los seres humanos (líneas discontinuas).

S. Palmintieri, Author provided (no reuse)

En cambio, también hemos observado que los comportamientos de los LLM difieren de los humanos en muchos puntos. Por una parte, entre la docena de modelos probados, tuvimos dificultades para encontrar uno que fuera capaz de aproximar correctamente el nivel de respuestas correctas proporcionadas, a las mismas preguntas, por seres humanos. En nuestros experimentos, los resultados de los modelos IA eran o menos buenos, o mejores). Por otra parte, al examinar más en detalle las preguntas planteadas, aquellas que planteaban mayores dificultades a los humanos no eran necesariamente percibidas como las más difíciles por los modelos.

Estas observaciones sugieren que no podemos sustituir los sujetos humanos por LLM para entender la psicología humana, como algunos autores han sugerido.

Finalmente, también observamos un hecho relativamente inquietante desde el punto de vista de la reproducibilidad científica. Probamos ChatGPT y GPT-4 con algunos meses de diferencia y observamos que sus rendimientos habían cambiado, pero no necesariamente para mejor.

Esto corresponde al hecho de que OpenAI ha modificado ligeramente sus modelos, sin necesariamente informar a la comunidad científica. Trabajar con modelos propietarios no está exento de estos riesgos. Por esta razón, creemos que el futuro de la investigación (cognitiva o de otro tipo) sobre los LLM debe basarse en modelos abiertos y transparentes para garantizar un mayor control.