Indépendance en probabilité élémentaire - Définition

Cet article fait partie de la série Mathématiques élémentaires |

| Algèbre |

| Analyse |

| Arithmétique |

| Géométrie |

| Logique |

| Probabilité |

| Statistique |

L'étude de l'indépendance d'événements ou d'expériences consiste à chercher si les événements ou les expériences sont liées ou se produisent indépendamment l'une de l'autre (On peut raisonnablement penser que le fait de boire de l'alcool et celui de provoquer un accident ne sont pas indépendants l'un de l'autre). Les probabilités ont construit leur définition de l'indépendance à partir de la notion d'indépendance en statistique: un caractère statistique est indépendant du sexe, par exemple, si la distribution du caractère est identique, que l'on prenne la population totale, la population masculine ou la population féminine.

Indépendance d'événements

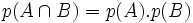

Si A et B sont deux événements de probabilité non nulle, on dit que A et B sont indépendants si

- p(B) = pA(B) (la distribution de B dans l'univers entier est identique à celle de B dans le sous-univers A)

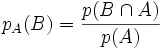

La définition de la probabilité conditionnelle de B sachant A :

-

- p(A) = pB(A)

Remarque : La probabilité de A sachant B peut également s'écrire p(A|B)

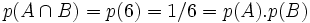

Exemple 1: Dans le lancer d'un dé équilibré, les événements A="obtenir un numéro pair" et B = " obtenir un multiple de 3 " sont des événements indépendants. En effet, la répartition des nombres pairs dans l'univers Ω={1 ; 2 ; 3; 4 ; 5 ; 6} est identique à celle des nombres pairs dans B = {3 ; 6}.

Traduit sous forme de probabilité, cela donne p(A) = pB(A) = 1 / 2.

On aurait pu aussi tout simplement observer que p(A) = 1/2, p(B) = 1/3 et que

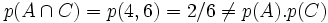

D'autre part, les événements A = " obtenir un nombre pair " et C = " obtenir au moins 4 " = {4 ; 5 ; 6} ne sont pas indépendants car la répartition des nombres pairs dans l'univers de départ est de 1/2 et la répartition dans le sous-univers C est de 2/3.

On pouvait aussi tout simplement observer que

Exemple 2 : Deux événements incompatibles, de probabilité non nulle ne sont jamais indépendants. En effet, leur intersection étant vide, la probabilité de l'intersection est nulle alors que ni p(A), ni p(B) n'est nul.

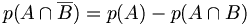

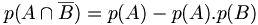

Exemple 3: Si deux événements A et B sont indépendants alors A et

Indépendance d'expériences

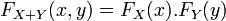

On considère une expérience 1 conduisant la création d'un univers Ω1 muni d'une probabilité p1, suivi d'une expérience 2 conduisant à la création d'un univers Ω2 muni d'une probabilité p2. La succession des deux expériences conduit à la création d'un univers Ω formé de couples d'éléments de Ω1 et Ω2, cet univers se note Ω1 × Ω2. On dira que les expériences sont indépendantes si on peut créer sur Ω une probabilité p produit des deux précédentes telle que p(A × B) = p1(A).p2(B) pour tout événement A de Ω1 et B de Ω2.

Exemples: La succession de deux tirages avec remise dans une urne constitue deux expériences indépendantes identiques. Le lancer successif d'un pièce et d'un dé constitue deux expériences indépendantes. La succession de deux tirages successifs sans remise ne constitue pas deux expériences indépendantes, le deuxième univers changeant en fonction du résultat du premier tirage.

Le cas le plus classique de successions d'expériences indépendantes identiques est la succession de n expériences de Bernoulli conduisant à la création de la loi binomiale.

Dans la loi des grands nombres, on considère aussi la succession de n expériences indépendantes.

Indépendances de variables aléatoires

Dans le cas de variables aléatoires X et Y définies sur un univers Ω fini, on dira que les variables aléatoires X et Y sont indépendantes si les événements " X=xi " et " Y=yj " sont indépendants pour tout xi de X(Ω) et tout yj de Y(Ω) .

L'indépendance de variables aléatoires X et Y continues sort du cadre des mathématiques élémentaires. Deux variables aléatoires X et Y continues sont indépendantes lorsque

c'est-à-dire

-

On démontre que lorsque les variables aléatoires sont indépendantes, la covariance de (X ,Y) est nulle et V(X + Y) = V(X) + V(Y).

![P[X \le x\ \ et Y \le y] = P[X \le x] . P[Y \le y]](https://static.techno-science.net/illustration/Definitions/autres/4/49fab6da42e251d879bdccce3f6a1942_d2be70b10a7271caeaf1720a5998744e.png)