Statistique - Définition

La liste des auteurs de cet article est disponible ici.

Introduction

Une statistique est, au premier abord, un nombre calculé à propos d'un échantillon. D'une façon générale, c'est le résultat de l'application d'une méthode statistique à un ensemble de données. Dans le calcul de la moyenne arithmétique, par exemple, l'algorithme consiste à calculer la somme de toutes les valeurs des données et à diviser par le nombre de données. La moyenne est ainsi une statistique. Pour être complet dans la description de l'utilisation d'une statistique, il faut décrire à la fois la procédure et l'ensemble de données.

De façon formelle bien que cela soit rarement utilisé une statistique est une variable aléatoire d'un type particulier. C'est en effet une fonction d'un vecteur composée de plusieurs observations d'une loi. Cela permet entre autres d'étendre aux statistiques un certain nombre de résultats sur les variables aléatoires entre autres le caractère indépendant de deux statistiques ou calculer des densités de statistiques.

Parmi les statistiques un certain nombre ont des propriétés particulières qui servent entre autres en Inférence statistique pour l'estimation statistique. Les estimateurs servent, comme leur nom l'indique, à estimer des paramètres statistiques. L'optimisation de ces estimateurs peut également faire intervenir des statistiques auxiliaires vérifiant certaines propriétés et qui permettent de faire converger plus vite ces estimateurs.

Estimateurs

En statistique inférentielle, un estimateur est une valeur calculée sur un échantillon et que l'on espère être une bonne évaluation de la valeur que l'on aurait calculée sur la population totale. On cherche à ce qu'un estimateur soit sans biais, convergent, efficace et robuste.

Principales propriétés souhaitables

Si

- Convergent si:

- Sans biais si:

Ces deux propriétés sont essentielles et en règle générale on considère que tout estimateur devrait au moins vérifier ces deux propriétés pour qu'on puisse le considérer comme suffisamment précis. On peut de plus vouloir qu'un estimateur soit efficace (c'est-à-dire que l'estimation qu'il fournit varie le moins possible autour de la valeur à estimer) ou robuste (c'est-à-dire qu'il soit peu sensible aux variations d'une mesure sur les n). Ces deux propriétés sont détaillées plus bas dans les sections Optimisation d'estimateur et Robustesse.

Optimisation d'estimateurs

L'optimisation d'estimateurs peut se faire grâce à l'usage de statistiques exhaustives. Une méthode possible pour trouver de "bons" estimateurs est de prendre un premier estimateur sans biais de la valeur à estimer sans trop chercher à l'optimiser. Ensuite on optimise cet estimateur en se servant de statistiques exhaustives.

Cette méthode repose principalement sur deux théorèmes : le théorème de Rao-Blackwell qui fournit un deuxième estimateur de meilleur qualité appelé estimateur augmenté et le théorème de Lehman-Scheffer qui donne des conditions suffisantes pour que cet estimateur soit optimal.

Estimateurs augmentés et Théorème de Rao-Blackwell

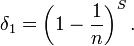

Si δ est un estimateur sans biais et S une statistique exhaustive alors l'estimateur augmenté

Dans le cas multiparamétrique où l'estimateur et le paramètre sont de dimension supérieure 1, on considère la matrice de variance-covariance. L'erreur quadratique du nouvel estimateur est toujours plus faible que celui de l'ancien estimateur et ce quelle que soit la norme utilisée. Même si les différentes composantes ne sont pas normées de la même façon l'estimateur augmenté est toujours préférable.

Exemple

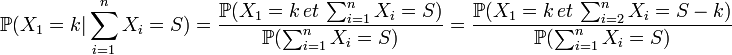

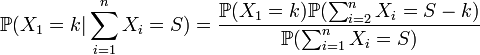

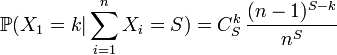

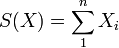

On considère donc n variables aléatoires Xi distribués selon des lois de Poisson de paramètre λ et l'on cherche à estimer e − λ. On peut montrer assez facilement en considérant le critère de factorisation que

On peut montrer que:

Et avec l'indépendance de Xi:

δ1 est tout comme de δ0 un estimateur de e − λ mais à l'avantage d'être beaucoup plus précis grâce à l'application du théorème de Rao–Blackwell. En fait, on montre avec Théorème de Lehman Scheffé qu'il est même optimal.

On remarquera entre autres que

Statistique complète et Théorème de Lehman Scheffé

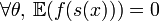

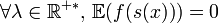

On dit qu'une statistique est complète (on dit parfois totale) si :

Le théorème de Lehman-Scheffé a une importance particulière en statistiques puisqu'il permet de trouver des estimateurs optimaux qui ne peuvent pas être améliorés en termes de précision car ils atteignent la borne FDCR. De tels estimateurs n'existent pas forcément mais si l'on dispose d'une statistique qui soit à la fois complète et totale et d'un estimateur δ qui soit sans biais alors l'estimateur augmenté

Exemple

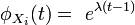

Montrons par exemple que pour une loi exponentielle de paramètres λ la moyenne des observations est le meilleure estimateur possible pour λ. Si l'on a un vecteur des observations X de taille n avec les Xi de loi exponentielle (λ,σ) on commence par montrer que

Pour montrer que cette statistique est exhaustive cela se fait relativement simplement grâce au théorème de factorisation. Pour montrer le fait que cette statistique est complète il faut utiliser l'injectivité de la transformée de Laplace.

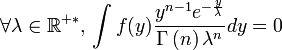

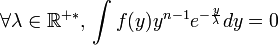

Pour montrer que c'est bien une statistique complète il faut vérifier que:

Une fois montré que la statistique S est à la fois complète et exhaustive l'estimateur de la moyenne