Moindres carrés non linéaires - Définition

La liste des auteurs de cet article est disponible ici.

Introduction

Les moindres carrés non linéaires est une forme des moindres carrés spécialisée dans l'estimation d'un modèle non linéaire en n paramètres à partir de m observations (m > n). Une façon d'estimer ce genre de problème est de considérer des itérations successives se basant sur une version linéarisée du modèle initial.

La théorie

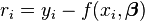

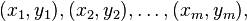

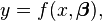

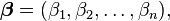

Considérons un jeu de m couples d'observations,

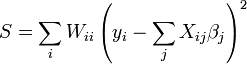

est minimisée en

pour

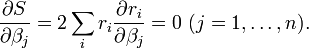

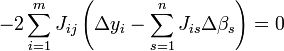

Le minimum de la somme des carrés des résidus S est atteint lorsque le Gradient s'annule (condition nécessaire). Puisque le problème est formulé avec n paramètres, il y a donc n équations normales:

Dans un système non linéaire, les dérivées

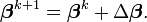

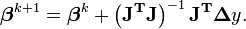

qui fournit des approximations successives

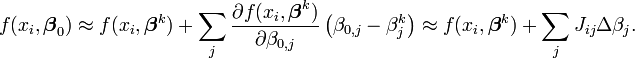

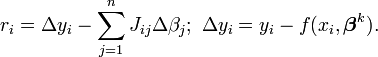

À chaque itération, le modèle initial est linéarisé par un développement de Taylor autour de

La Matrice jacobienne, J, dépend des données et de l'approximation en cours, aussi change-t-elle d'une itération à l'autre. Ainsi, en terme du modèle linéarisé,

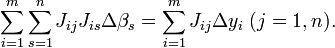

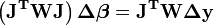

Les équations normales deviennent

ou encore

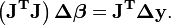

Matriciellement, on en arrive à

La linéarisation permet donc d'écrire:

Il faut remarquer que l'ensemble du terme de droite dépend seulement de l'itération en cours, à savoir

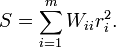

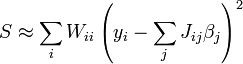

On peut aisément généraliser l'approche précédente en considérant une somme pondérée des carrés des résidus

Idéalement, chaque élément de la matrice diagonale de pondération W devrait être égal à l'inverse de la variance de l'observation Les équations normales deviennent alors

ce qui procure la base de l'algorithme d'optimisation de Gauss-Newton.

Différences entre les moindres carrés linéaires et non-linéaires

Il y a de nombreuses divergences entre les moindres carrés linéaires (MCL) et non-linéaires (MCN):

- Les MCN est un procédé itératif, qui nécessite donc un point de départ et des critères d'arrêt. Les MCL sont directs (algèbre linéaire);

- Les MCN nécessitent de calculer la matrice jacobienne (dérivées premières). Une expression analytique peut être compliquée à obtenir: si c'est le cas, une différentiation numérique s'impose;

- La divergence est un problème courant des MCN: en effet, il n'est pas rare de voir augmenter la fonction objectif (somme des carrés des résidus) d'une itération à l'autre. Cela peut être dû au manque de précision de l'approximation linéaire par le développement de Taylor;

- Pour les MCL, la solution est unique mais pas pour les MCN: plusieurs minima (locaux) peuvent exister.

Interprétation géométrique

Dans le cas des moindres carrés linéaires, la fonction objectif S est une fonction quadratique des paramètres

Lorsqu'il y a un seul paramètre à estimer β, la fonction S est une parabole en β. Pour deux paramètres ou plus, le contour de S est constitué d'ellipses concentriques, à condition que la matrice

Dans le cas non linéaire, le contour en ellipses concentriques n'est vrai qu'au voisinage du minimum, puisque dans ce cas l'approximation linéaire de Taylor s'avère être une bonne approximation de la fonction objectif.

Plus les paramètres s'éloignent de leur valeur optimale, plus le contour dévie de sa forme ellipsoïdale. Ceci signifie qu'il est essentiel de choisir l'approximation initiale