Matrice de variance-covariance - Définition

La liste des auteurs de cet article est disponible ici.

Introduction

Une matrice de variance-covariance est une matrice carrée caractérisant les interactions (linéaires) entre p variables aléatoires

Définition

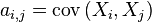

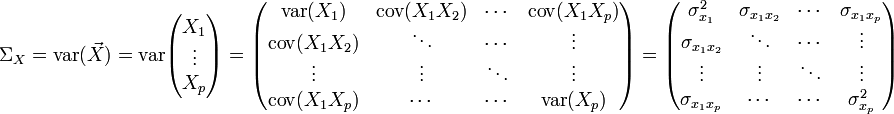

La matrice de variance-covariance (ou simplement matrice de covariance) d'un vecteur de p variables aléatoires

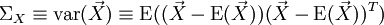

La matrice de variance-covariance, notée parfois

En développant les termes:

Estimation

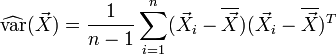

Un estimateur non-biaisé de la matrice de variance-covariance peut être obtenu par:

-

- où

- où

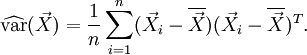

L'estimateur du maximum de vraisemblance, sous l'hypothèse que X suit une loi normale multidimensionnelle, vaut par contre:

Dans le cas où les données sont générées par une loi normale multidimensionnelle, l'estimateur du maximum de vraisemblance suit une loi de Wishart (en)

Propriétés

- La matrice est symétrique, étant donné la propriété que

- Ses valeurs propres sont positives ou nulles. Lorsqu'il n'existe aucune relation affine presque sûre entre les composantes du vecteur aléatoire, la matrice

- Les éléments de sa diagonale représentent la variance de chaque variable, étant donné la propriété que:

- Les éléments en dehors de la diagonale représentent la covariance entre les variables i et j quand

Test sur la matrice de variance-covariance

Le test de sphéricité de Bartlett permet de déterminer si les composantes hors de la diagonale de la matrice sont différentes de zéro, i.e. si il y a une relation entre les différentes variables prises en considération.

Utilisation en statistique

La matrice de variance-covariance est un outil essentiel pour l'analyse multivariée:

- L'analyse en composantes principales se base sur une décomposition de la matrice de variance-covariance.

- L'analyse discriminante l'utilise.