Apprentissage par renforcement - Définition

La liste des auteurs de cet article est disponible ici.

Algorithme

On donne ici une version algorithmique basique de l'apprentissage par renforcement, particulièrement du TD-learning. Cette version a pour but de permettre au lecteur intéressé de faire une rapide implémentation informatique de l'algorithme afin d'en mieux comprendre le fonctionnement itératif. On se place ici dans le cas le plus simple où on ne cherche pas à améliorer le comportement (ou politique) de l'agent, mais on cherche à évaluer une politique donnée lorsqu'elle est mise en œuvre par un agent dans un environnement donné.

- On initialise V(s) aléatoirement, qui est la valeur que l'agent attribuera à chaque état s.

- On initialise la politique π à évaluer.

- On répète (pour chaque épisode) :

- On initialise s

- On répète (à chaque pas de temps de l'épisode) :

- a ← action donnée par π pour s

- L'agent effectue l'action a; on observe la récompense r et l'état suivant s'

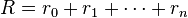

- V(s) ← V(s) + α [r + γV(s') - V(s)]

- s ← s'

- Jusqu'à ce que s soit terminal

Pour plus de détails concernant l'implémentation de cet algorithme, ou concernant la version algorithmique du Q-learning, se référer au livre de Sutton et Barto publié en 1998, dont la totalité du contenu est disponible librement sur Internet (voir le lien externe à la fin de cet article).

Formalisme

Formellement, la base du modèle d'apprentissage par renforcement consiste en:

1. un ensemble d'états S de l'agent dans l'environnement;

2. un ensemble d'actions A que l'agent peut effectuer;

3. un ensemble de valeurs scalaires "récompenses" R que l'agent peut obtenir.

À chaque pas de temps t de l'algorithme, l'agent perçoit son état

Ainsi, la méthode de l'apprentissage par renforcement est particulièrement adapté aux problèmes nécessitant un compromis entre la quête de récompenses à court terme et celle de récompenses à long terme. Cette méthode a été appliquée avec succès à des problèmes variés, tels que le contrôle robotique, le pendule inversé, la planification de tâches, les télécommunications, le backgammon et les échecs.