Test de Turing - Définition

La liste des auteurs de cet article est disponible ici.

Objections et réponses

Turing lui-même a suggéré de nombreuses objections qui peuvent être faites au test et en a donné une réponse dans sa publication initiale :

- Objection théologique : la pensée serait le fait inné de l’âme dont l’homme serait seul doté, et ainsi la machine ne saurait pas penser. Turing répond qu’il ne voit aucune raison pour laquelle Dieu ne pourrait donner à un ordinateur une âme s’il le souhaitait.

- Argument de la conscience : cet argument suggéré par le professeur Geoffrey Jefferson dit que « aucune machine ne peut écrire un sonnet ou composer un concerto à cause de l’absence d’émotion, et même en alignant des notes au hasard, on ne peut pas dire qu’une machine puisse égaler un cerveau humain ». La réponse de Turing est que nous les hommes n’avons aucun moyen de connaître véritablement l’expérience des émotions de tout autre individu que soi-même, et donc que nous devrions accepter le test.

- Originalité : une autre objection, très controversée, est que les ordinateurs seraient incapables d’avoir de l’originalité. Turing répond que les ordinateurs peuvent surprendre les humains, en particulier lorsque les conséquences de différents faits ne sont pas immédiatement reconnaissables.

- Formalisme : cet argument dit que chaque système gouverné par des lois peut être prévisible et donc pas réellement intelligent. Turing répond que ceci revient à confondre des lois du comportement avec des règles générales de conduite.

- Perception extra-sensorielle : Turing semble suggérer qu’il y a des preuves de perceptions extra-sensorielles. Cependant il estime que des conditions idéales peuvent être créées, dans lesquelles ces perceptions n’affecteraient pas le test et ainsi seraient négligeables.

La Pièce Chinoise

Dans un article daté de 1980, le philosophe John Searle remet en cause la puissance du test de Turing, en invoquant la limite des ordinateurs à la syntaxe. Selon l'auteur, la sémantique, caractéristique de la pensée humaine, ne saurait être réduite à la manipulation de symboles selon des règles syntaxiques déterminées, ce qui semble être le propre de la machine. Pour illustrer ses propos, il présente l'expérience de pensée de la Pièce Chinoise : supposez que vous êtes à l'intérieur d'une pièce contenant des symboles chinois ainsi qu'un manuel comportant des règles type "questions-réponses". Lorsqu'un Chinois, à l'extérieur, vous envoie un message par symbole, vous pourrez, grâce au manuel, fournir une réponse adéquate et donner l'impression à votre interlocuteur de savoir parler sa langue, sans qu'il soit nécessaire que vous la compreniez.

Les faiblesses du test

Le test de Turing est fondée sur l'hypothèse que les êtres humains peuvent juger de l'intelligence d'une machine en comparant son comportement avec le comportement humain. Chaque élément de cette hypothèse a été remis en question: le jugement de l'humain, la valeur de la comparaison qui est de seulement comparer le comportement et la valeur de la comparaison avec un humain. Pour ces raisons et d'autres considérations, certains chercheurs en intelligence artificielle ont mis en doute l'utilité de l'essai.

Intelligence Humaine contre l'intelligence en général

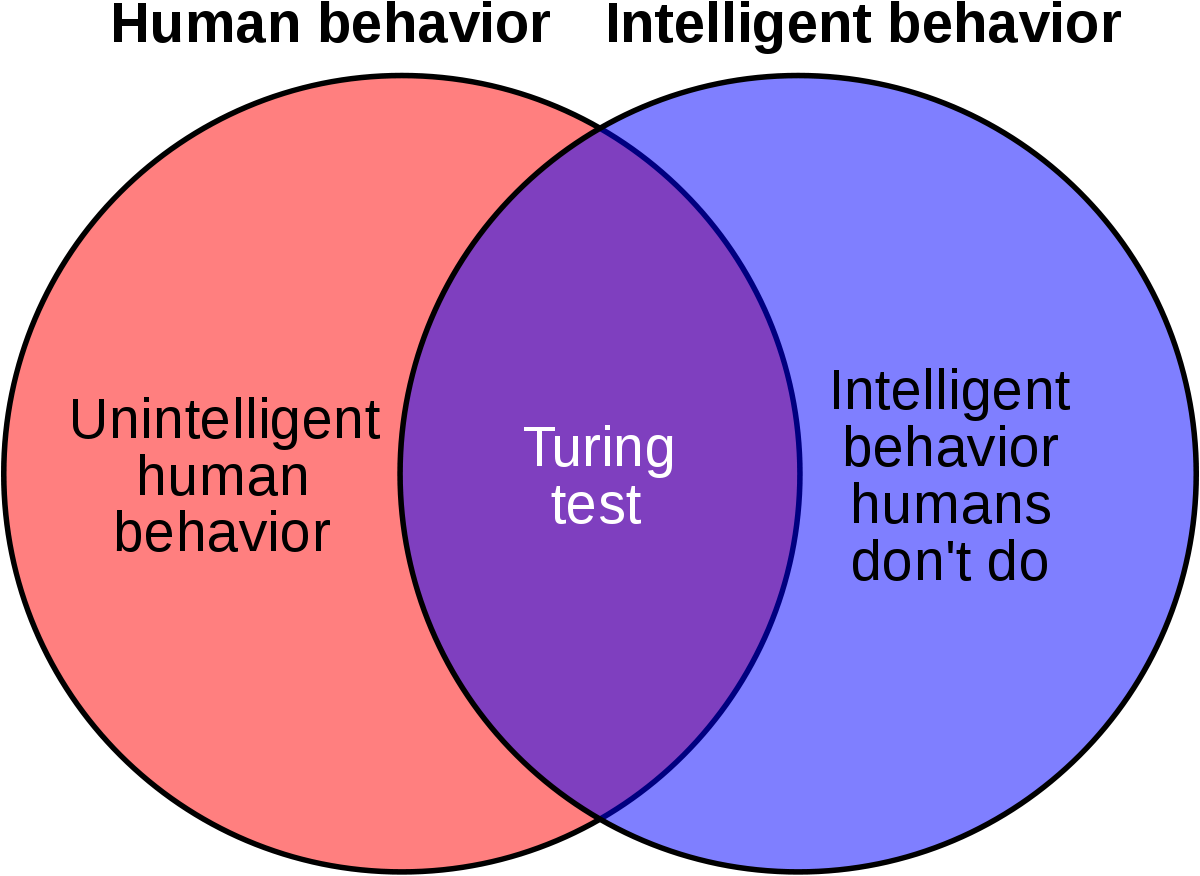

Cela ne teste pas directement si l'ordinateur se comporte de façon intelligente, cela teste seulement si l'ordinateur se comporte comme un être humain. Étant donné que le comportement intelligent et les comportements humains ne sont pas exactement la même chose, le test ne permet pas de mesurer avec précision l'intelligence de deux façons :

- Certains comportements humains sont stupides : Le test de Turing exige que la machine puisse exécuter tous les comportements humains, indépendamment de savoir s'ils sont ou non intelligents. Cela teste même des comportements que l'on ne peut pas considérer comme intelligents du tout, tels que la susceptibilité à des insultes, la tentation de mentir ou, tout simplement, une fréquence élevée d'erreurs de frappe. Si une machine ne peut imiter le comportement humain dans le détail, comme faire des erreurs de frappe, l'intelligence échoue au test, indépendamment de la façon dont elle peut être intelligente.

- Cette objection a été soulevée par The Economist , dans un article intitulé « Artificial Stupidity », publié peu après la première compétition Loebner en 1992. L'article notait que la victoire du gagnant de la première compétition Loebner était due, au moins en partie, à sa capacité à « imiter les erreurs de frappe de l'homme ». Turing lui-même a suggéré que les programmes devraient ajouter des erreurs dans leur sortie, de manière à être de meilleurs « joueurs » dans la partie.

- Certains comportements intelligents ne sont pas humains : Le test de Turing ne vérifie pas la présence, ou l'absence, d'un comportement intelligent, tel que la capacité de résoudre des problèmes difficiles ou de trouver des idées originales. En fait, elle exige expressément la tromperie de la part de la machine : si la machine est plus intelligente qu'un être humain, il lui faut délibérément éviter de paraître trop intelligente. Si elle était capable de résoudre un problème de calcul qui serait impossible pour un humain, alors l'interrogateur saurait que le programme n'est pas humain, et la machine ne satisferait pas au test.

Réelle intelligence vs intelligence simulée

Cela ne teste que la façon dont le sujet agit — le comportement extérieur de la machine. À cet égard, cela assume une vision comportementaliste ou fonctionnaliste de l'intelligence. L'exemple de ELIZA a suggéré qu'une machine passant le test peut être en mesure de simuler le comportement conversationnel de l'homme par la suite d'une simple (mais vaste) liste de règles mécaniques, sans penser, par automatisme.

John Searle avait fait valoir que le comportement externe ne peut pas être utilisé pour déterminer si une machine pense « réellement » ou est simplement en train de « simuler l'action de penser ».

Turing anticipa ces critiques dans son article original, écrit que : « Je ne veux pas donner l'impression que je pense qu'il n'y a aucun mystère quant à la conscience. Il y a, par exemple, en quelque sorte un paradoxe lié à toute tentative visant à la localiser. Mais je ne pense pas que ces mystères aient nécessairement besoin d'être résolus avant que nous puissions répondre à la question qui nous préoccupe dans cet article. »

Naïveté des interrogateurs et le sophisme anthropomorphique

Le test de Turing suppose que l'interrogateur soit assez sophistiqué pour déterminer la différence entre le comportement d'une machine et le comportement d'un être humain, bien que les critiques soutiennent que ce n'est pas une compétence que la plupart des gens ont. Les compétences précises et les connaissances requises par l'interrogateur ne sont pas précisées par Turing dans sa description de l'essai, mais il n'a pas utilisé le terme d'« interrogateur moyen » : « L'interrogateur moyen n'aurait pas plus de 70 pour cent de chances de faire l'identification exacte après cinq minutes d'interrogation ». Shah & Warwick (2009C) montrent que les experts sont dupes et que la stratégie interrogateur, « pouvoir » contre « solidarité » affecte une identification correcte, ce dernier étant plus efficace.

Les agent conversationnels tels que ELIZA ont à maintes reprises dupé des naïfs en leur faisant croire qu'ils sont en communication avec des êtres humains. Dans ces cas-là, l'« interrogateur » n'est même pas conscient de la possibilité qu'il soit en interaction avec un ordinateur. Pour réussir a prendre apparence humaine, il n'est pas nécessaire pour la machine d'avoir tous les renseignements et que seule une ressemblance superficielle du comportement humain est nécessaire. La plupart des gens conviennent qu'un « vrai » test de Turing n'a pas été adopté dans des cas « mal informés » tels que celui-ci.

Lors des premières versions du prix Loebner, des interrogateurs « non-sophistiqué » furent utilisés, et ils ont été facilement bernés par les machines. Depuis 2004, les organisateurs du Prix Loebner ont déployé des philosophes, des informaticiens et des journalistes parmi les interrogateurs. Certains d'entre eux ont été trompés par des machines, voir Shah & Warwick (2009a) : Test de Turing cinq minutes, en parallèle jumelé en jeu de l'imitation (à paraître) Kybernetes Turing Test Special Issue.

Michael Shermer souligne que les êtres humains choisissent systématiquement de considérer les objets non-humain par anthropomorphisme, une erreur appelée également sophisme anthropomorphique : ils parlent à leur voiture, attribuent la volonté et des intentions aux forces naturelles (par exemple, « la nature a horreur du vide »), et adorent le soleil comme étant un être humain ou comme un être doué d'intelligence. Si le test de Turing est appliqué à des objets religieux, Shermer fait valoir, alors que des statues inanimées, des roches et des lieux ont toujours réussi le test tout au long de l'histoire. Cette tendance humaine à l'anthropomorphisme abaisse la barre pour le test de Turing, à moins que les interrogateurs soient spécifiquement formés pour l'éviter.

Irréalisme et inutilité : le test de Turing et la recherche en IA

Les chercheurs en intelligence artificielle font valoir que tenter de faire passer le test de Turing est simplement une distraction au lieu de se consacrer dans des recherches fructueuses. En effet, le test de Turing n'est pas un foyer actif de beaucoup d'efforts académiques ou commerciaux, comme Stuart Russell et Peter Norvig écrivent : « Les chercheurs en AI ont consacré peu d'attention à passer le test de Turing ». Il y a plusieurs raisons :

Premièrement, il existe des façons plus faciles de tester leurs programmes. La plupart des recherches actuelles dans les domaines liés à l'AI visent des objectifs modestes mais précis, tels que l'ordonnancement automatisé, la reconnaissance d'objets ou la logistique. Afin de tester l'intelligence des programmes qui résolvent des problèmes, les chercheurs en intelligence artificielle leur donnent la tâche à exécuter directement, plutôt que de passer par le détour qui est de poser la question dans un chat peuplés avec des ordinateurs et des personnes.

Deuxièmement, la création de la vie comme les simulations d'êtres humains est un problème difficile en soi qui n'a pas besoin d'être résolu pour atteindre les objectifs fondamentaux de la recherche en AI. Des personnages humains artificiels crédibles peuvent être intéressants dans une œuvre d'art, un jeu vidéo ou une interface utilisateur sophistiquée, mais cela ne fait pas partie de la science de la création de machines intelligentes, qui est la science des machines qui résolvent des problèmes liés à l'intelligence. Russell et Norvig suggèrent une analogie avec l'histoire de l'aviation : les avions sont testés en fonction de leur vol, non pas en les comparant à des oiseaux. Les essais sur l'aéronautique, développent-ils, ne définissent pas le but de leur domaine comme une course à l'invention de machines volant si similairement à un pigeon que leurs individus s'y tromperaient. "

Turing n'avait pas dans l'intention que son test soit utilisé comme une pratique compétente à la « mesure » de l'intelligence des programmes artificiels, il voulait donner un exemple clair et compréhensible pour contribuer à la discussion sur la philosophie de l'intelligence artificielle. En tant que tel, il n'est pas surprenant que le test de Turing ait eu si peu d'influence sur les recherches en Intelligence Artificielle. La philosophie de l'I.A., en écrivit John McCarthy, « a peu de chances d'avoir plus d'effet sur la pratique de la recherche en I.A. que la philosophie de la science en a généralement sur la pratique de la science ».