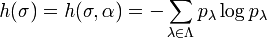

Entropie métrique - Définition

La liste des auteurs de cet article est disponible ici.

Exemples de systèmes dynamiques et calcul d'entropie

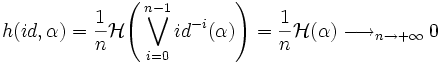

Le calcul de l'entropie métrique est facilité lorsque la borne supérieure est atteinte, i.e lorsqu'il existe une partition α telle que l'entropie métrique et l'entropie relativement à α soient confondues. À titre d'exemple, traitons le cas de l'application identité de X. Alors,

L'identité a une entropie nulle, ce qui est prévisible en raison de son caractère peu chaotique.

Dans beaucoup de cas moins triviaux, le théorème suivant, de Kolmogorov-Sinai, est l'un des outils les plus pratiques pour calculer une entropie, car il évite de prendre la borne supérieure sur toutes les partitions mesurables de X.

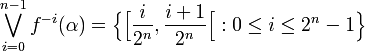

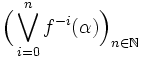

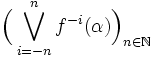

Si α est une partition mesurable de X telle que la suite

Le théorème de Kolmogorov-Sinai affirme que si α est génératrice, alors h(f) = h(f,α).

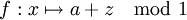

Rotations du cercle

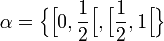

lorsque a = p / q est rationnel. Soit α une partition :

Dans le cas où a est irrationnel, on montre également que l'entropie métrique de f est nulle.

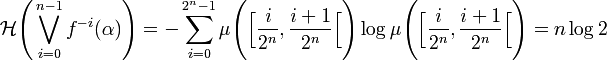

Doublement des angles

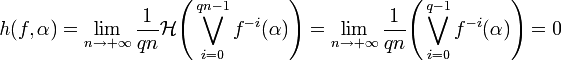

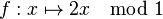

Toujours sur le cercle unité, on prend cette fois l'application

qui double les angles. On considère la même partition

On observe que :

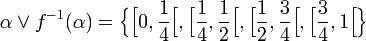

Puis par récurrence, on déduit plus généralement que :

Comme les ensembles du type

L'entropie métrique de f est donc log 2.

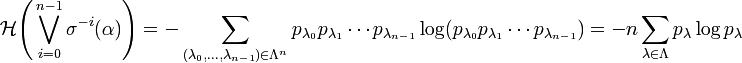

Décalage de Bernoulli

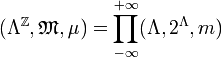

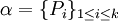

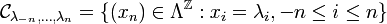

On dispose d'un alphabet fini

Donc