Cumulants (statistiques) - Définition

La liste des auteurs de cet article est disponible ici.

Introduction

Dans la théorie des probabilités et en statistiques, une variable aléatoire X a une espérance mathématique μ = E(X) et une variance σ2 = E((X − μ)2). Ce sont les deux premiers cumulants : μ = κ1 et σ2 = κ2.

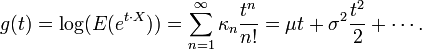

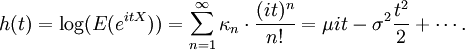

Les cumulants κn sont définis par la fonction génératrice des cumulants qui est g(t) :

Elle est donc intimement liée à la fonction génératrice des moments et à la fonction caractéristique de la variable X. Les cumulants sont donnés par les dérivées en 0 de g(t) :

- κ1 = μ = g' (0),

- κ2 = σ2 = g' '(0),

- κn = g(n) (0).

Une distribution avec des cumulants κn donnés peut être approchée par un développement d'Edgeworth.

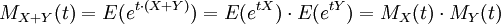

Comme indiqué plus haut, les cumulants d'une distribution sont liés aux moments de la distribution. Travailler avec la fonction génératrice des cumulants est plus pratique dans la mesure où pour des variables indépendantes X et Y,

tandis qu'avec la fonction génératrice des moments MX, on obtient

-

Il faut enfin remarquer que :

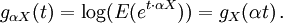

Certains auteurs préfèrent définir la fonction génératrice des cumulants directement à partir de la fonction caractéristique d'une variable aléatoire

La caractérisation des cumulants est valide même pour les distributions dont les plus hauts moments n'existent pas.

Cumulants de quelques distributions discrètes

- La variable aléatoire constante X = 1. La dérivée de la fonction génératrice des cumulants est g'(t) = 1. Le premier cumulant est donc κ1 = g '(0) = 1 et tous les autres cumulants sont nuls, κ2 = κ3 = κ4 = ... = 0.

- La variable aléatoire Y = μ se déduit de la variable aléatoire précédente. La fonction génératrice des cumulants est donc gY(t) = gX(μt) = μt. Bref, chaque cumulant est juste μ fois les cumulants précédents. On a donc κ1 = g '(0) = μ et les autres cumulants sont nuls, κ2 = κ3 = κ4 = ... = 0.

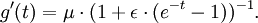

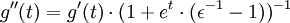

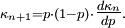

- La loi de Bernoulli (nombre de succès dans une épreuve avec une probabilité de succès p). Le cas spécial p = 1 revient à la variable aléatoire X = 1. La fonction génératrice est g(t) = ln(pet + (1 − p)). Sa dérivée est g '(t) = ((p−1−1)·e−t + 1)−1. Finalement, les cumulants sont κ1 = g '(0) = p et κ2 = g ' '(0) = p·(1−p) . Les cumulants vérifient la formule de récurrence

- La loi géométrique (nombre de défaillances avant un succès, avec une probabilité de succès p à chaque expérience). La dérivée de la fonction génératrice des cumulants est g '(t) = ((1−p)−1·e−t−1)−1. Les premiers cumulants sont κ1 = g '(0) = p−1−1, et κ2 = g ' '(0) = κ1·p−1. En posant p = (μ+1)−1, on obtient g '(t) = ((μ−1+1)·e−t−1)−1 et κ1 = μ.

- La loi de Poisson. La dérivée de la fonction génératrice des cumulants est g '(t) = μ·et. Tous les cumulants sont égaux au paramètre: κ1 = κ2 = κ3 = ...=μ.

- La loi binomiale (n répétitions indépendantes de l'expérience de Bernouilli décrite plus haut). Chaque cumulant est juste n fois le cumulant associé de la loi de Bernouilli. La dérivée de la fonction génératrice des cumulants est g '(t) = n·((p−1−1)·e−t + 1)−1. Les premiers cumulants sont κ1 = g '(0) = n·p et κ2 = g ' '(0) = κ1·(1−p). En posant p = μ·n−1 cela donne g '(t) = ((μ−1−n−1)·e−t+n−1)−1 et κ1 = μ. Le cas limite n−1 = 0 est une loi de Poisson.

- La loi binomiale négative (nombre d'échecs avant n succès avec une probabilité de succès p à chaque expérience). Le cas spécial n = 1 est la loi géométrique. La dérivée de la fonction génératrice des cumulants est g '(t) = n·((1−p)−1·e−t−1)−1. The first cumulants are κ1 = g '(0) = n·(p−1−1), et κ2 = g ' '(0) = κ1·p−1. En posant p = (μ·n−1+1)−1, cela donne g '(t) = ((μ−1+n−1)·e−t−n−1)−1 et κ1 = μ. Comparer ces formules à celles de la loi binomial permet de justifier le nom de 'loi binomiale négative'. Le cas limite n−1 = 0 est encore la loi Poisson.

En introduisant

La dérivée seconde est

confirmant que le premier cumulant est κ1 = g '(0) = μ et que le second cumulant est κ2 = g ' '(0) = μ·ε. Les variables aléatoires constantes X = μ sont telles que є = 0. Les lois binomiales vérifient є = 1 − p si bien que 0<є<1. Les lois de Poisson vérifient є = 1 tandis que les lois binomiales négatives se caractérisent par є = p−1 si bien que є > 1. Il faut noter l'analogie avec l'excentricité des coniques: cercles є = 0, ellipses 0 < є < 1, paraboles є = 1, hyperboles є > 1.