Algorithme espérance-maximisation - Définition

La liste des auteurs de cet article est disponible ici.

Introduction

L'algorithme espérance-maximisation (en anglais Expectation-maximisation algorithm, souvent abrégé EM), proposé par Dempster et al. (1977), est une classe d'algorithmes qui permettent de trouver le maximum de vraisemblance des paramètres de modèles probabilistes lorsque le modèle dépend de variables latentes non observables.

Usage

On utilise souvent l'algorithme d'Espérance-maximisation pour la classification de données, l'apprentissage automatique, ou la vision artificielle. On peut également citer son utilisation en imagerie médicale dans le cadre de la reconstruction tomographique.

L'algorithme d'espérance-maximisation comporte :

- une étape d'évaluation de l'espérance (E), où l'on calcule l'espérance de la vraisemblance en tenant compte des dernières variables observées,

- une étape de maximisation (M), où l'on estime le maximum de vraisemblance des paramètres en maximisant la vraisemblance trouvée à l'étape E.

On utilise ensuite les paramètres trouvés en M comme point de départ d'une nouvelle phase d'évaluation de l'espérance, et l'on itère ainsi.

Pour résoudre le problème d'apprentissage des modèles de Markov cachés (HMM), c’est-à-dire la détermination des paramètres du modèle markovien, on utilise l'algorithme de Baum-Welch.

Exemple détaillé : application en classification automatique

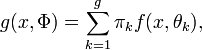

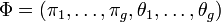

Une des applications phares d'EM est l'estimation des paramètres d'une densité mélange en classification automatique dans le cadre des modèles de mélanges gaussiens. Dans ce problème, on considère qu'un échantillon

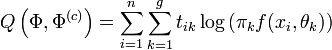

et donc, la log-vraisemblance du paramètre Φ est donnée par

La maximisation de cette fonction selon Φ est très complexe. Par exemple, si on souhaite déterminer les paramètres correspondant à 2 groupes suivant une loi normale dans un espace de dimension 3 (ce qui est peu), on doit optimiser une fonction non linéaire de

Parallèlement, si on connaissait les groupes auxquels appartient chacun des individus, alors le problème serait un problème d'estimation tout à fait simple et très classique.

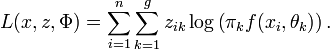

La force de l'algorithme EM est justement de s'appuyer sur ces données pour réaliser l'estimation. En notant zik la grandeur qui vaut 1 si l'individu xi appartient au groupe Gk et 0 sinon, la log-vraisemblance des données complétée s'écrit

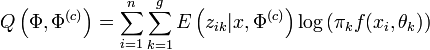

On obtient alors rapidement

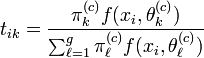

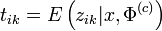

En notant tik la quantité donnée par

- Etape E : calcul de tik par la règle d'inversion de Bayes :

- Etape M : détermination de Φ maximisant

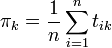

L'avantage de cette méthode est qu'on peut séparer le problème en g problèmes élémentaires qui sont, en général relativement simples. Dans tous les cas, les proportions optimales sont données par

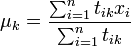

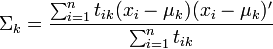

L'estimation des θ dépend par ailleurs de la fonction de probabilité f choisie. Dans le cas normal, il s'agit des moyennes μk et des matrices de variance-covariance Σk. Les estimateurs optimaux sont alors donnés par

Avec M' la matrice transposée de M et en supposant que les μk sont des vecteurs colonnes.