Indépendance (probabilités) - Définition

La liste des auteurs de cet article est disponible ici.

Introduction

L'indépendance est une notion probabiliste qualifiant de manière intuitive des événements aléatoires n'ayant aucune influence l'un sur l'autre. Il s'agit d'une notion très importante en statistique et calcul de probabilités.

Par exemple, la valeur d'un premier lancer de dés n'a aucune influence sur la valeur du second lancer. De même, pour un lancer, le fait d'obtenir une valeur inférieure ou égale à quatre n'influe en rien sur la probabilité que le résultat soit pair ou impair : les deux événements sont dits indépendants.

L'indépendance ou non de deux événements n'est pas toujours facile à établir.

Indépendance de deux évènements

La définition mathématique de l'indépendance de deux évènements est la suivante :

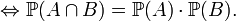

Définition — A et B sont indépendants

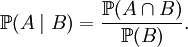

La définition mathématique ci-dessus est assez peu parlante. Le lien entre le concept intuitif d'indépendance et la "formule produit" ci-dessus apparaît plus clairement si l'on introduit la notion de probabilité conditionnelle :

Définition — Si

En excluant les cas particuliers peu intéressants où B est impossible, et où B est certain, on peut alors reformuler la définition de l'indépendance de la manière suivante

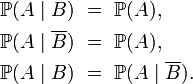

Définition — Lorsque la probabilité de B n'est ni nulle, ni égale à 1, A et B sont indépendants si l'une des conditions suivantes, toutes équivalentes, est remplie :

Ainsi les évènements A et B sont dits indépendants si notre pronostic sur l'évènement A est le même :

- si on sait que l'évènement B s'est produit (pronostic

- si on sait que l'évènement B ne s'est pas produit (pronostic

- si on ne sait rien sur le statut de l'évènement B (pronostic

Autrement dit, A est dit indépendant de B si notre pronostic sur l'évènement A n'est affecté par aucune information concernant B, ni par l'absence d'information concernant B. On peut échanger les rôles de A et de B dans la définition utilisant les probabilités conditionnelles, à condition bien sûr d'exclure les cas particuliers peu intéressants où A est impossible, et où A est certain.

Bien que la définition utilisant les probabilités conditionnelles soit plus intuitive, elle a l'inconvénient d'être moins générale, et de ne pas faire jouer un rôle symétrique aux deux événements A et B.

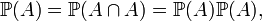

Notons par ailleurs qu'un évènement certain A est indépendant de tout évènement B quel qu'il soit. Un évènement impossible est également indépendant de tout autre évènement. En particulier, un événement A est indépendant de lui-même à la condition que A soit soit certain, soit impossible. En effet, si l'événement A est indépendant de lui-même, on peut écrire :

et on en déduit que la probabilité de l'événement A vaut soit 0, soit 1.

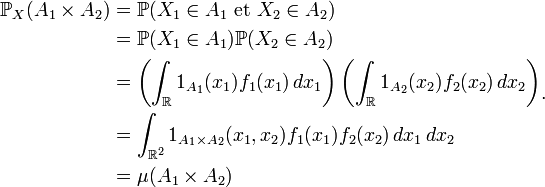

Indépendance des variables aléatoires

Définitions

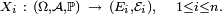

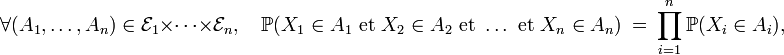

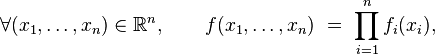

Il y a plusieurs définitions équivalentes de l'indépendance d'une famille finie de variables aléatoires. On peut en particulier définir l'indépendance d'une famille de tribus, et voir ensuite l'indépendance des évènements et l'indépendance des variables aléatoires comme des cas particuliers de l'indépendance des tribus. Cela permet de démontrer certains résultats généraux sur l'indépendance une seule fois, pour les tribus, puis d'en déduire la version "évènements" et la version "variables aléatoires" de ce résultat général immédiatement (un exemple est le lemme de regroupement). Cependant, il est peut-être préférable de donner d'abord deux définitions de l'indépendance des variables aléatoires qui soient opératoires pour les applications, et quelques critères commodes. Dans ce qui suit on considère une suite

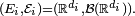

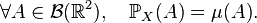

Définition —

-

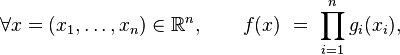

- on a l'égalité

- pour n'importe quelle suite de fonctions

Les espérances ci-dessus ont un sens si les

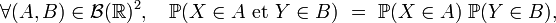

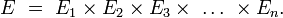

Définition — Deux variables aléatoires réelles X et Y sont indépendantes si l'une des deux conditions suivantes est remplie :

-

- on a

- pour tout couple de fonctions boréliennes

Les définitions précédentes traitent de familles finies de variables aléatoires, numérotées de 1 à n par commodité, sans que cela restreigne la généralité des énoncés : en effet, on peut toujours numéroter de 1 à n les éléments d'une famille finie de variables aléatoires. De plus, les définitions font jouer des rôles symétriques à chaque élément de la famille, si bien que le choix d'une numérotation ou d'une autre est sans effet sur la vérification de la définition.

L'indépendance d'une famille quelconque (éventuellement infinie) de variables aléatoires est la suivante :

Définition — Une famille quelconque

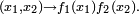

Cas des variables aléatoires à densité

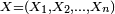

Soit une suite

Théorème —

- Si

- où les fonctions

- est une densité de probabilité de la variable aléatoire

- Réciproquement, si

-

- est une densité de probabilité de

Sens direct.

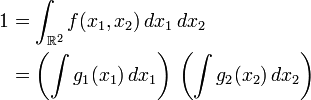

Comme la densité

et par suite

Par construction les fonctions

Ainsi les fonctions

![\begin{align} \operatorname{E}[\varphi(X_1)\psi(X_2)] &= \int \int \varphi(x_1)\psi(x_2)f(x_1,x_2) \, dx_1 \, dx_2\\ &= \int \int \varphi(x_1)f_1(x_1)\psi(x_2)f_2(x_2) \, dx_1 \, dx_2\\ &= \int \varphi(x_1)f_1(x_1) \, dx_1 \int \psi(x_2)f_{2}(x_2) \, dx_2\\ &= \operatorname{E}[\varphi(X_1)] \operatorname{E}[\psi(X_2)]\end{align}](https://static.techno-science.net/illustration/Definitions/autres/a/a8b338883e671d5d74de0cef24cab297_8aa1db279886ec49e28887a2993fcd80.png)

ce qui entraine l'indépendance des variables

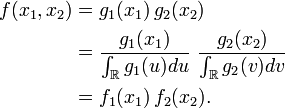

Sens réciproque. Il suffit de montrer que

où

où

En effet

On remarque alors que

Cas des variables discrètes

Dans le cas des variables discrètes, un critère d'indépendance utile est le suivant :

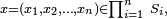

Cas discret — Soit X=(X1, X2, ... , Xn ) une suite de variables aléatoires discrètes, et soit (S1, S2, ... , Sn ) une suite d'ensembles finis ou dénombrables tels que, pour tout i≤n,

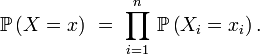

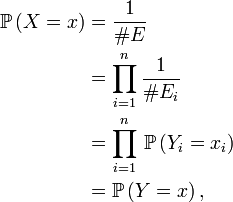

- Soit (E1, E2, ... , En) une suite d'ensembles finis, de cardinaux respectifs #Ei , et soit X=(X1, X2, ... , Xn ) une variable aléatoire uniforme à valeurs dans le produit cartésien :

- Alors la suite X est une suite de variables aléatoires indépendantes, et, pour chaque i, la variable aléatoire Xi suit la loi uniforme sur Ei . En effet, considérons une suite Y=(Yi )1≤i≤n de variables aléatoires indépendantes, chaque Yi étant uniforme sur l'ensemble Ei correspondant. Alors, pour tout élément x=(x1, x2, ... , xn ) de E,

- la deuxième égalité résultant de la formule donnant le nombre d'éléments d'un produit cartésien d'ensembles, la 4ème de l'indépendance des Yi , les autres égalités résultant de la définition de la loi uniforme. Ainsi les suites X et Y ont même loi, ce qui entraîne bien que X est une suite de variables aléatoires indépendantes dont les composantes suivent des lois uniformes.

- Une application de ce critère est l'indépendance des composantes du code de Lehmer d'une permutation, qui permet d'obtenir simplement la fonction génératrice des nombres de Stirling de première espèce.

- Un autre application est l'indépendance des chiffres du développement décimal d'un nombre uniforme dans l'intervalle [0,1].

Autres critères d'indépendance

Par exemple,

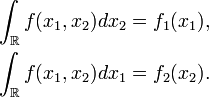

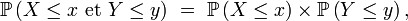

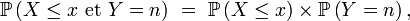

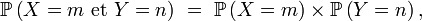

Critères — Soit X et Y deux variables aléatoires réelles définies sur un espace probabilisé

- Si, pour tout couple (x,y) de nombres réels,

- alors X et Y sont indépendantes.

- Si Y est à valeurs dans

- alors X et Y sont indépendantes.

- Bien sûr, si X et Y sont à valeurs dans

- alors X et Y sont indépendantes.

Par exemple, on peut utiliser le deuxième critère pour démontrer que dans la méthode de rejet, le nombre d'itérations est indépendant de l'objet aléatoire (souvent un nombre aléatoire) engendré au terme de ces itérations.

On peut généraliser ces critères d'indépendance à des familles finies quelconques de variables aléatoires réelles, dont certaines, éventuellement, sont des variables discrètes, à valeurs dans des parties finies ou dénombrables de

Indépendance et corrélation

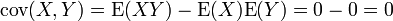

L'indépendance implique que la covariance, et donc la corrélation, entre les deux variables est nulle:

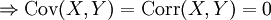

Théorème — X et Y sont indépendantes

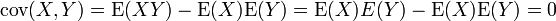

Cette propriété se déduit très facilement si l'on exprime la covariance comme:

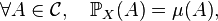

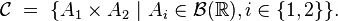

La réciproque du théorème est fausse, comme le montre l'exemple suivant:

Cet exemple est tiré de Ross (2004, p. 306)

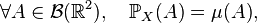

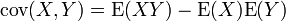

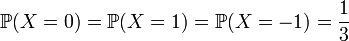

- Soit X une variable aléatoire discrète telle que

- Définissons Y en relation avec X :

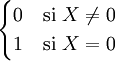

- On calcule

![\operatorname{E}[XY]= \frac{1}{3}(0\cdot 1)+\frac{1}{3}(1\cdot 0)+\frac{1}{3}(-1\cdot 0)=0](https://static.techno-science.net/illustration/Definitions/autres/d/dfc196782450e0bc07740f1aecf0e937_87f71d22b8596356789ed5f1c39697a6.png)

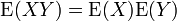

- On voit aussi que

![\operatorname{E}[X]= \frac{1}{3}(0)+\frac{1}{3}(1)+\frac{1}{3}(-1)=0+1-1=0](https://static.techno-science.net/illustration/Definitions/autres/5/5277d6ef3dccbbd60320d9236b44e249_0d732c439135c9c6355e6dfcf4867d4b.png)

- donc:

- Pourtant les deux variables ne sont bien évidemment pas indépendantes!

La non-corrélation entre X et Y est une propriété plus faible que l'indépendance. En fait l'indépendance entre X et Y est équivalente à la non-corrélation de φ(X) et de ψ(Y) pour tout choix de φ et de ψ (tels que la covariance de φ(X) avec ψ(Y) soit définie ...).

![\mathbb{E}\left[\prod_{i=1}^n\ \varphi_i(X_i)\right]\ =\ \prod_{i=1}^n\mathbb{E}\left[\varphi_i(X_i)\right],](https://static.techno-science.net/illustration/Definitions/autres/5/569363073b172b7350de06f174c09ef6_c9f501339df8e9c7692881534468c6cf.png)

![\mathbb{E}\left[g(X)\cdot h(Y)\right] = \mathbb{E}[g(X)]\cdot \mathbb{E}[h(Y)]](https://static.techno-science.net/illustration/Definitions/autres/9/941681eaf5e0afb9a6bd52e6da31c751_2b08a861c73810286e0aa5e64f96f05d.png)