Loi multinomiale - Définition

La liste des auteurs de cet article est disponible ici.

Introduction

| Multinomiale | |

|---|---|

| Paramètres | n > 0 nombre d'épreuves (entier) |

| Support |

|

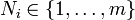

| Densité de probabilité (fonction de masse) |

|

| Espérance | E{Xi} = npi |

| Variance | Var(Xi) = npi(1 − pi) Cov(Xi,Xj) = − npipj ( |

| Fonction génératrice des moments |

|

| modifier | |

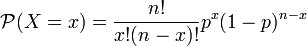

La loi binomiale concerne le nombre de succès dans n épreuves de Bernoulli indépendantes donnant chacune un résultat binaire, comme dans le jeu de pile ou face. La loi multinomiale est une généralisation de celle-ci, applicable par exemple à n jets d'un dé à six faces. Contrairement à ces exemples simples, les différentes possibilités ne sont généralement pas équiprobables.

Autre présentation de la loi binomiale

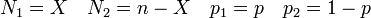

La fonction de probabilité de la variable aléatoire binomiale

peut se réécrire de manière symétrique en faisant intervenir deux variables dont la somme est égale à n :

Approximation

Lorsque la variable aléatoire

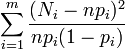

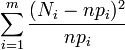

Si ces variables étaient indépendantes,

Du fait de la contrainte linéaire qui s'applique, la variable

Cette dernière remarque est à la base du test du χ².

Généralisation

Dans le cas multinomial à

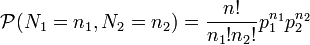

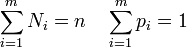

La fonction de probabilité s'écrit alors, sous la condition portant sur la somme des variables :

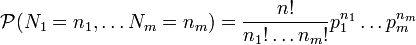

Chacune des variables reste une variable binomiale dont la moyenne et la variance sont

![E[N_i] = n p_i \quad var[N_i] = n p_i (1-p_i)](https://static.techno-science.net/illustration/Definitions/autres/9/988203af7057dd3e417efda8c94658c5_c79fc71b4972cac8960bafa9d220e51b.png)

tandis que les covariances s'écrivent

![cov[N_i,N_j] = -n p_i p_j\,](https://static.techno-science.net/illustration/Definitions/autres/3/3e7c4a94f943641353a54e2d661e28d8_5f32605d142876b6b53cdb01ce1dd170.png)