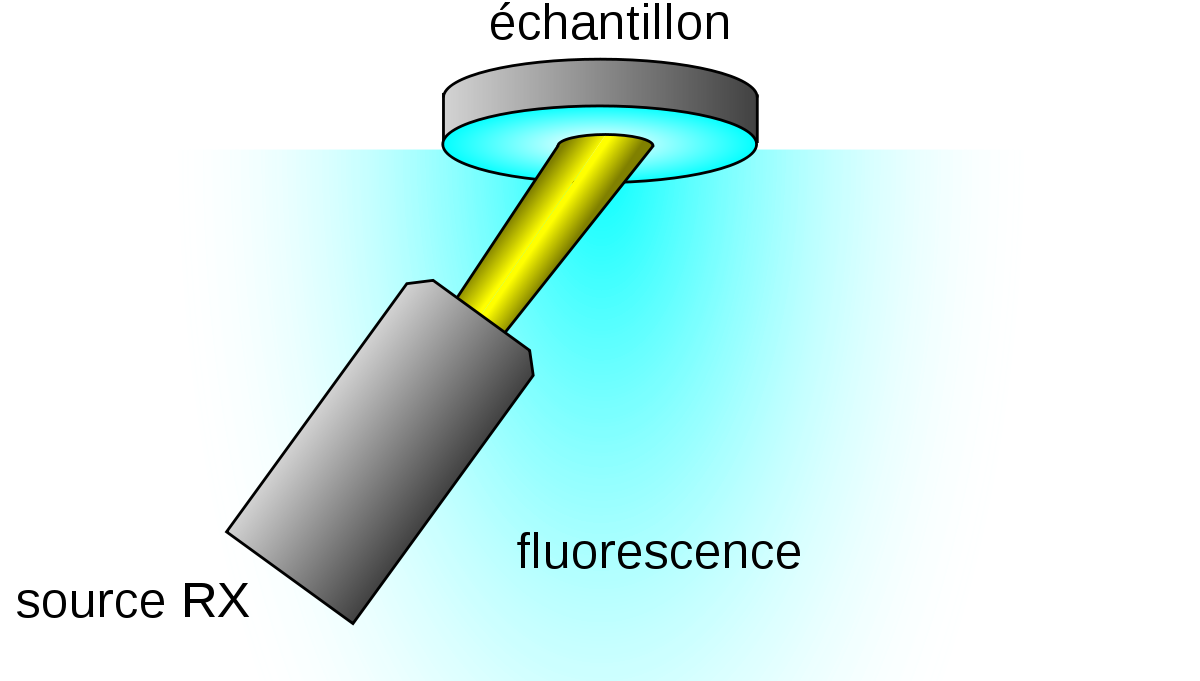

Spectrométrie de fluorescence X - Définition

La liste des auteurs de cet article est disponible ici.

Pratique de l'analyse XRF

Si la physique de base de la spectrométrie par fluorescence X est commune à toutes les branche de la famille, les problèmes pratiques d'analyse sont spécifiques à chaque branche. Ainsi, la préparation d'échantillons provenant de matériaux liquides n'a pas de sens en microanalyse EPMA qui est par définition une analyse locale. Seule la pratique de l'analyse XRF est traitée dans cet article alors que celle de l'EPMA est traitée dans microsonde de Castaing.

Préparation des échantillons

Selon la nature du matériau, l'échantillon mesuré peut être le matériau brut, sans préparation. C'est le cas d'un échantillon solide ayant une tenue mécanique suffisante et les bonnes dimensions, par exemple métal, verre ou polymère découpé aux bonnes dimensions.

Dans d'autres cas, l'échantillon doit faire l'objet d'une préparation:

Dans le cas de la poudre, une fois le matériau broyé, il peut être mis dans une coupe dont le fond est un film polymère, l'analyse se faisant sous hélium pour éviter que la poudre ne vole sous l'effet du pompage. Lorsque l'on dispose de peu de poudre, cette dernière peut également être pressée sur une pastille d'acide borique qui assure sa tenue mécanique. Elle peut également être pressée sous la forme d'une pastille, avec ou sans liant. Les principaux liants utilisés sont la cire et la cellulose microcristalline. Certains utilisent des cachet d'aspirine non pelliculés achetés en pharmacie; c'est en effet de la cellulose qui est généralement utilisée pour lier les cachets, et l'acide acétylsalicylique sert de lubrifiant. Il faut toutefois s'assurer que le cachet ne contienne pas de composé pouvant perturber la mesure, comme du dioxyde de titane, du stéarate de magnésium ou du talc (silicate de magnésium).

Le matériau préalablement réduit en poudre peut aussi être dissout dans un verre: c'est la technique de la perle fondue, la plus complexe, mais qui donne les meilleurs résultats pour des solides hétérogènes.

Quant aux liquides, eau, huile, carburant… on les met dans une coupe dont le fond est un film polymère si la mesure se fait par en dessous. On parle d'optique « inversée ». L'analyse se fait sous hélium pour éviter l'ébullition sous l'effet de la chaleur et du vide.

Dans le cas d'une optique inversée, le tube et l'analyseur se trouvent sous l'échantillon. Si le film rompt durant l'analyse du liquide, cela peut endommager ces parties ; il convient donc d'adopter un film suffisamment résistant, il faut faire un compromis avec l'absorption des rayons X (puisque plus un film est épais et plus il est résistant) et la présence d'éléments perturbateurs dans le film (qui permettent au film de mieux résister à certains produits). Ce problème ne se pose pas dans le cas des optiques directes (mesure par le dessus), mais le problème est alors de mettre un volume défini de liquide afin que la surface soit au niveau de référence.

Le logiciel de traitement des résultats doit prendre en compte la préparation de l'échantillon, à la fois dans l'estimation des effets de matrice, mais aussi pour afficher les concentrations dans l'échantillon initial. L'étalonnage de l'instrument (voir ci-dessous) sera spécifique pour chaque type de préparation.

Élaboration de la recette d'analyse

Un opérateur qui veut analyser un échantillon par XRF doit d'abord exprimer son problème, par exemple, mesurer la concentration du chrome dans son échantillon, et ensuite déterminer quelles sont les raies qu'il peut mesurer pour résoudre son problème, et enfin quels sont les paramètres instrumentaux qui donneront les meilleurs résultats.

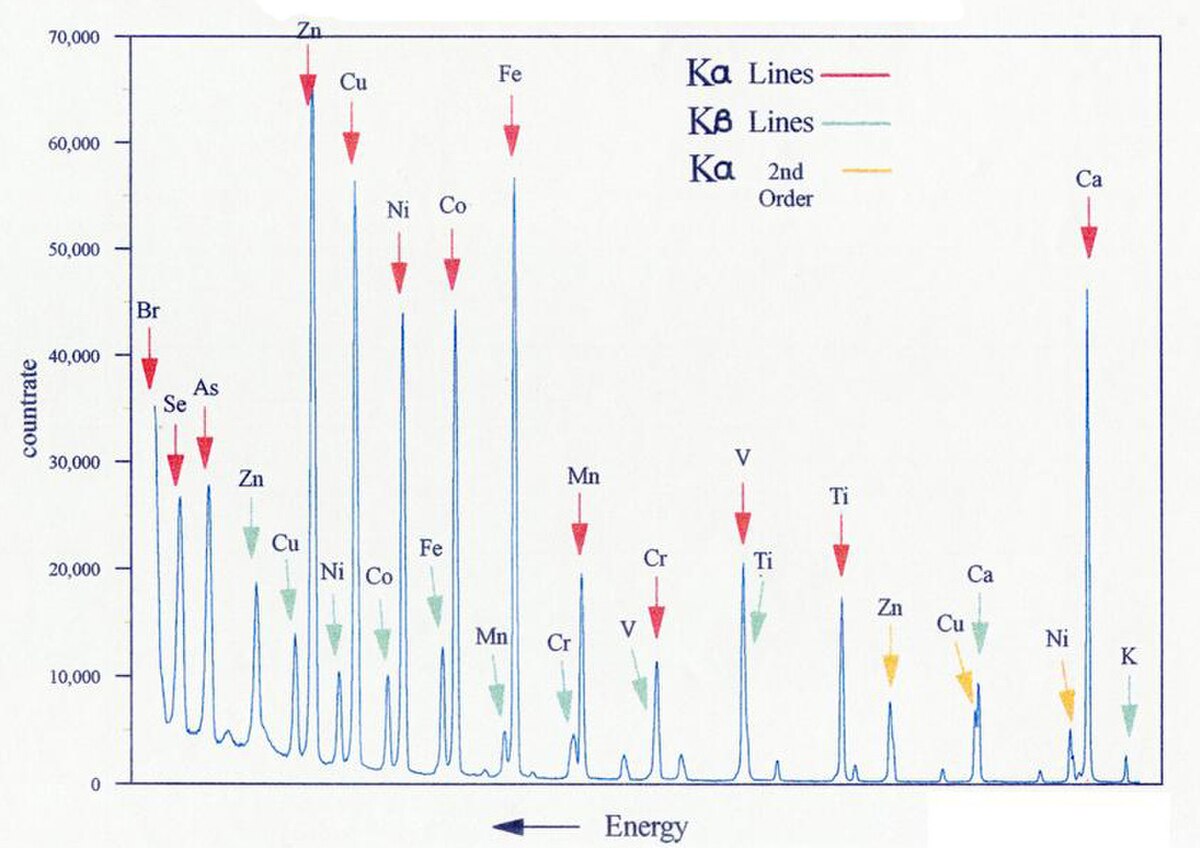

Choix des raies mesurées

Pour la plupart des éléments, l'opérateur a le choix entre plusieurs raies possibles. Les raies mesurables sont en général les raies

- Kα et Kβ pour les éléments légers, jusqu'au potassium (Z = 19) ;

- Kα, Kβ, Lα et Lβ pour les éléments moyens et lourds, du calcium (Z = 20) au lanthane (Z = 57) ;

- les raies K ne sont plus mesurables pour les lanthanides et à partir du tungstène (Z = 74);

- la raie Mα est mesurable de l'hafnium (Z = 72) au bismuth (Z = 83).

L'opérateur a a sa disposition des tables qui le renseignent (Voir, sur wikibooks b:Spectrométrie de fluorescence X#Raies caractéristiques des éléments dans le domaine des rayons X). Ces informations sont disponibles en ligne sur un certain nombre de sites. Une raie est mesurable si l'énergie des rayons X du tube est suffisante pour provoquer une ionisation dont la désexcitation provoque l'émission voulue. Par exemple, la raie Kα1 du tantale (Z = 73) a une énergie de 57,6 keV, ce qui signifie qu'il faut une tension d'accélération du tube supérieure à 57,6 kV (57 600 V). Les tubes et leur électronique d'alimentation sont souvent limités à 60 kV.

Pour les appareils dispersifs en longueur d'onde, la longueur d'onde de la radiation doit donner un angle de diffraction dans la limite des butées du goniomètre de l'appareil. Quel que soit le goniomètre, la longueur d'onde doit être inférieure au double de la distance interréticulaire du cristal analyseur 2d. Par ailleurs, si la déviation est très faible, le faisceau s'étale sur le cristal analyseur et le détecteur reçoit une portion plus faible du signal. Par exemple, pour un cristal LiF200, la longueur d'onde doit être supérieure à 0,285 nm (2,85 Å) soit une énergie minimale de 4,4 keV, et si l'on considère que la déviation minimale exploitable est 10 °, cela correspond à une longueur d'onde de 0,049 nm (0,49 Å) soit une énergie maximale de 25,3 keV.

Le rendement du détecteur doit être suffisant pour l'énergie concernée. Les plages typiques d'utilisation sont :

- détecteur semi-conducteur: 1keV à 50 keV, (longueurs d'onde de 12 Å à 0,25 Å), avec une plage optimale entre 1,6 keV et 24,8 keV ;

- scintillateur : 3 keV à 60 keV (longueurs d'onde de 4 Å à 0,2 Å), avec une plage optimale entre 6 keV et 40 keV (2 à 0,3 Å) ;

- compteur proportionnel à gaz : 0,18 keV à 50 keV (longueurs d'onde de 70 Å à 0,25 Å), avec une plage optimale entre 0,25 et 8,3 keV.

Dans la pratique, les différents types de détecteurs ne sont pas disponibles sur un même instrument. Les instruments EDS sont équipés exclusivement de détecteurs semiconducteurs. La contrainte d'un détecteur adapté à une analyse donnée peut conduire au choix de l'instrument, mais le détecteur présent sur l'appareil à disposition de l'opérateur conduit également ce dernier à sélectionner l'une des raies parmi plusieurs possibles.

D'autres phénomènes, qui dépendent de la composition de l'échantillon, entrent en ligne de compte dans le choix de la raie :

- la proximité de raies voisines (superposition de raies, interférences), on peut ainsi préférer, pour un élément, une raie ayant un rendement moins bon mais qui n'est pas perturbée ;

- la profondeur analysée : une raie peu énergétique a une profondeur de pénétration faible, la couche superficielle doit donc être représentative de l'échantillon ce qui rend la préparation critique (problématique similaire à celle de l'échantillonnage) ; une raie très énergétique pénètre profondément, donc le signal est une moyenne sur un volume important, mais si l'échantillon est trop mince, l'hypothèse de « l'épaisseur infinie » n'est plus valable ;

- le bruit de fond : certaines zones ont plus de bruit de fond que d'autres (par exemple proximité des raies caractéristiques du tube diffusées par effet Rayleigh et Compton).

Choix des conditions de mesure

Une fois la raie choisie se pose la question des conditions de mesure, et tout d'abord du type d'appareil : appareil dispersif en longueur d'onde ou en énergie ? Ce choix se fait au moment de l'achat de l'appareil, on choisit l'appareil en fonction des applications prévues, mais aussi du coût et de l'infrastructure requise (espace, alimentation en fluides).

Quelle excitation du tube ? la puissance du tube étant limitée (typiquement 1 à 4 kW pour un appareil dispersif en longueur d'onde), il faut donc trouver un bon rapport tension/intensité. Une raie très énergétique nécessite une tension d'accélération forte pour exciter l'élément ; une raie peu énergétique a un mauvais rendement, il faut donc favoriser l'intensité du courant d'excitation aux dépens de la tension (de fait, la tension peut être faible puisque l'énergie d'excitation l'est aussi). Il faut considérer présence éventuelle d'un filtre pour couper les raies caractéristiques du tube, et donc réduire l'effet Rayleigh et Compton qui peuvent perturber la raie mesurée (augmentation du bruit de fond) ;

Pour les appareil dispersifs en énergie (EDS) se pose la question du choix des paramètres de traitement du signal, favorisant la résolution (pouvoir de séparation) ou l'intensité (limite de détection). Pour les appareils dispersifs en longueur d'onde se pose systématiquement la question du choix du cristal et du collimateur qui peut, selon la réponse qui est faite, favoriser la résolution spectrale ou au contraire la limite de détection. D'une façon générale, une bonne résolution ira dans le sens de la réduction de l'intensité du signal, et donc de la dégradation de la limite de détection. Le paramétrage du détecteur, et en particulier du discriminateur qui filtre les impulsions, doit faire face à la même contradiction : la résolution en énergie s'oppose à la limite de détection. S'il est possible de choisir le détecteur en analyse WDS, le compteur proportionnel optimisera la mesure des faibles énergies, alors que le scintillateur optimisera les fortes énergies.

La maturité de la technique qui a dégagé un certain nombre d'applications de routine. Par ailleurs, du fait des progrès du matériel et du logiciel informatique, une part de plus en plus croissante de l'expertise a été transférée de l'opérateur vers le logiciel embarqué avec les appareils de mesure. Le développement d'appareils bon marché a aussi contribuer à favoriser l'usage des instruments par un personnel peu qualifié. Bien que certaines applications restent encore du domaine de l'expert, les fabricants d'appareils fournissent des bibliothèques de raies et de conditions de mesure toutes faites pour les principales applications, l'utilisateur « n'ayant plus qu'à » choisir parmi les conditions préétablies. Une partie de l'expertise enfouie dans l'instrument réside dans la façon dont l'appareil est étalonné en usine.

Étalonnage

En introduction à sa contribution sur les méthodes de standadisation utilisées en XRF, Mauser applique à la XRF l'adage de métrologie souvent cité pour toutes sortes de techniques de mesures. « X-Ray fluorescence is the best method to get wrong results in a perfectly reproducible way ». En fait, comparé à d'autres techniques, la XRF repose sur un corpus théorique suffisamment opérationnel pour que des instruments simplement réglés en usine donnent des résultats « pas si faux que ça ».

Étalonnage d'usine (méthodes dites « semi-quantitatives » ou « sans étalon »)

Grâce aux méthodes de correction de matrice par les paramètres fondamentaux, il est possible de faire un étalonnage « universel » de la machine en usine. Le terme « universel » signifie qu'il est indépendant du type d'échantillon à condition que les hypothèses physiques faite lors du développement de l'étalonnage soient respectées. Dans le cas général, ces hypothèses sont :

- l'homogénéité de l'échantillon ;

- l'exhaustivité qui implique que tous les éléments sont mesurés ou estimés par stœchiométrie ou par complément à 100 %.

En général, l'étalonnage est fait par le constructeur sur un appareil de référence. C'est un étalonnage qui comporte peu de points par élément, éventuellement même un seul point : il s'agit de déterminer la sensibilité du système pour une raie donnée. L'étalon est souvent fait de l'élément pur ou de son oxyde pur.

L'étalonnage doit ensuite être transposé sur l'appareil final, pour prendre en compte les différences avec l'appareil de référence. Pour cela, on dispose d'un jeu d'échantillons stables (en général des verres) qui sont mesurés sur l'appareil de référence et sur l'appareil final ; le rapport des intensités mesurées sur les deux appareils est appliqué aux coefficients d'étalonnage.

On désigne souvent ces méthode de :

- méthodes « semi-quantitatives » (« semiquant » en abrégé) : en effet, l'échantillon ne respectant pas nécessairement les hypothèses émises, la précision ne peut être garantie (lorsque l'on développe un étalonnage spécifique, si les étalons ont les mêmes « défauts » que les inconnus, ces défaut sont intégrés dans le coefficient d'étalonnage) ;

- méthodes « sans étalon » (« standardless » en anglais), car l'utilisateur n'a pas a préparer d'étalon.

Les deux dénominations sont erronées : si l'échantillon répond aux hypothèses, le résultat est tout à fait précis, et donc pas semi-précis, et les méthodes ont bien été faite à partir d'étalons mesurés en usine.

Étalonnage spécifique

Pour de nombreuses applications, l'étalonnage d'usine est insuffisant ou inapproprié : c'est la cas lorsque les hypothèses sous-jacentes ne sont pas valables, par exemple l'échantillon n'est pas homogène mais il est sous forme de poudre, d'une solide cristallisé ou d'un dépôt sur filtre. On peut aussi demander à l'analyse une grande précision, et la simple transposition d'un étalonnage d'une machine sur l'autre ne permet pas d'atteindre cette précision. On veut travailler avec des conditions de mesure différentes de celles utilisées pour l'étalonnage en usine, et ces différences ne sont pas facilement transposables, par exemple lorsque la haute tension du tube est différente . Dans ces cas-là, il faut faire un étalonnage spécifique.

Cet étalonnage spécifique requiert de définir explicitement des méthodes de standardisation qui recouvrent aussi bien les préparations d'échantillon que le choix d'échantillon de référence et le protocole de mesure et de traitement des résultats de mesure qui aboutissent à la production des résultats finaux. Le protocole de mesure et de traitement des données comprend notamment, pour la XRF, la détermination et la soustraction du fond continu, la mesure et la correction des dérives instrumentales, la déconvolution effets de recouvrement de pics, la prise en compte d'échantillons de référence contenant l'élément à mesurer ou au contraire ne le contenant pas et la correction des effets de matrice.

La plus grande difficulté d'un étalonnage est de définir les étalons, que l'on appelle parfois « étalons externes » par opposition à la méthode de l'étalon interne parfois utilisée pour corriger des effets de matrice ; on peut pour cela utiliser des étalons certifiés fournis d'un organisme référent, faire soi-même ses étalons, ou bien à défaut utiliser des produits inconnus que l'on caractérise par d'autres méthodes, par exemple l'ICP. Les organismes de standardisation organisent également des Round-robins qui consistent à comparer les mesures effectuées par plusieurs laboratoires spécialisés sur le même échantillon. Mauser not que beaucoup de méthodes de standardisation pratiquée par des laboratoires spécialisées permettent d'obtenir les mêmes résultats pourvu que le même protocole soit suivi, mais ne mentionnent ni le biais de mesure ni les résultats détaillés obtenus au cours des round-robin.

Facteurs de mérite

On attend généralement d'un appareil mettant en œuvre la spectrométrie de fluorescence X qu'il mesure des concentrations. Les facteurs de mérite de l'appareil sont donc ceux qui participent à la qualité métrologique des appareils de mesure : résolution latérale, résolution en profondeur, sensibilité et limite de détection.

La résolution latérale et la résolution en profondeur dépendent essentiellement de la source primaire, mais aussi du processus d'interaction rayonnement primaire matière. La sensibilité sera d'autant meilleure que la source est énergétique et qu'il n'y a pas de perte dans le spectromètre. L'implantation des spectromètres par rapport à l'échantillon détermine l'angle solide du rayonnement fluorescent qui sera effectivement capté par la détection. La limite de détection dépend en partie du niveau de bruit de fond du spectre et des techniques de post-traitement dont on dispose pour soustraire ce fond. Il importe aussi, pour que la mesure soit juste, qu'il n'y ait pas d'erreur sur l'identification du pic mesuré et cette dernière dépend en partie de la résolution spectrale, c'est-à-dire du pouvoir de séparation des pics. La résolution spectrale dépend surtout de la nature et de la qualité des spectromètres. Le problème de l'identification des pics est également compliqué par les effets de matrice.

Estimation des éléments légers

Les éléments légers (numéro atomique Z faible) sont très difficilement mesurables en fluorescence X :

- le rendement de fluorescence est très mauvais, ils produisent plutôt des électrons Auger ;

- l'énergie des raies est faible, les photons sont facilement absorbés et génèrent donc un faible signal ;

- les raies des éléments sont proches, il est difficile de les distinguer les unes des autres.

Sous vide avec un appareil dispersif en longueur d'onde, on peut mesurer jusqu'au bore (Z = 5), mais il faut un cristal analyseur spécial pour le bore, un pour le carbone et un pour l'azote. Si l'on utilise un gaz (en général l'hélium) pour maintenir une pression sur l'échantillon, on ne peut mesurer que jusqu'au sodium (Z = 11). En général, même sous vide, on estime que pour les éléments plus légers que le sodium, la mesure est très difficile.

Cependant, ces éléments ont une influence importante sur les effets de matrice. Donc, même si l'on ne s'y intéresse pas, il faut pouvoir les estimer. Cela peut se faire :

- par des mesures extérieures : par exemple mesure de CHNS (oxydation du matériau et analyse des gaz ainsi produits : CO2, NOx, H2O, SO2) ou bien mesure par IGA (interstitial gas analysis) ; ces concentrations sont ensuite entrées manuellement au logiciel qui les prend en compte pour les corrections ; on peut envisager de récupérer les concentrations sur une base de données (LIMS)

- en altérant l'échantillon pour éliminer ces éléments, par oxydation (par exemple lors de la fabrication d'une perle fondue) ; on peut connaître la quantité de composés volatils (perte au feu) par pesée, mais pas leur nature ; on aura donc une mesure précise sur l'échantillon calciné, et on pourra calculer les concentrations dans l'échantillon avant calcination, mais cela ne s'applique pas aux éléments légers qui « résistent » à la calcination ;

- en estimant leur concentration par stœchiométrie : si l'on sait que ces éléments sont liés à des éléments plus lourds dans des composés définis, les mesures pour les éléments lourds permettent de calculer la quantité en éléments légers.

Cette dernière technique est beaucoup utilisée pour les oxydes : par exemple on mesure la quantité d'aluminium, et l'on calcule la quantité d'oxygène lié à partir de la formule de l'alumine.

Expression des résultats

La spectrométrie de fluorescence X est une méthode d'analyse élémentaire, donc permet de déterminer les concentrations en éléments purs. Cependant, les éléments sont souvent présents sous la forme de composés (molécules, cristaux polyatomiques) dans le matériau initial. Il peut donc être souhaitable de présenter des pourcentage de composés plutôt que d'éléments. On exprime par exemple souvent des concentrations en oxyde, en particulier en géochimie ou pour les ciments.

La concentration en composés est calculée, en général par le logiciel d'analyse, à partir des concentrations en éléments et des formules chimiques. Si l'élément n'est pas présent sous la forme indiquée, alors l'expression en composé est fausse, bien que l'analyse soit juste.

Par exemple, le fer peut être présente sous la forme de fer pur Fe, ou d'oxyde de fer : wustite FeO, hématite Fe2O3, magnétite Fe3O4, mais aussi sulfure : pyrrhotite FeS, marcassite FeS2, ou encore sulfate : sulfate ferreux FeSO4, sulfate ferrique Fe2(SO4)3, … La spectrométrie de fluorescence X ne permet pas de déterminer la forme sous laquelle le fer est lié, et les éléments liés sont en général légers donc non mesurables, l'expression sous la forme d'un composé unique peut donc être fausse.

Ceci peut donner une somme des concentrations inférieure ou supérieure à 100 %.