Matrice (mathématiques) - Définition

En mathématiques, les matrices servent à interpréter en termes calculatoires et donc opérationnels les résultats théoriques de l'algèbre linéaire et même de l'algèbre bilinéaire. Toutes les disciplines étudiant des phénomènes linéaires utilisent les matrices. Quant aux phénomènes non linéaires, on en donne souvent des approximations linéaires comme c'est le cas en optique géométrique avec les approximations de Gauss.

Définitions

Soient A un ensemble et (m,n) un couple d'entiers positifs.

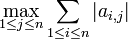

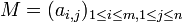

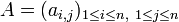

On appelle matrice à coefficients dans A, corps commutatif quelconque, de dimension (ou taille) (m,n) -ie à m lignes et n colonnes-, une famille (ai,j)d'éléments de A indexée par le produit cartésien des ensembles de nombres entiers [1,m] et [1,n].

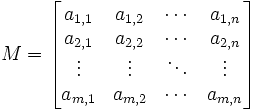

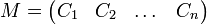

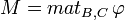

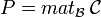

La matrice M pourra être notée par

-

ou plus simplement (ai,j)i,j, voire (ai,j) si le contexte s'y prête.

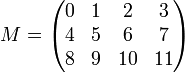

On représente généralement une matrice sous la forme d'un tableau rectangulaire. Par exemple, est représentée ci-dessous une matrice M, à coefficients entiers, et de dimension (3,4) :

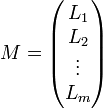

Dans cette représentation, le premier coefficient de la dimension est le nombre de lignes, et le deuxième, le nombre de colonnes du tableau. Une matrice pour laquelle le nombre m de lignes est égal au nombre n de colonnes sera dite matrice carrée de taille n. Une matrice ne comportant qu'une seule ligne et n colonnes est appellée matrice ligne de taille n. Une matrice ne comportant m lignes et une seule colonne est appellée matrice colonne de taille m.

Pour repérer un coefficient d'une matrice, on indique son indice de ligne puis son indice de colonne, les lignes se comptant du haut vers le bas et les colonnes de la gauche vers la droite. Par exemple, on notera ai,j, les coefficients de la matrice M, pour

La disposition générale des coefficients d'une matrice M de taille (m,n) est donc la suivante

Pour effectuer certaines opérations, il peut être utile de travailler sur le système des lignes ou des colonnes d'une matrice. On pourra alors l'écrire sous une des formes suivantes

-

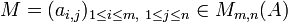

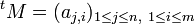

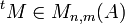

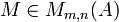

L'ensemble des matrices à coefficients dans A possédant m lignes et n colonnes est noté Mm,n(A). Lorsque m=n on note plus simplement Mn(A).

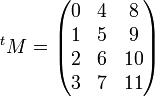

Soit

Par exemple, avec la matrice M des exemples précédents, on a

L'opération de transposition est involutive, c'est-à-dire que

Espaces de matrices

On suppose maintenant que A est muni d'une structure d'anneau unitaire ; les éléments de A seront appelés scalaires, par opposition aux matrices dont nous allons voir qu'elles peuvent être considérées comme des vecteurs.

Addition et multiplication par un scalaire

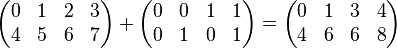

On définit sur Mm,n(A) une loi de composition interne provenant de l'addition des scalaires :

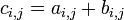

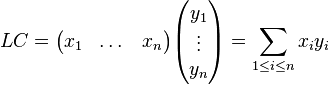

- (ai,j) + (bi,j) = (ci,j) où

On ne peut additionner que deux matrices de même taille.

- Exemple :

Pour chaque valeur du couple (m,n), l'espace Mm,n(A) devient alors un groupe abélien, d'élément neutre la matrice nulle, celle dont tous les coefficients valent 0.

On définit aussi une opération à gauche de A sur chaque espace Mm,n(A)en associant à chaque matrice (ai,j) à coefficients dans A et chaque scalaire λ dans A, la matrice λ(ai,j) = (λai,j) obtenue en effectuant la multiplication, dans A, de tous les coefficients de la matrice initiale par λ : c'est la multiplication par un scalaire.

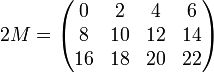

En reprenant toujours la matrice M du premier exemple :

Les espaces Mm,n(A) ainsi obtenus ont donc une structure de A-module à gauche, et plus particulièrement de A-espace vectoriel, si A est un corps commutatif.

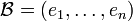

Base canonique de l'espace des matrices

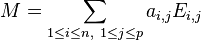

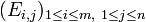

Alors Mm,n(A) est un A-module libre de dimension mn, muni d'une base canonique

Pour toute matrice M, les coordonnées dans la base canonique sont les coefficients

- Exemple :

Produit matriciel

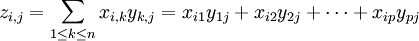

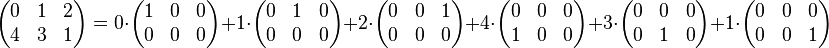

On commence par définir le produit d'une matrice ligne par une matrice colonne. Soit n un nombre entier, L une matrice ligne, xi ses coefficients, C une matrice colonne, yi ses coefficients. On les suppose toutes deux de taille n. On définit alors le produit, considéré comme un scalaire ou une matrice de dimension (1,1) :

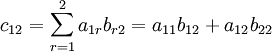

On remarque la condition de compatibilité sur les tailles des matrices (égalité du nombre de colonnes de la première avec le nombre de lignes de la deuxième). On définit maintenant plus généralement un produit entre deux matrices, la première, (xi,j) dans Mm,n(A), la deuxième, (yi,j) dans Mn,p(A), toujours avec une condition de compatibilité sur les tailles (et l'ordre des facteurs de la multiplication ne peut en général pas être changé). Le résultat obtenu est une matrice de Mm,p(A), dont les coefficients (zi,j) sont obtenus par :

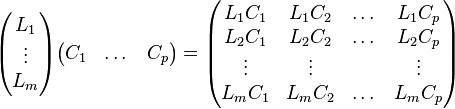

A la lumière de l'exemple de la multiplication d'une matrice ligne par une matrice colonne, on peut reformuler cette définition en disant que ce coefficient est égal au produit de la ligne i de la première matrice par la colonne j de la deuxième, ce qui s'écrit de la manière suivante, si les Li sont les lignes de la première matrice, et les Cj les colonnes de la deuxième, le produit est :

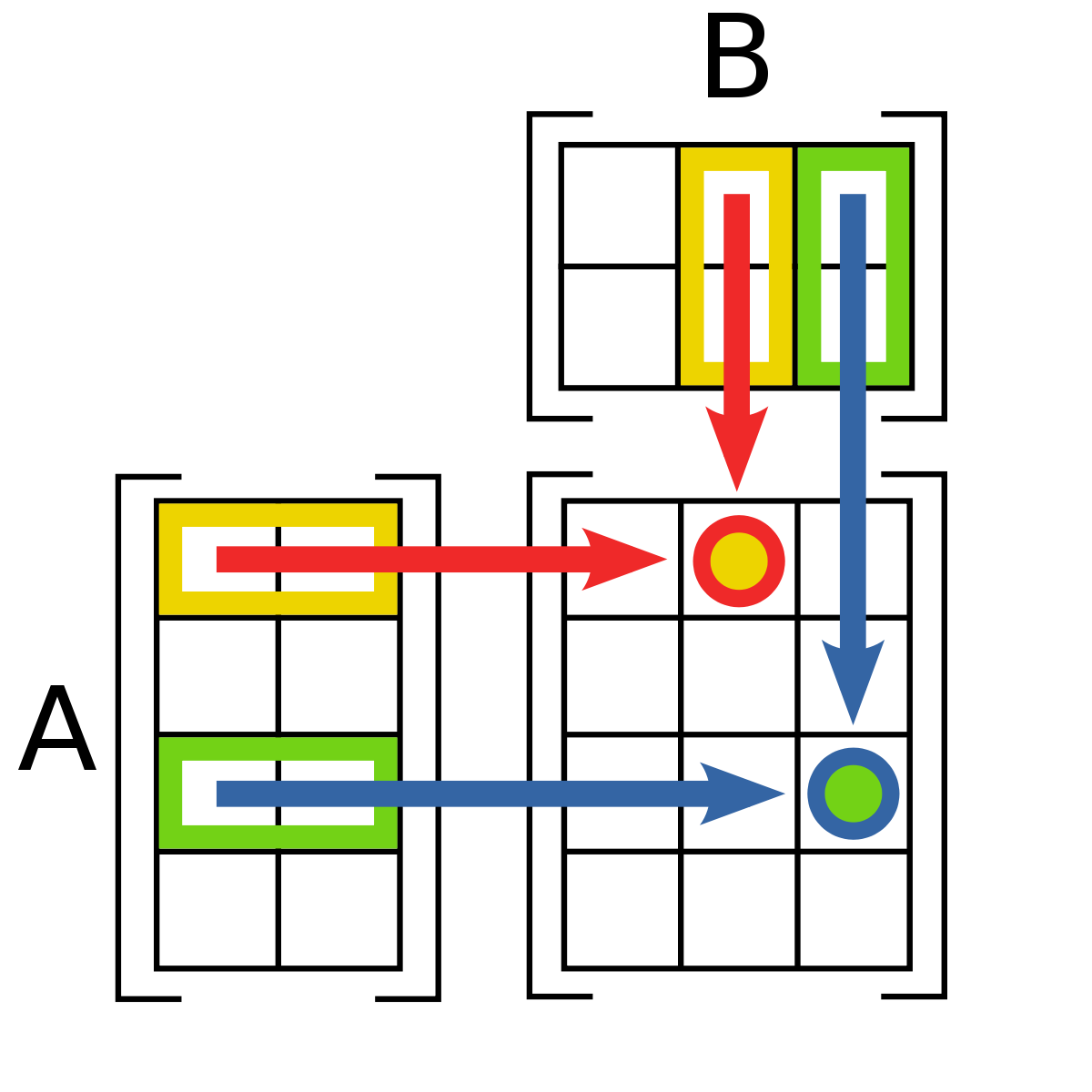

Pour calculer en pratique un produit, il est nécessaire de visualiser l'opération. On considère le coefficient c12 de la matrice produit MN si M est une matrice de type (4, 2), et N est une matrice de type (2, 3).

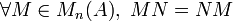

Le produit matriciel est associatif, distributif à droite et à gauche par rapport à l'addition matricielle. En revanche, même si les dimensions permettent de donner un sens à la question, même si l'anneau des scalaires est commutatif, un produit de matrices ne commute en général pas : MN n'est pas égal à NM, par exemple :

Ce contre-exemple prouve même que les matrices MNet NM ne sont pas toujours semblables.

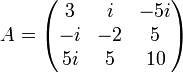

Lorsque l'anneau des scalaires est commutatif, la transposition et le produit matriciel vérifient la propriété :

Matrice identité et inverse d'une matrice

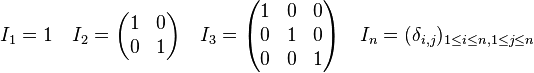

Pour chaque nombre entier n, on note In la matrice carrée de taille n dont les coefficients diagonaux sont égaux à 1 et dont les autres coefficients sont nuls ; elle est appelée matrice identité de taille n.

où δi,j désigne le symbole de Kronecker.

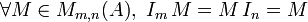

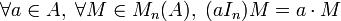

Sous réserve de compatibilité des tailles, les matrices In sont neutre à droite et à gauche pour la multiplication.

Soit M une matrice de dimension (m,n). On dit que M est inversible à droite (respectivement à gauche) si et seulement s'il existe une matrice N de taille (n,m) telle que

Algèbre des matrices carrées

Lorsque l'anneau A est commutatif, l'ensemble des matrices carrées Mn(A) est donc muni d'une structure d'algèbre associative et unitaire avec l'addition matricielle, le produit par un scalaire et le produit matriciel.

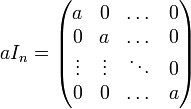

On appelle matrice scalaire une matrice de la forme aIn où a est un élement de l'anneau K.

Ces matrices s'appellent matrices scalaires car elles se comportent comme des scalaires, vis-à-vis de la mutliplication :

Lorsque A est commutatif, ou à défaut, losque a est central dans A, c'est-à-dire lorsque a commute avec tous les éléments de A, on a

Réciproquement, toute matrice N de Mn(A) telle que

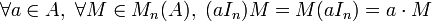

Une matrice de la forme :

sera dite matrice diagonale.

Outre le déterminant, une autre fonction à noter est la trace. Toutes deux apparaissent dans un objet plus général, le polynôme caractéristique, qui a sont tour permet d'obtenir certaines caractérisations des matrices diagonalisables (c'est-à-dire semblable (voir ci-dessous) à une matrice diagonale), ou de la trigonalisation.

Actions du groupe linéaire

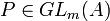

Il existe plusieurs manières de faire agir le groupe linéaire

- action par multiplication à gauche de

- action (à droite) par multiplication à doite de

- action par conjugaison de

On décrit maintenant les résultats classiques sur ces actions, lorsque les scalaires forment un corps commutatif. Les deux premières actions sont souvent considérées simultanément ; on s'intéresse donc à la question : deux matrices M1 et M2 de dimension (m,n) étant données, existe-t-il des matrices

Pour l'action par conjugaison, deux matrices carrées M1 et M2 de taille n dans la même orbite admettent une relation de la forme M1 = PM2P − 1, pour une certaine matrice P inversible de taille n ; deux telles matrices sont dites semblables. La description d'un système complet d'invariants est plus délicate. On appelle ces invariants les invariants de similitude. D'un point de vue algorithmique, la réduction d'une matrice quelconque à une matrice sous une forme privilégiée se fait par un algorithme inspiré de celui du pivot de Gauss, voir théorème des facteurs invariants.

Interprétations linéaires

Un intérêt principal des matrices est qu'elles permettent d'écrire commodément les opérations habituelles de l'algèbre linéaire, avec une certaine canonicité.

Coordonnées

Le premier point est de remarquer que le A-module An s'identifie canoniquement à l'espace de matrices colonnes Mn,1(A) : si ei est le n-uplet dont tous les coefficients sont nuls, sauf le i-ème qui vaut 1, on lui associe la matrice colonne élémentaire dont tous les coefficients sont nuls sauf le i-ème qui vaut 1, et on étend l'identification par linéarité ; la matrice associée à chaque n-uplet sera appelée matrice coordonnée canonique.

D'autres identifications sont cependant possibles ; lorsqu'on peut parler de base (si l'anneau des scalaires est un corps, ou est principal, par exemple), on peut associer les matrices colonnes élémentaires à n'importe quelle base de l'espace An (ou plus généralement d'un A-module libre), puis à nouveau étendre par linéarité ; les matrices associées seront appelées matrices coordonnées dans la base envisagée.

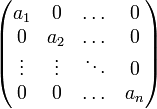

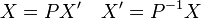

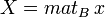

On peut concaténer les matrices coordonnées, dans une base fixée, de plusieurs n-uplets. On obtient ainsi la matrice coordonnée d'une famille de vecteurs. Le rang de la matrice est alors défini comme la dimension de la famille de ces vecteurs. En particulier la matrice d'une base dans une autre base est appelée matrice de passage entre ces deux bases, ou matrice de changement de base. Si X et X' sont les matrices coordonnées du même vecteur dans deux bases B et C, et que P est la matrice de la base C dans la base B, on a la relation :

Applications linéaires

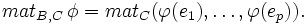

Soit E et F deux A-module (à gauche) libres de dimensions finies. Soit B=(e1,...,ep) une base de E et C=(f1,...,fn) une base de F. Soit enfin φ une application linéaire de E dans F.

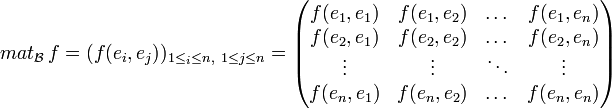

On appelle matrice de φ dans le couple de bases (B,C) la matrice :

Soit x un vecteur de E. Notons

Cette formule devient

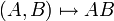

L'application

En conséquence, il arrive souvent qu'on l'identifie avec l'application linéaire ci-dessus. On parlera alors de noyau de la matrice, d'espaces propres de la matrice, d'image de la matrice, etc.

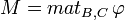

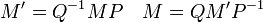

Si E et F sont deux A-modules, B et B' deux bases de E, de cardinal p, et C et C' deux bases de F de cardinal n, P la matrice de B' dans B et Q la matrice de C' dans C, alors les deux matrices M et M' d'une même application linéaire

-

On constate ainsi que deux matrices équivalentes, d'après la définition donnée plus haut dans l'article, sont deux matrices qui représentent la même application linéaire dans des bases différentes.

En particulier, dans le cas d'un endomorphisme, si on impose B= B' et C=C' , les formules précédentes se simplifient :

On constate ainsi que deux matrices semblables, d'après la définition donnée plus haut dans l'article, sont deux matrices qui représentent le même endomorphisme dans des bases différentes.

Interprétations bilinéaires

Dans ce paragraphe, l'anneau commutatif des scalaires sera noté

Le cas non commutatif existe aussi mais il faut prendre quelques précautions et les notations deviennent trop lourdes pour cet article.

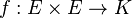

Matrice d'une forme bilinéaire

Soit E un K-module libre et

Soit

Dans le cas particulier où

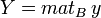

Soit x et y deux vecteurs de E. Notons X et Y leurs coordonnées dans la base

Deux formes bilinéaires sont égales si et seulement si elles ont la même matrice dans une base donnée.

Matrice d'une forme quadratique

Lorsque

Formule de changement de base

Soit E un K-module libre,

Notons

Matrices congruentes

Deux matrices carrées A et B sont dites congruentes s'il existe une matrice inversible P telle que A = tPBP.

Deux matrices congruentes sont deux matrices qui représentent la même forme bilinéaire dans deux bases différentes.

Lorsque

Matrices orthogonales

Matrices unitaires

Matrices symétriques

Matrices antisymétriques

Matrice d'une forme sesquilinéaire

Matrices hermitiennes

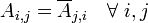

Une matrice A est dite hermitienne si

Exemple

Décomposition d'une matrice

- On utilise abusivement le terme décomposition d'une matrice, qu'il s'agisse d'une véritable décomposition (en somme) comme dans la décomposition de Dunford ou d'une factorisation comme dans la plupart des autres décomposition.

Réduction d'une matrice carrée

- Réduire une matrice, c'est trouver une matrice qui lui est semblable le plus simple possible.

- Une matrice diagonalisable est une matrice semblable à une matrice diagonale.

A est diagonalisable si et seulement si il existe une matrice inversible P et une matrice diagonale D telles que A = P − 1DP.

- Sur un corps algébriquement clos, on dispose de la réduction de Jordan qui est optimale et il existe des décompositions intermédiaires comme la décomposition de Dunford qui utilise les sous-espaces caractéristiques ou celle de Froebenius qui utilise les sous-espaces cycliques.

- Les polynômes d'endomorphismes jouent un rôle crucial dans les techniques de réduction.

Décomposition LU

- C'est une factorisation en produit de deux matrices triangulaires.

- En lien avec le pivot de Gauss, c'est une méthode qui permet d'inverser une matrice.

Décomposition QR

- C'est un résultat sur les matrices à coefficients réels ou à coefficients complexes.

- C'est une factorisation en produit d'une matrice orthogonale et d'une matrice triangulaire.

- C'est une traduction matricielle du procédé de Gram-Schmidt.

Décomposition polaire

- C'est un résultat sur les matrices à coefficients réels ou à coefficients complexes.

- C'est une factorisation en produit d'une matrice orthogonale et d'une matrice symétrique strictement positive dans le cas réel, en produit d'une matrice unitaire et d'une matrice hermitienne strictement positive dans le cas complexe.

- On peut décomposer à droite ou à gauche.

- On a unicité de la factorisation pour les matrices inversibles.

Normes et rayon spectral

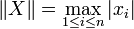

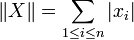

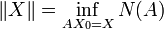

Dans tout ce paragraphe, les matrices considérées sont dans

Normes et normes d'algèbre

Soit N une norme sur

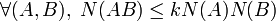

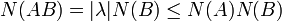

On dira que N est une norme d'algèbre (on dit aussi norme de Banach) si et seulement si

Certains auteurs imposent en outre que N(In) = 1

Pour une norme quelconque, l'application bilinéaire

Par suite, la norme

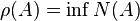

Rayon spectral

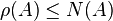

Soit A une matrice carrée à coefficients complexes. On appelle rayon spectral le plus grand module des valeurs propres de A. Dans tout ce qui suit, on notera ρ(A) le rayon spectral de A.

Théorème : Pour toute norme d'algèbre N sur

Démonstration : Soit λ une valeur propre de A et X un vecteur propre associé. notons B la matrice carrée dont la première colonne est X et les autres sont nulles. On a AB = λB donc

De plus, on montre que

Par contre, l'égalité peut s'évérer impossible. Il suffit pour cela de considérer une matrice non nulle dont le rayon spectral est nul :

Normes subordonnées

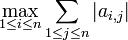

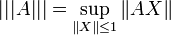

Lorsqu'on munit

En notant

- Si

- Si

Toute norme subordonnée est une norme d'algèbre avec en plus | | | In | | | = 1.

Démontrer la réciproque ou insérer contre-exemple pour la réciproque. Pour la réciproque, on pourrait construire

D'autre part, si deux normes subordonnées sont égales, les normes auxquelles celle-ci sont subordonnées sont proportionnelles. C'est une conséquence immédiate du théorème de Hahn-Banach.

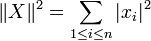

Norme subordonnée à la norme euclidienne

On se place dans la cas où

Lorsque A est une matrice symétrique (respectivement hermitienne), la norme de A est égale au rayon spectral de A.

Dans le cas où A est une matrice quelconque, la norme de A est égal à

La norme de A est donc la plus grande des valeurs singulière de A (les valeurs singulière de A sont, par définition, les racines carrées des valeurs propres de tAA).

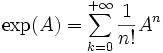

Exponentielle d'une matrice

Soit

Alors si N(A) < R, la série

En particulier, on peut définir, pour toute matrice carrée complexe, la quantité

Le calcul effectif de cette exponentielle se fait par réduction de la matrice.

L'exponentielle joue un rôle central dans l'étude des systèmes linéaires d'équations différentielles.