Histoire des mathématiques - Définition

La liste des auteurs de cet article est disponible ici.

Japon

Durant la période Edo (1603 - 1887), au Japon, se développe une mathématique sans influence de la mathématique occidentale mais inspirée de la mathématique chinoise, travaillant sur des problèmes d'essence géométrique. Des énigmes géométriques sont posées et résolues sur des tablettes en bois appelées Sangaku.

XXe siècle

Le XXe siècle aura été un siècle extraodinairement fécond du point de vue mathématique. Trois grands théorèmes dominent tous les autres : d'une part le théorème de Gödel ; d'autre part la démonstration de la conjecture de Tanyama-Shimura qui entraîna la démonstration du grand théorème de Fermat ; enfin la démonstration des conjectures de Weil par Pierre Deligne. De nouveaux domaines de recherche sont nés ou se sont développés : les systèmes dynamiques, suite aux travaux de Poincaré, les probabilités, la topologie, la géométrie différentielle, la logique, la géométrie algébrique, suite aux travaux de Grothendieck, ...

La communauté mathématique explose

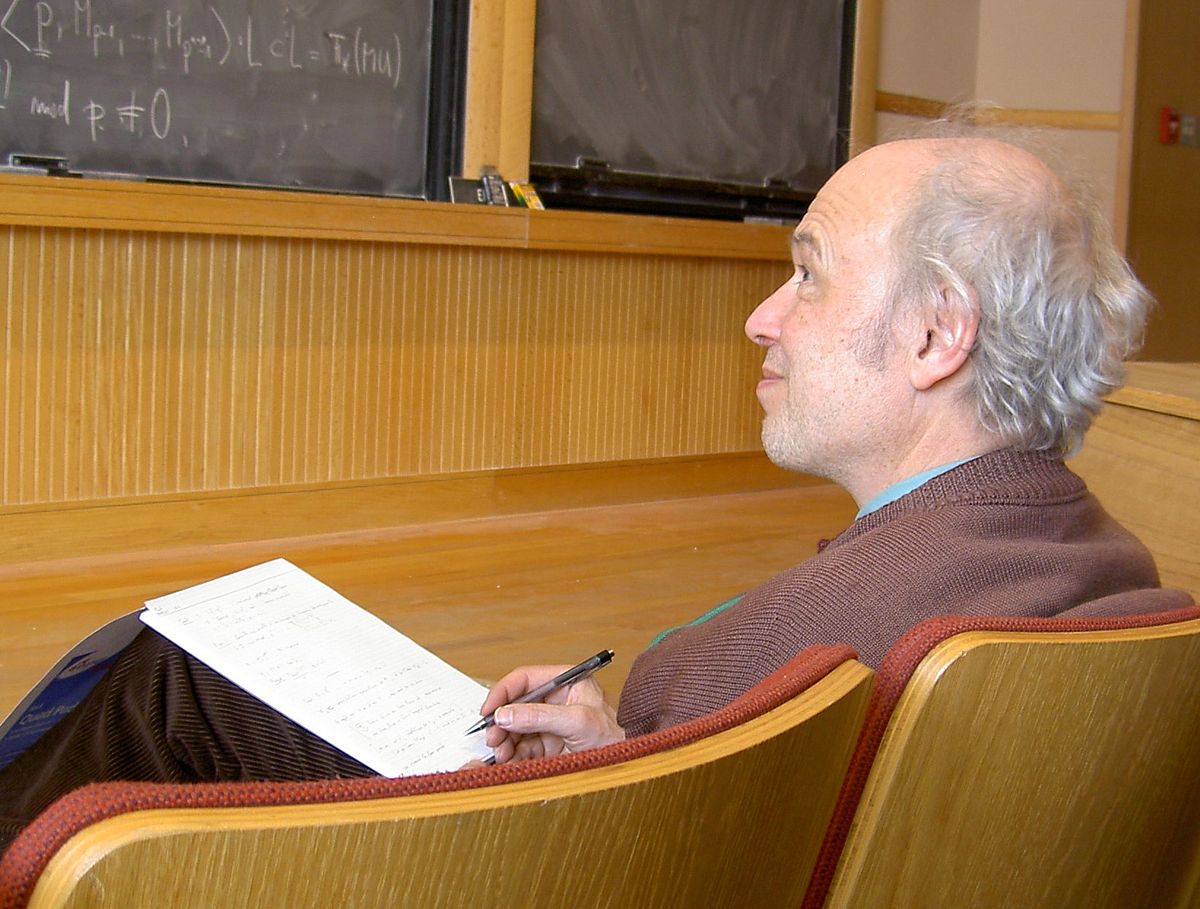

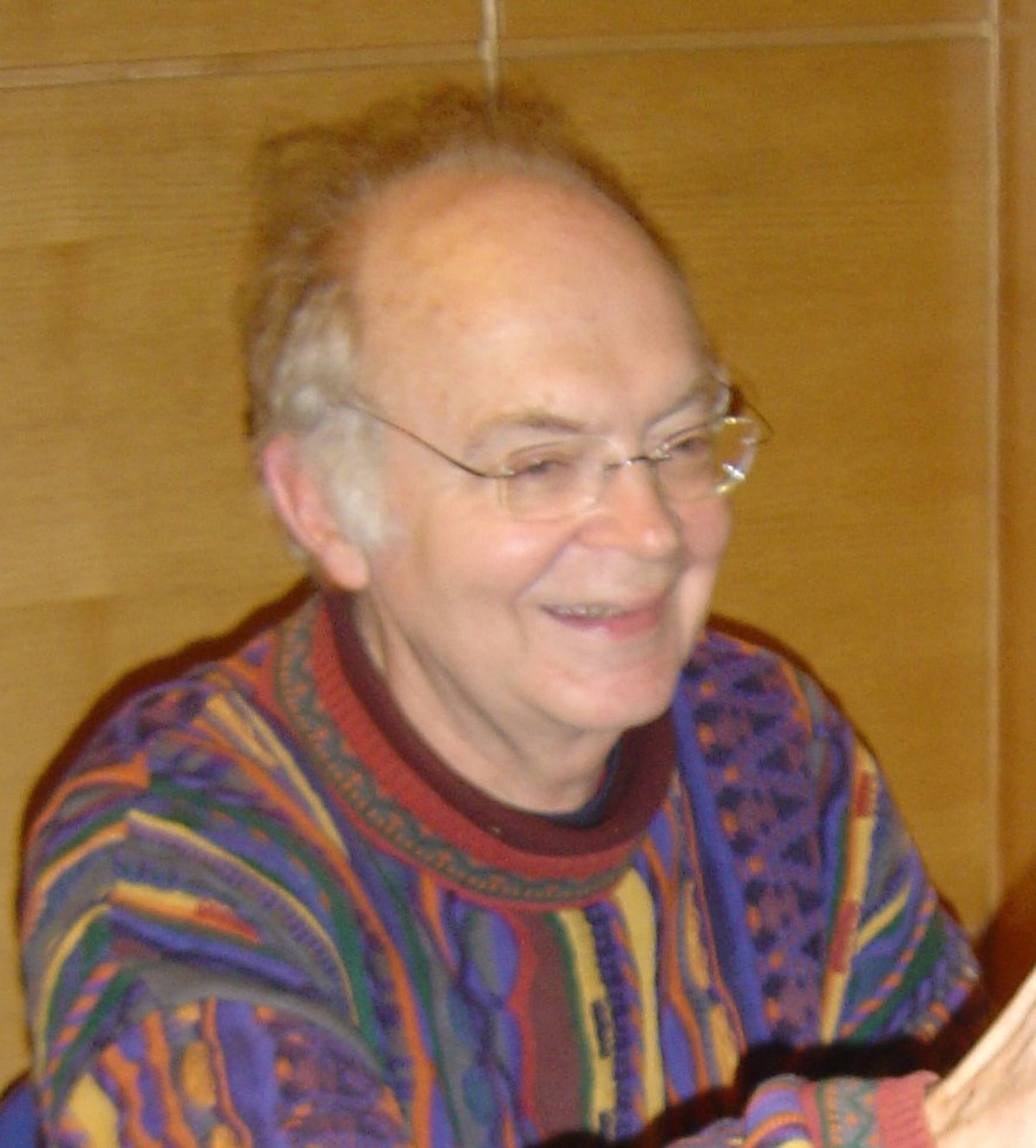

- Le métier de mathématicien a réellement commencé à se professionnaliser à la fin du XIXe siècle. Grâce à la mondialisation, aux progrès des transports, et aux moyens électroniques de communication, la recherche mathématique n'est plus localisée sur un pays ou un continent. Depuis la fin du XIXe siècle, de nombreux colloques, congrès, séminaires, se tiennent à un rythme soutenu, voire annuellement.

- Hormis deux congrès qui se sont tenus au XIXe siècle, vingt et un congrès internationaux de mathématiques se sont tenus au XXe siècle, un presque tous les quatre ans malgré les interruptions dues aux guerres mondiales.

- L'apparition de l'ordinateur a sensiblement modifié les conditions de travail des mathématiciens à partir des années 1980.

- Le développement mathématique a explosé depuis 1900. Au XIXe siècle, on estime qu'on publiait environ 900 mémoires par an. Actuellement plus de 15 000. Le nombre des mathématiciens est ainsi passé de quelques centaines ou milliers à plus d'un million et demi en moins d'un siècle.

- On a soutenu 292 thèses d'état de mathématiques entre 1810 et 1901 en France. À la fin du XXe siècle, c'est le nombre de thèses soutenues annuellement.

Algèbre

- Leonard Dickson commence l'étude systématique des corps finis et obtient la première classification des corps finis commutatifs. La structure de l'anneau des polynômes associé y est explicitée. Avec Joseph Wedderburn, en 1905, il démontre qu'il n'existe pas de corps fini non commutatif.

Mécanique

- Édouard Husson, dans sa thèse soutenue en 1906, résout définitivement le problème des intégrales premières de la mécanique classique pour le mouvement d'un solide autour d'un point fixe. Il n'y a que quatre intégrales premières possibles, la quatrième n'apparaissant que dans trois cas particuliers, le mouvement d'Euler-Poinsot, celui de Lagrange-Poisson et enfin celui de Sophie Kowaleski. L'intégration complète par quadrature est donc possible dans ces trois cas. Cependant Goriatchoff montre que l'intégration est aussi possible dans le cas de conditions initiales particulières, et un second cas est indiqué par Nicolaus Kowalevski en 1908.

- La mécanique, qui n'avait que peu changé depuis Newton, devient l'objet d'études poussées. Poincaré et Einstein publient une mécanique qui ne renferme la mécanique newtonienne qu'en y faisant tendre la célérité c de la lumière vers l'infini. La transformation de Galilée laisse sa place à la transformation de Lorentz. Et une nouvelle généralisation, une théorie de la gravitation, prend le nom de théorie de la relativité générale, entre 1909 et 1916, prétendant inclure le principe de Mach.

- La spéculation cosmologique prend maintenant une tournure totalement inattendue par une mathématisation sophistiquée. L'univers statique d'Einstein et celui de De Sitter sont bientôt accompagnés par des univers en évolution régis par les équations de Friedman, aidé par les recherches de Hubble et Humason qui viennent de découvrir le décalage vers le rouge. Ces progrès spectaculaires sont cependant tempérés par la découverte de la mécanique quantique. Si tout va bien de ce côté jusqu'à l'année 1924, la thèse de De Broglie remet tout en cause. Celle-ci part de l'idée de l'identité entre le principe de Fermat et le principe de moindre action de Maupertuis pour le photon, associant ainsi à une particule une onde Ψ. L'école de Copenhague interprète les relations d'incertitudes d'Heisenberg comme une invitation à ne considérer l'onde Ψ que comme une probabilité de présence, rompant avec un déterminisme total qui étaient l'apanage de la mécanique de Newton et dont Einstein sera le défenseur acharné dans le paradoxe Einstein-Podolski-Rosen. La mécanique d'Einstein, dont on a vérifié la concordance avec les observations, s'accorde très bien aux faits expérimentaux à grande échelle. La mécanique quantique, de son côté est la reine à l'échelle atomique et moléculaire. Et les deux mécaniques ne s'accordent pas. Les différentes tentatives d'unification sont autant d'échecs au point qu'on désespère de trouver cette théorie unitaire qui réconcilierait les deux mondes. La théorie pentadimensionnelle de Kaluza-Klein, la théorie d'Einstein de 1931, la théorie de la double solution de De Broglie, la théorie cinématique de Milne, les spéculations d'Eddington sur le nombre 137, la théorie de Bondi et Gold, ... apportent chacune une idée nouvelle mais qui ne résolvent pas le problème de l'incompatibilité des deux mécaniques. Les auteurs, surtout des physiciens, se lancent à corps perdu dans une algébrisation de leurs théories qui débouchent sur la théorie des cordes, la théorie M, ... qui sont encore loin de résoudre toutes les questions posées. La théorie unitaire, la grande unification n'est pas pour ce siècle.

- Alors qu'Einstein en avait fait une de ses motivations pour proposer la relativité, Kurt Gödel montre que le principe de Mach n'est pas inscrit dans les équations de la relativité générale.

Analyse

- Le siècle commence par la thèse de Lebesgue "intégrale, longueur, aire" qui constitue vraiment le début de la théorie de la mesure. Par la suite, de nouvelles intégrales sont crées sur les traces de Lebesgue (intégrales de Denjoy, de Perron et d'Henstock, ...). La théorie de la mesure finit par rejoindre la théorie des probabilités qui est axiomatisée en 1933 par Kolmogorov.

- La théorie de Lebesgue mène à l'étude des espaces Lp. Et sur les traces de Hilbert, Riesz (auteur du célèbre théorème de représentation qui porte son nom), Banach, les opérateurs différentiels sont étudiés. C'est l'occasion de créer la théorie des distributions, dont les prémisses avaient été données par Hadamard qui avait introduit les parties finies dans un problème d'hydrodynamique. S'illustrent ainsi Guelfand, Chilov, Schwartz, Vekua. L'étude des conditions de régularité des solutions des équations aux dérivées partielles permet à Sergueï Sobolev et ses continuateurs de définir ses espaces de fonctions et les théorèmes de trace en fonction des propriétés géométriques du domaine.

- La théorie spectrales des opérateurs linéaires, notamment auto-adjoints, opérant dans un espace de Hilbert a été commencée par David Hilbert, dans six mémoires publiés entre 1904 et 1910. Henri Weyl, de son côté fit avancer la théorie des équations différentielles singulières du second ordre. John Von Neumann développa le concept de l'espace de Hilbert abstrait entre 1927 et 1929, cadre dans lequel il commença l'étude des opérateurs auto-adjoint non bornés essentiellement pour les besoins de la théorie quantique naissante. Fréderic Riesz et M. H. Stone développèrent la théorie spectrale et l'étendirent aux opérateurs normaux non bornés. Des applications aux opérateurs différentiels et l'extension aux opérateurs semi-bornés symmétriques furent l'oeuvre de K. O. Friedrichs en 1934 et Krein en 1947.

- En 1927, la théorie des corps ordonnables d'Artin-Schreier permet de clarifier la nécessité d'un argument d'analyse dans la preuve du théorème fondamental de l'algèbre, le théorème de D'Alembert-Gauss.

- Abandonnés depuis le formalisme de Weierstrass, vers 1850, les infiniments petits de l'époque héroïque (XVIIe siècle) reprennent du service sous l'impulsion de Abraham Robinson en 1960 qui crée l'Analyse non standard. En 1970, Nelson ajoute à l'axiomatique classique de Zermelo-Fraenkel+axiome du choix (ZFC) un nouveau prédicat qui lui permet d'interpréter l'analyse non standard de Robinson dans une théorie plus facile. Les résultats démontrés dans l'analyse non standard qui s'expriment dans ZFC seul sont alors vrais dans ZFC seul.

Théorie des groupes

- La théorie des groupes occupe beaucoup de monde. Notamment les groupes finis sporadiques dont l'étude ne sera achevée que dans les années 1980. L'étude des groupes de Lie se poursuit et l'algébrisation de la physique devient un enjeu majeur.

Topologie

- Poincaré énonce en 1904 la conjecture qui porte son nom : « Considérons une variété compacte V simplement connexe, à 3 dimensions, sans bord. Alors V est homéomorphe à une hypersphère de dimension 3 ». Elle sera démontrée en 2003 par Grigori Perelman.

Équations différentielles

- Dans l'étude des équations différentielles, Painlevé découvre de nouvelles transcendantes. Son étude est continuée par Gambier.

- Un mémoire de Dulac, de 1923, contient l'énoncé qu'un champ de vecteurs X à coefficients polynomiaux du plan possède au plus un nombre fini de cycles limites (un cycle limite est une courbe intégrale analytique fermée et isolée de X) qui suscitera beaucoup de travaux complémentaires avant de devenir le théorème de Dulac. À l'instar de nombre de théorèmes "démontrés", la démonstration fut contestée dans les années 1960. Celle de Dulac comportait des "trous" mis en évidence par des contre-exemples de Ilyashenko. Le théorème de Dulac devint la conjecture de Dulac. Puis la preuve fut complétée par Jean Ecalle et la conjecture de Dulac retrouva son statut de théorème sous la forme "Pour tout champs de vecteurs analytique dans le plan, les cycles limites ne s'accumulent pas".

Théorie des nombres

- La thèse de Cahen (1894) avait fait l'objet de nombreuses critiques. Ce fut l'occasion de nouvelles études dans les séries de Dirichlet et la théorie des fonctions L, particulièrement par Szolem Mandelbrojt.

- Robert Daniel Carmichael découvre les nombres de Carmichael en 1909. Il faut attendre 1994 pour que Alford, Granville et Pomerance démontrent qu'il y en a une infinité. Plus précisément, ces auteurs montrent que le nombre de nombres de Carmichael inférieurs à x, C(x), est minoré par C(x) > x2 / 7 à partir d'un certain rang. Divers auteurs ont donné des majorations de C(x).

- On s'attacha à simplifier les preuves du théorème des nombres premiers (Landau, Erdös et Selberg, ...) et celles du théorème de Picard (Borel). La fonction zêta de Riemann, dans le but de démontrer l'hypothèse de Riemann, est l'objet de très nombreuses recherches de Hardy et Littlewood, Speiser, Bohr, Hadamard, ... sans pour autant que le mystère ne soit résolu. Titchmarsh écrit en 1951 un traité sur la théorie de la fonction ζ de Riemann qui reste l'un des plus complets.

- Le problème de Waring est partiellement résolu par Hilbert en 1909 qui montre l'existence de g(k) tandis que Wieferich s'attaque à la détermination du plus petit g(k) pour un entier k donné. Le problème de la détermination de G(k) est commencé par Hardy et Littlewood qui énoncent même une conjecture non encore démontrée. Les majorations de G(k) données par Vinogradov ont été améliorées par Heilbronn (1936), Karatusba(1985), Wooley (1991). On connait les valeurs de G(k) pour k compris entre 2 et 20 par les travaux de Landau, Dickson, Wieferich, Hardy et Littlewood, ...Linnik donna une méthode de résolution du problème de Waring par une voie purement arithmétique en 1943, utilisant une idée de Schnirelmann.

- Viggo Brun démontre en 1919 la convergence de la série des inverses des nombres premiers jumeaux, en utilisant une méthode issue du crible de Erathostène-Legendre qui restera comme le crible de Brun, inaugurant la méthode du crible moderne qui se développe principalement avec Selberg.

- Une forme faible de la Conjecture de Goldbach est résolue par Vinogradov en 1936 en montrant que presque tous les nombres entiers impairs s'écrivent comme somme de trois nombres premiers.

- André Weil démontre l'hypothèse de Riemann pour les fonctions zeta locales en 1940 et énonce les conjectures qui portent son nom, qui sont démontrées dans le siècle.

- Pierre Deligne démontre, contre toute attente, la conjecture de Weil sur les valeurs propres des endomorphismes de Frobenius en géométrie algébrique

- Des travaux de Y. Hellegouarch lient dès les années 1960 le grand théorème de Fermat à l'arithmétique de courbes algébriques particulières, les courbes elliptiques, mais ce n'est qu'au milieu des années 1980, que Ken Ribet montre que démontrer la conjecture de Shimura-Taniyama-Weil (ou conjecture modulaire), qui affirme un lien précis entre les fonctions modulaires et les courbes elliptiques, entraînerait le grand théorème de Fermat. Au bout de sept ans de recherches, Andrew Wiles annonce en 1993, au cours d'une série de conférences sur les courbes elliptiques et leurs représentations lors d'un colloque à Cambridge, la démonstration de la conjecture de Taniyama-Shimura-Weil pour une large famille de courbes elliptiques (ce qui suffit pour le théorème de Fermat). Un problème technique retarde plusieurs mois la mise au point de la preuve, mais fin 1994, le grand théorème de Fermat est démontré. Peu après, la conjecture de Taniyama-Shimura-Weil est complètement démontrée.

Graphes

- Wegener et Brendan McKay, indépendamment, montrent qu'il existe plus de 13 267 364 410 532 solutions au problème du cavalier et Ernesto Mordecki, un mathématicien uruguayen, en 2001, a majoré le nombre des solutions à 1,305.10^35.

Analyse complexe

- La première véritable preuve du théorème de l'application conforme de Riemann (1851) est donnée par Constantin Carathéodory en 1912 en utilisant les surfaces de Riemann. Elle est bientôt simplifiée par Koebe. Une autre preuve est donnée en 1922 par Fejer et Riesz, elle-même simplifiée par Ostrowski et Carathéodory.

- Bieberbach, en 1916, va émettre une conjecture généralisant le lemme de Schwarz qui ne sera définitivement résolue que par Louis de Branges de Bourcia, après près de 70 ans de recherches, en 1985.

- Après la première guerre mondiale, la communauté mathématique française, qui avait perdu beaucoup de ses membres, se replia sur son sujet favori: l'analyse complexe et la théorie des fonctions analytiques dont elle était la principale instigatrice.

- La théorie des fonctions entières d'ordre infini est l'œuvre de Otto Blumenthal vers 1913.

- L'importance de la formule de Jensen s'affirme dans la théorie de la croissance initiée par Emile Borel.

Logique et théorie des ensembles

- Sur la question des fondements, les mathématiciens se disputent allègrement, et des branches apparaissent sous l'impulsion de Brouwer, de Henri Poincaré, ... Cependant la majorité de la communauté mathématique adhère à l'axiome du choix dont Kurt Gödel montrera en 1930 que, tout comme l'hypothèse du continu, il pouvait être ajouté aux axiomes de la théorie des ensembles de Zermelo-Fraenkel sans introduire de contradictions. En réalité, ces deux énoncés sont indépendants des autres axiomes: ce sont des propositions indécidables (Paul Cohen, 1963). Les démonstrations de non contradictions fleurissent (sous réserve de la non contradiction de la théorie des ensembles).

- Dans la théorie de la démonstration, on notera les travaux d'Herbrand (1930) et de Gentzen, trop vite décédés, le premier en 1931, le second en 1945.

- On s'était demandé si toute proposition vraie, dans une axiomatique donnée, pouvait être démontrée. La réponse est non. Le théorème d'incomplétude de Gödel (1931) énonce que toute théorie non contradictoire capable de formaliser l'arithmétique ne permet pas de démontrer toutes les propositions vraies. Autrement dit, il existe des tautologies indémontrables dans toute théorie capable de formaliser l'arithmétique ...

- Church invente le lambda calcul et énonce sa thèse, Turing invente la machine abstraite qui porte son nom et Kleene précise la définition des fonctions récursives. La notion de fonction calculable est inventée. Matiyasevich démontre qu'il n'existe pas d'algorithme qui permette de dire si une équation diophantienne est résoluble, donnant ainsi une réponse négative aux dixième problème de Hilbert. La théorie des automates et la théorie des langages apparaissent.

- Donald Knuth publie son encyclopédie sur l'art de la programmation et crée un nouvelle discipline l'analyse d'algorithmes.

Probabilités

- La notion de mesure développée par Émile Borel en 1897 est complétée par Henri-Léon Lebesgue et sa théorie de l'intégration. Cette notion d'analyse est utilisée par les probabilistes pour une définition plus rigoureuse de la probabilité et entre autres de la densité de probabilité

- La première version moderne du théorème central limite est donnée par Alexandre Liapounov en 1901 et la première preuve du théorème moderne donnée par Paul Lévy en 1910.

- En 1902, Andrei Markov introduit les chaînes de Markov pour entreprendre une généralisation de la loi des grands nombres pour une suite d'expériences dépendant les unes des autres. Ces chaînes de Markov connaîtront de nombreuses applications, entre autres pour modéliser la diffusion ou pour l'indexation de sites web sur Google.

- En 1933, la théorie des probabilités sort d'un ensemble de méthodes et d'exemples divers et devient une véritable théorie, axiomatisée par Kolmogorov.

- Kiyoshi Itō met en place une théorie et un lemme qui porte son nom dans les années 1940. Ceux-ci permettent de relier le calcul stochastique et les équations aux dérivées partielles faisant ainsi le lien entre analyse et probabilités. Le mathématicien Wolfgang Döblin avait de son côté ébauché une théorie similaire avant de se suicider à la défaite de son bataillon en juin 1940. Ses travaux furent envoyés à l'Académie des sciences dans un pli cacheté qui ne fut ouvert qu'en 2000.

Analyse numérique

- Richard Courant introduit les éléments finis en 1940 qui servent à la résolution numérique d'équations aux dérivées partielles. Cette méthode ne prendra véritablement son essor qu'avec l'informatique et des procédés de maillage performant et adaptés, ce qui n'apparaîtra pas avant les années 1980.

- La méthode de Monte-Carlo se développe, sous l'impulsion de John von Neumann et Stanislas Ulam notamment, lors de la Seconde Guerre mondiale et des recherches sur la fabrication de la bombe atomique. Elles sont dénommées ainsi par allusion aux jeux de hasard pratiqués à Monte-Carlo. Ces méthodes probabilistes servent à la résolution numérique d'équations aux dérivées partielles, d'équations différentielles stochastiques, et d'estimations d'intégrales multiples.

Paradoxes apparents et curiosités

- Si l'acceptation de l'axiome du choix permet de démontrer l'existence de bases dans les espaces vectoriels de dimension infinie, notamment les espaces de Hilbert, cela a aussi des conséquences plus étranges, comme le paradoxe de Banach-Tarski : il existe un découpage d'une sphère parfaite en cinq morceaux tel qu'avec les morceaux on puisse reconstituer deux sphères parfaites de même diamètre que la première.

- D'autres curiosités, comme le théorème du retournement de la sphère de Smale (qui utilise l'axiome du choix) sont démontrées.